Facebook、AI処理向けのモジュラーハードウェアプラットフォームとASICを発表:「Zion」と「King Canyon」

Facebookは2019年3月14日(米国時間)、OCP Summit 2019で、AIの訓練プロセスに最適化した新たなハードウェアプラットフォーム設計「Zion」、推論プロセスに最適化したASIC「King Canyon」を発表した。

Facebookは2019年3月14日(米国時間)、OCP Summit 2019で、AIの訓練プロセスに最適化した新たなハードウェアプラットフォーム設計「Zion」、推論プロセスに最適化したASIC「King Canyon」を発表した。同社はパートナーとの協業で、これらを推進していくという。併せて、ビデオトランスコーディング用のASIC設計も発表した。

AI訓練に特化したモジュラーシステムZion

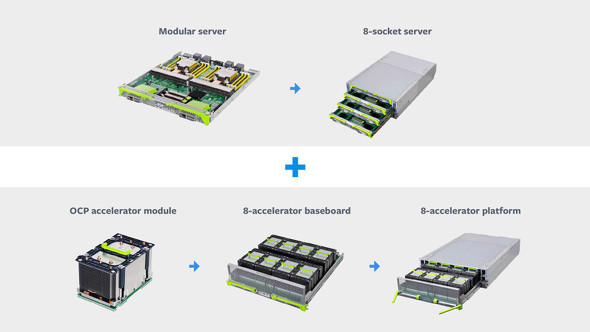

ZionはAIトレーニングに特化したモジュラー設計のハードウェアシステム。物理的には8ソケット構成のサーバと、Facebookが別途発表した「OCPアクセラレータモジュール」を8基搭載したシステムコンポーネントで構成される。単一ラック内で、これらのシステムをそれぞれ必要に応じて増やし、全体的なシステムを拡張できるようになっているという。

OCPアクセラレータモジュールとは、AI用途を想定したGPU、FPGA、ASICなどのアクセラレータのための新たなフォームファクタを提案するもの。現在のPCIe規格では、これからのAI処理に対応しきれないという考えから生まれている。上図左下のような、ヒートシンクを備えた箱型のモジュールのそれぞれに、複数のアクセラレータカードを装着できる。AMD、Habana、Graphcore、Intel、NVIDIAなどが協力しているという。

Zionでは、CPU、メモリ、ネットワークについて、個別に拡張できるようになっている。

「SparseNNの埋め込みテーブルのように大量のメモリを要するワークロードには、8基のNUMA CPUソケットと大量のDDRメモリプールを適用できる。CNNやSparseNNにおいて高いメモリ帯域幅と高い処理能力を要するワークロードでは、各CPUソケットに複数のOCPアクセラレータモジュールを接続できる」(Zionを説明したブログポストより、以下同)

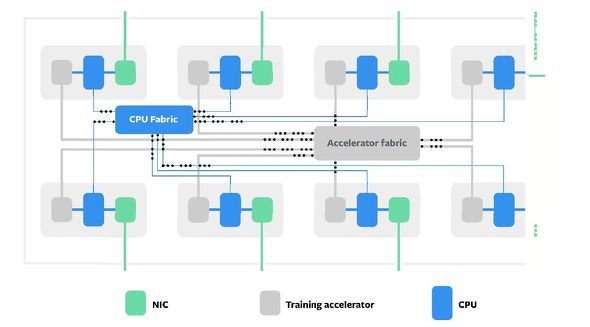

単一あるいは複数のサーバおよびOCPアクセラレータモジュールで構成されるシステムは、CPU間接続、アクセラレータ間接続の2つの高速ファブリックを備えるという。

「アクセラレータはメモリ帯域幅こそ広いものの、メモリ容量が小さいため、アクセス頻度の高いデータがアクセラレータ上に配置され、アクセス頻度の低いデータがDDRメモリに配置されるようにモデルを分割して、総メモリ容量を効果的に活用したい」

AI推論に特化したASIC、King Canyon

一方、FacebookはAIの推論プロセスでも処理負荷が急速に高まっており、一般的なCPUのサーバでは対応しきれなくなっているとする。このためEsperanto、Habana、Intel、Marvell、Qualcommと協力し、推論用ASICを開発することを明らかにした。これに「King Canyon」というコードネームをつけている。

こちらはM.2インタフェースで、OCPのYosemite規格のサーバに搭載することになるという。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ