番組視聴者数を秒単位で分析 テレビ東京のGCP活用事例:「つらいことはしない」(1/2 ページ)

テレビ東京では社内に構築していた視聴データ分析基盤を、Google BigQueryなどを活用して新たに構築し直した。なぜ、GCPを選んだのか。どのように視聴者数をリアルタイムに分析しているのか。テレビ東京でテックリードを務める段野祐一郎氏が語った。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

関東圏に向けてテレビ番組を放送するテレビ東京では、構築されていた視聴データ分析基盤を新たに「Google Cloud Platform」(GCP)のデータウェアハウス(DWH)サービス「Google BigQuery」(以下、BigQuery)やインメモリ型の分析サービス「BigQuery BI Engine」などを活用して構築し直した。

なぜ、GCPを選んだのか。どのように視聴者をリアルタイムに分析しているのか。2019年7月29〜31日に開かれた「Google Cloud Next Tokyo 2019」においてテレビ東京でテックリードを務める段野祐一郎氏が講演した内容を要約してお伝えする。

番組制作を支える視聴データと課題を抱えた分析基盤

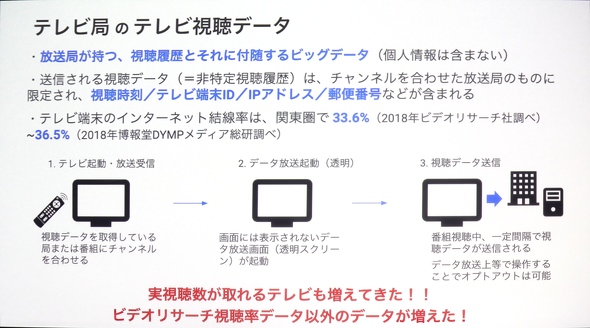

段野氏はテレビ視聴データがどう取得できるようになってきたのかについて説明する。

「従来はビデオリサーチの統計情報や、アンケートデータを用いて視聴データを収集してきた。だが、スマートフォンアプリの提供など、インターネットを通じた番組配信をきっかけに、自社で視聴データを取得できるようになった。視聴者を増やすにはどのような番組編成を考え、施策を打っていく必要があるか、データドリブンで判断することが求められている」

テレビ本体の進化もデータ取得を後押ししている。インターネットに接続されているテレビは、チャンネルを合わせた放送局に対し、「非特定視聴履歴」と呼ばれるデータを送信する。この履歴には、視聴時刻、テレビ端末ID、IPアドレス、郵便番号などが含まれるため、放送局側が視聴者数を予測して分析することが容易になってきている(データ放送メニューからこの視聴データを送らないように設定できる)。

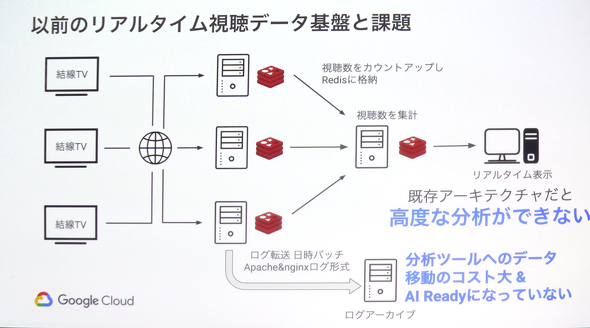

段野氏は社内の困りごとをITで解決すべく業務部門の“友軍部隊”として業務を進める中で、利用されていたリアルタイム視聴データ分析基盤に課題があることを知る。「スモールスタートで価値検証するところからでいいならやります」と手を上げてプロジェクトを始めた。

社内で利用されていたリアルタイム視聴データ分析基盤は、バッチ処理で各サーバに構築されているRedisから視聴数をカウントアップして集計用サーバのRedisに保存するものだ。視聴数だけカウントアップしていたので高度な分析ができないことと、より早く分析しようにも分析ツールへのデータ移動のコストが大きいことが課題になった。

GCPを活用する理由

開発に当たってはオンプレミスかクラウドか、内製か外注かを検討。結果、GCPのBigQueryやBigQuery BI Engineを採用して内製で開発した。段野氏は、なぜGCPを選択し、内製開発に取り組んだのか振り返る。

「目的を最短で達成するためには、インフラの制約に縛られたくない。サーバ、ミドルウェア、データベース(DB)などの構築やチューニング、冗長性、可用性の担保など、今回の目的であるスモールスタートで価値検証するために必要でない作業を回避したかった。さらに組織として予算と人が少ないという課題もあった。短期間で開発できて、運用負荷や維持費が低いという特性からパブリッククラウドを採用。2012年から業務部門がG Suiteを導入しており、Googleのサービスとの親和性が高いことなどからGCPを選択した。内製した理由は、データ処理、分析基盤の開発ということもあり、業務部門に活用してもらう中で、要件が増えると予想されたからだ。業務部門の要件に合わせて柔軟に改良しようと考えた」

関連記事

GCP大阪リージョンが運用開始、キュリアンCEOが日本企業に使ってほしい機能とは

GCP大阪リージョンが運用開始、キュリアンCEOが日本企業に使ってほしい機能とは

Google Cloudは2019年5月14日、Google Cloud Platform(GCP)の大阪リージョンを運用開始したと発表した。3ゾーン構成で、東京リージョンとほぼ同一のサービスを利用できるという。 100億行のデータをスプレッドシートで扱う機能など、Google Cloudのデータ関連発表をまとめた

100億行のデータをスプレッドシートで扱う機能など、Google Cloudのデータ関連発表をまとめた

Google Cloudは2019年4月10日(米国時間)にGoogle Cloud Next ‘19で大量の発表を行った。その中から、ストレージ、データベース、データ分析関連の主な発表をピックアップして簡潔に紹介する。 Google CloudはAnthosで「次のVMware」になろうとしている FFGはCloud Spannerで次世代銀行システムを開発

Google CloudはAnthosで「次のVMware」になろうとしている FFGはCloud Spannerで次世代銀行システムを開発

Google Cloudのイベント「Google Cloud Next Tokyo ’19」では、分散データベース「Cloud Spanner」の利用が、金融基幹システムにも広がりつつあることが示された。一方マルチクラウドコンテナ環境の「Anthos」でGoogle Cloudは、アプリケーションのモダナイゼーションツールとしての役割を強調した。Google CloudはAnthosで、「次のVMware」になろうとしている。

Copyright © ITmedia, Inc. All Rights Reserved.

テレビ東京 IT推進局 配信技術部 兼 総務人事局 人事部 段野祐一郎氏

テレビ東京 IT推進局 配信技術部 兼 総務人事局 人事部 段野祐一郎氏