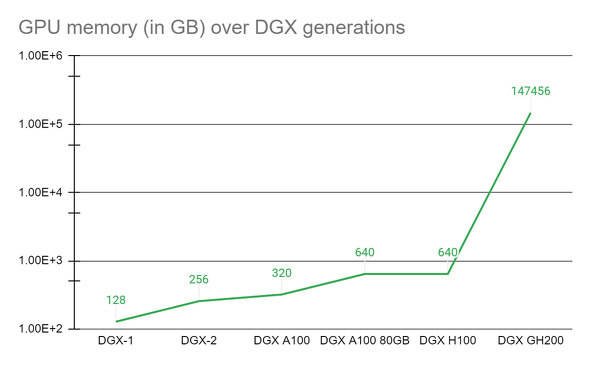

NVIDIA、メモリ144TBのAI用スパコン「NVIDIA DGX GH200」を発表:前世代と比較してほぼ500倍のメモリ容量に

NVIDIAは新しいクラスの大規模メモリを搭載したAI用スーパーコンピュータ「NVIDIA DGX GH200」を発表した。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

NVIDIAは2023年5月28日(米国時間)、新しいクラスの大規模メモリを搭載したAI(人工知能)用スーパーコンピュータ「NVIDIA DGX GH200」(以後、DGX GH200)を発表した。「NVIDIA GH200 Grace Hopper Superchip」と「NVIDIA NVLink Switch System」を搭載したNVIDIA DGXスーパーコンピュータは、生成AI言語アプリケーション、レコメンダーシステム、データ分析ワークロード用の巨大な次世代AIモデルの開発を可能にする。2023年末までに提供が開始される予定だ。

DGX GH200の大規模な共有メモリ空間は、NVLinkインターコネクトテクノロジーとNVLink Switch Systemを使用して、256基のGH200 Superchipを結合し、単一のGPUとして実行可能にする。これにより、1エクサFLOPSのパフォーマンスと144テラバイト(TB)の共有メモリが提供される。これは、2020年に発表された前世代の「NVIDIA DGX A100」システムのほぼ500倍のメモリ容量だ。

NVLinkによるAIの大規模な拡張

GH200 Superchipは、NVIDIA NVLink-C2Cチップインターコネクトを使用して、Armベースの「NVIDIA Grace CPU」と「NVIDIA H100 TensorコアGPU」を同じパッケージ内で組み合わせることで、従来のCPUとGPU間のPCIe接続を不要にしている。これにより、最新のPCIeテクノロジーと比べて、GPUとCPU間の帯域幅が7倍に増加し、インターコネクトの消費電力が5倍以上削減され、DGX GH200のために600GBのHopperアーキテクチャのGPUビルディングブロックを提供する。

DGX GH200は、Grace Hopper SuperchipとNVIDIA NVLink Switch Systemを組み合わせた初のスーパーコンピュータだ。これは、DGX GH200システム内の全てのGPUを1基のGPUとして連携できるようにする新しいインターコネクトだ。前世代のシステムでは、パフォーマンスを損なうことなく1基のGPUとして利用するには、8基のGPUをNVLinkで組み合わせることしかできなかった。

DGX GH200アーキテクチャは、前世代の48倍のNVLinkの帯域幅を提供し、単一のGPUをプログラミングする簡単さで大規模なAIスーパーコンピュータのパワーを実現する。

AIパイオニアのための研究ツール

DGX GH200をいち早く導入する予定の企業には、Google Cloud、Meta、Microsoftが含まれる。これら3社はDGX GH200で生成AIワークロードの機能を探索しようとしている。またNVIDIAは、クラウドサービスプロバイダーなどのハイパースケーラーにDGX GH200のデザインを設計図として提供し、各社が自社インフラに合わせてカスタマイズできるようにする計画だ。

NVIDIAは自社の研究者や開発チームの作業の基盤として、DGX GH200ベースの独自のAIスーパーコンピュータを構築している。「NVIDIA Helios」と呼ばれるこのスーパーコンピュータは、4つのDGX GH200システムを搭載する。

各システムは、最大400Gbpsの帯域幅を備えた「NVIDIA Quantum-2 InfiniBand」ネットワーキングで相互接続され、大規模なAIモデルをトレーニングするためのデータスループットを強化する。Heliosは1024基のGrace Hopper Superchip を搭載し、年末までに稼働を開始する予定だ。

大規模AIワークロードを支援するフルスタックのNVIDIAソフトウェア

DGX GH200には、最大規模のAIおよびデータ分析ワークロードにターンキーのフルスタックソリューションを提供する以下のNVIDIAソフトウェアが含まれている。

NVIDIA Base Command

AIワークフロー管理、エンタープライズグレードのクラスタ管理、コンピューティング、ストレージ、ネットワークインフラを高速化するライブラリ、AIワークロードの実行に最適化されたシステムソフトウェアを提供する。

NVIDIA AI Enterprise

NVIDIA AIプラットフォームのソフトウェアレイヤー。生成AI、コンピュータビジョン、音声AIといった本番AIの開発とデプロイ(展開)を効率化する100を超えるフレームワーク、事前トレーニング済みモデル、開発ツールを提供する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.