IBM、「大規模音声モデル(LSM)」のクローズドβ版を公開:英語と日本語に対応

IBMは、大規模言語モデル(LLM)を音声ベースの会話に応用した「大規模音声モデル(LSM)」のクローズドβ版を公開した。

» 2024年01月25日 11時00分 公開

[@IT]

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

IBMは2024年1月3日(米国時間)、英語と日本語に対応した「大規模音声モデル(LSM:Large Speech Models)」のクローズドβ版を公開した。

同社のAIプラットフォーム「IBM watsonx」の開発チームとIBM Researchは、大規模言語モデル(LLM)のベースであるTransformerを用いて、大量のトレーニングデータとモデルパラメーターを使用し、LSMの精度を向上させてきたという。

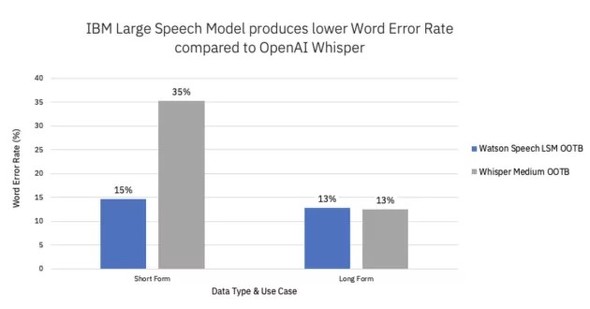

IBMによると、OpenAIの音声認識モデル「Whisper(medium.en)」と比較してパラメーター数は5分の1であり、実際の顧客との通話(英語)に基づくパフォーマンスのベンチマーク比較では、LSMの単語誤り率(WER:Word Error Rate)が42%低かったとしている。

IBMは「Whisperは音声を30秒ごとに区切って処理するため、無音部分でも処理が実行される。一方、LSMは音声終了とともに処理も終了するため、30秒未満のオーディオファイルを処理するタスクで、特に効果を発揮する」と述べている。

IBMはLSMのユースケースとして、電話を用いたセルフサービスのアシスタントやリアルタイムによる書き起こしが必要なカスタマーサービスを挙げている。

関連記事

IBM、生成AI基盤モデル追加で「watsonx」を強化 何が変わるのか

IBM、生成AI基盤モデル追加で「watsonx」を強化 何が変わるのか

IBMは、ビジネス向けAIデータプラットフォーム「watosonx」に、拡張可能な生成AI基盤モデルを追加したと発表した。 2024年の「AI/機械学習/データ分析」はこうなる! 7大予測

2024年の「AI/機械学習/データ分析」はこうなる! 7大予測

昨年2023年は、ChatGPTやGoogle BardなどのチャットAIに注目が集まり、企業やサービスに生成AIが導入されていくなど、大きな変化が一気に起こりました。今年2024年の「AI/機械学習/データ分析/データサイエンス」かいわいはどう変わっていくのか? 現状を踏まえつつ、未来を予測します。 OpenAI、「ChatGPT」のチーム向け有料プラン「ChatGPT Team」を提供開始

OpenAI、「ChatGPT」のチーム向け有料プラン「ChatGPT Team」を提供開始

OpenAIは、対話型AIサービス「ChatGPT」のチーム向け有料プラン「ChatGPT Team」を提供開始した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

SpecialPR

アイティメディアからのお知らせ

スポンサーからのお知らせPR

SpecialPR

システム開発ノウハウ 【発注ナビ】PR

あなたにおすすめの記事PR