OpenAI、動画生成AI「Sora」を発表 技術レポートで明かされる開発ビジョン、学習の仕組み、課題とは:「物理世界の汎用(はんよう)シミュレーター構築に向けた有望なステップ」

OpenAIは、テキストから最大60秒の動画を生成するAIモデル「Sora」を発表した。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

OpenAIは2024年2月15日(米国時間)、テキストから最大60秒の動画を生成するAI(人工知能)モデル「Sora」を発表した。

Soraは、複数のキャラクターや特定の種類の動き、細部まで正確に表現された被写体、背景がある複雑なシーンを生成できる。ユーザーがプロンプト(指示)で要求したものだけでなく、それらが物理世界にどのように存在するかも理解しているとしている。

SoraのWebページでは、Soraによって生成された非常にリアルなさまざまな動画がそれぞれのテキストプロンプトとともに公開されている。

OpenAIは現在、Soraをレッドチーマー(誤った情報、憎悪に満ちたコンテンツ、偏見などの分野の専門家)に、危険やリスクの評価用に提供している。また、多くのビジュアルアーティスト、デザイナー、映画製作者にもアクセスを許可している。クリエイティブの専門家に最も役立つSoraの改良方法について、フィードバックを得たい考えだ。

OpenAIは、こうしたフィードバックを踏まえるとともに、レッドチーマーとの協力によるテストを経て、重要な安全対策を講じた上で、SoraをOpenAI製品で利用できるようにする計画だ。

また、SoraをOpenAI製品に展開する場合は、Soraによって生成された動画にC2PA(Coalition for Content Provenance and Authenticity)メタデータを含ませることで、Soraによって生成されたことが識別できるようにするとしている。

Soraの開発ビジョン

OpenAIは、現実世界との相互作用を必要とする問題の解決に役立つモデルをトレーニングすることを目標に、動く物理世界を理解し、シミュレートするようにAIを教育している。

Soraの発表に合わせて公開した技術レポート「Video generation models as world simulators」(世界シミュレーターとしての動画生成モデル)では、「Soraが現在持っている能力は、動画生成モデルのスケーリングを継続することが、物理およびデジタル世界とその中に存在するモノ、生きる動物、人間の優れたシミュレーターの開発に向けた有望な道であることを示していると考えている」と述べている。

同レポートによると、動画データの生成モデリングに関する先行研究では、リカレントネットワーク、生成的敵対ネットワーク(GAN)、自己回帰トランスフォーマー、拡散モデルなど、さまざまな手法が用いられてきた。

だが、これらの取り組みは、視覚データの狭いカテゴリーや、より短い映像、一定サイズの動画に焦点を当てることが多い。OpenAIは「Soraは視覚データのジェネラリストモデルであり、さまざまな時間、アスペクト比、解像度にわたる動画や画像を生成でき、最大60秒の高精細動画の生成が可能だ」と述べている。

同レポートでは、「(1)あらゆる視覚データを、生成モデルの大規模トレーニングを実現する統一的な表現に変換するOpenAIの手法」「(2)Soraの能力と限界」を説明している。その概要は以下の通り。

あらゆる視覚データを、生成モデルの大規模トレーニング用の統一的な表現に変換する手法

視覚データをパッチに変換

大規模言語モデル(LLM)は、インターネットスケールのデータでトレーニングすることでジェネラリスト機能を獲得しており、LLMパラダイムの成功の一因は、テキストの多様なモダリティ(コード、数学、さまざまな自然言語)を統合するトークンの採用にある。

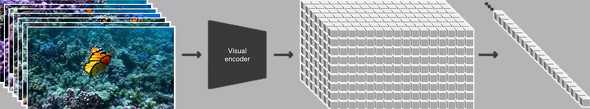

Soraではこれをヒントに、動画や画像を「パッチ」という小さなデータ単位の集まりとして表現している。データの表現方法を統一することで、さまざまな時間、解像度、アスペクト比にわたる、これまでより幅広い視覚データで拡散トランスフォーマーをトレーニングできる。

動画圧縮ネットワーク

このネットワークは、生の動画を入力として取り、時間的、空間的に圧縮された潜在表現を出力する。Soraは、この圧縮された潜在空間内でトレーニングされ、その後動画を生成する。また、生成された潜在表現をピクセル空間にマップする、対応するデコーダーモデルのトレーニングも行われる。

時空間潜在パッチ

圧縮された入力動画が与えられると、トランスフォーマートークンとして機能する時空間パッチのシーケンスを抽出する。画像は1フレームの動画なので、この方式は画像にも有効だ。このパッチベースの表現により、Soraはさまざまな解像度、時間、アスペクト比の動画や画像でトレーニングできる。推論時には、ランダムに初期化されたパッチを適切なサイズのグリッドに配置することで、生成される動画のサイズを制御できる。

Soraの能力

スケーリングによって動画を生成するトランスフォーマー

Soraは拡散モデルであり、静止ノイズのように見えるものから、何段階にもわたってノイズを除去し、徐々に変換を行って動画を生成する。ノイズの多い入力パッチ(と、テキストプロンプトのような条件情報)を与えられると、元の「クリーンな」パッチを予測するようにトレーニングされる。GPTモデルと同様に、トランスフォーマーアーキテクチャを採用しており、優れたスケーリングパフォーマンスを発揮する。

さまざまな時間、解像度、アスペクト比への対応

ネイティブサイズの動画でトレーニングすることで、以下のメリットが得られることが分かった。

サンプリングの柔軟性

Soraは、横長の1920×1080p動画、縦長の1080×1920動画、その中間の動画をサンプリングできる。これにより、さまざまなデバイス向けのコンテンツをネイティブのアスペクト比で直接生成できる。

フレーミングと構図の改善

ネイティブアスペクト比の動画でトレーニングすることで、構図とフレーミングが改善されることが経験的に分かっている。生成モデルのトレーニングでは一般的に、トレーニング用の全ての動画を正方形にトリミングするが、こうした動画でトレーニングした生成モデルは、被写体が一部しか映っていない動画を生成する場合がある(上)。これに対し、ネイティブアスペクト比の動画でトレーニングしたSoraの生成動画は、フレーミングが改善されている(下)。

言語理解

テキストから動画を生成するシステムのトレーニングでは、テキストキャプション付きの大量の動画が必要になる。OpenAIは「DALL-E 3」で導入した再キャプション化技術を動画に適用した。

まず、非常に説明的なキャプションを生成するモデルをトレーニングし、それを使って、Soraのトレーニングデータセットに含まれる全ての動画のテキストキャプションを生成させた。

非常に説明的な動画キャプションでトレーニングすることで、生成動画のテキストに対する忠実度や、動画の全体的な品質が向上したという。

また、OpenAIはDALL-E 3と同様に、GPTを活用し、短いユーザープロンプトを長い詳細なキャプションに変換し、Soraに送信している。これにより、Soraはユーザープロンプトに正確に従った高品質の動画を生成できる。

画像や動画から別の動画を生成

Soraでは、テキストだけでなく、既存の画像や動画をプロンプトとして与えることもできる。そのため、Soraは画像や動画の編集にも利用できる。完璧なループ動画の作成、静止画のアニメーション化、動画の時間的な前後への拡張、テキストプロンプトからの動画編集、被写体やシーン構成が全く異なる動画のシームレスな接続などが可能だ。

画像の生成

Soraは、最大2048×2048pの画像を生成することもできる。

新しいシミュレーション機能

Soraは、物理世界の人、動物、環境のさまざまな側面をシミュレートできる。例えば、以下のような特徴を持つ動画を生成できる。

- カメラの移動や回転に応じて、3D空間で人物やシーンの要素が自然に移動する

- 長い動画の中で時間的な一貫性を維持するという動画生成システムの重要課題に対処している。被写体が一時的にフレームから外れても、その存在を維持できる。また、1つのサンプルで同じキャラクターの複数のショットを生成し、動画全体を通してその外観を維持することもできる

- 単純な方法で世界の状態に影響を与えるアクションをシミュレートする(画家がキャンバスに描き加える、人物がハンバーガーをかじるなど)

- ビデオゲームなど人工的なプロセスをシミュレートする

Soraの限界

現在のSoraは、シミュレーターとしてさまざまな制約がある。例えば、ガラスコップが割れるなど、人やモノの多くの基本的な相互作用の物理現象を正しくシミュレートしない。原因と結果の具体例を理解していない場合もあり、例えば、人がクッキーをかじった後で、クッキーにその跡がないかもしれない。

SoraのWebページでは、長時間のサンプルで不整合が発生したり、オブジェクトが不意に現れたりするなど、動画生成の他の一般的な失敗例が示されている。

関連記事

Stability AI、動画生成AI「Stable Video Diffusion」のAPIを公開

Stability AI、動画生成AI「Stable Video Diffusion」のAPIを公開

Stability AIは、同社が提供するDeveloper Platformで「Stable Video Diffusion」のAPIを公開した。 Microsoft Copilotの基本的な設定と使い方

Microsoft Copilotの基本的な設定と使い方

Windows OSには、「Microsoft Copilot」や「Copilot in Windows」といった無料で利用可能な生成AI機能が実装されている。これらを活用することで仕事の効率化を図ることができる。本稿では、活用する前段階として、Microsoft Copilotを使う方法や設定などについて紹介しておこう。 2024年の「AI/機械学習/データ分析」はこうなる! 7大予測

2024年の「AI/機械学習/データ分析」はこうなる! 7大予測

昨年2023年は、ChatGPTやGoogle BardなどのチャットAIに注目が集まり、企業やサービスに生成AIが導入されていくなど、大きな変化が一気に起こりました。今年2024年の「AI/機械学習/データ分析/データサイエンス」かいわいはどう変わっていくのか? 現状を踏まえつつ、未来を予測します。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ