生成AIのグラウンディング(Grounding)とは?:AI・機械学習の用語辞典

用語「グラウンディング」について説明。特定の知識や情報源(ナレッジベースなど)に基づいて言語モデルの生成内容を裏付けるプロセスのことで、チャットAIに独自の情報源を付与するRAG(検索拡張生成)という仕組みがその代表例。チャットAIがもっともらしいウソを答える問題(=ハルシネーション)を減らせるといったメリットがある。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

用語解説

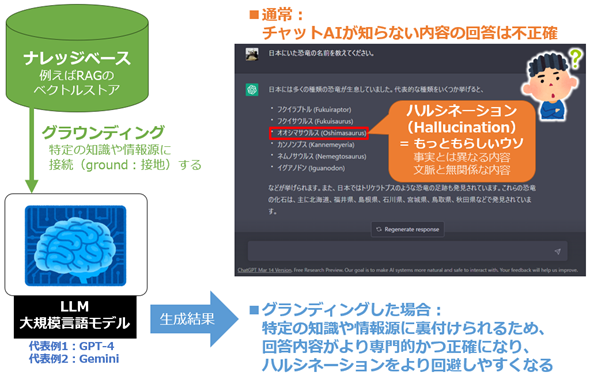

生成系AI/LLM(大規模言語モデル)の文脈においてグラウンディング(Grounding)とは、特定の知識や情報源(例えばナレッジベースなど)に接続(=接地:ground)することで、言語モデルの回答や生成内容を裏付けるプロセスを指す。ChatGPTやGeminiに代表されるチャットAIに独自の情報源を付与するRAG(Retrieval-Augmented Generation:検索拡張生成)という仕組みがあるが、まさにそのプロセスがグラウンディングの一例だ。

グラウンディングによって、LLMが生成する回答内容がより専門的かつ正確になるため、事実とは異なる内容や文脈と無関係な内容の出力がもっともらしく生成される問題(=ハルシネーション:Hallucination)をより回避しやすくなるというメリットがある。

グラウンディングの情報源としては、意味的に関連する情報を見つけ出すベクトル検索ができるベクトルデータベース/ベクトルストアが、RAGの仕組みの中でよく用いられる。

筆者の体感で「グラウンディング」という用語は、Googleが好んで用いている。例えば「Vertex AI Embeddings for Textで実現するLLMのグラウンディング」というGoogle Cloud公式ブログ記事などの資料がある。もちろん他の企業などで用いられることもあり、例えばこちらのMicrosoftのブログ記事「Grounding LLMs」などの資料がある。

Copyright© Digital Advantage Corp. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ