Google製の“軽量でも高性能”なオープン埋め込みモデル「EmbeddingGemma」登場 オフライン動作で、手元の文書検索に最適:Deep Insider Brief ― 技術の“今”にひと言コメント

オンデバイス(端末内)動作に最適化された埋め込みAIモデルが新登場。スマートフォンやPC上でネット接続なしに、プライバシーを守りつつ、手元の文書から高精度な文書検索やRAG(検索拡張生成)が実現できる。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

Googleは2025年9月4日、新しい埋め込みモデル「EmbeddingGemma」(エンベディング・ジェマ)を発表した。このモデルは、特にスマートフォンやタブレット、ノートPC、デスクトップPCなどのオンデバイス(端末上)で動作させる目的で設計されており、軽量クラス(500M=5億パラメーター未満)で最高レベルの性能を達成している。

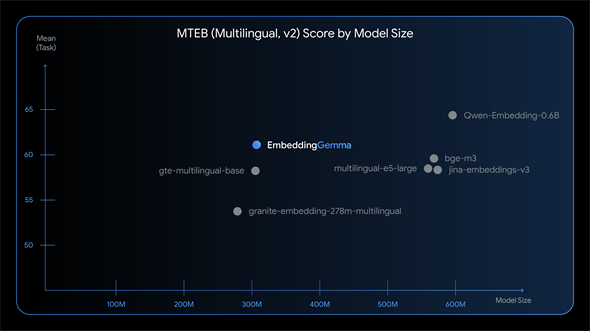

EmbeddingGemmaのMTEBベンチマーク性能比較(公式発表資料より引用)

EmbeddingGemmaのMTEBベンチマーク性能比較(公式発表資料より引用)横軸はモデルサイズ(パラメーター数)、縦軸はMTEBベンチマーク(埋め込みモデルの性能を多面的に評価する国際的指標)の平均スコア。EmbeddingGemma(青点)は、約2倍のサイズを持つ人気モデル群(bge-m3やjina-embeddings-v3など)と比べても同等以上の性能を示している。

EmbeddingGemmaは、「Gemma 3」モデルをベースとして作られた、オープンウェイト(=学習済みの重みが公開されており誰でも利用できる)モデルだ。そのサイズは308M(=3億800万)パラメーターと小さく、Gemma 3シリーズの中でも特に“軽量”なのが特徴である。例えばGemma 3で最大の27B(=270億)パラメーターと比べると、98.9%も小さい。

これにより、インターネット接続がないオフライン環境でも、プライバシーを守りながら高品質なテキスト埋め込み(=文章の意味を数値ベクトルに変換したもの)を生成できる。この埋め込みは主に意味に基づく情報検索で使われ、とりわけRAG(検索拡張生成)に不可欠だ。RAGとは、ユーザーの質問に関連する文書をまず検索し、その結果を基に生成AIが正確な回答を作る仕組みである。EmbeddingGemmaはこの最初の「検索」段階を支える役割を担い、回答全体の質に大きく影響を与える。

高品質な情報検索やRAGが全てデバイス内で完結するため、ユーザーデータを外部に送信せずに済み、プライバシーを守れる。さらに通信を介さないため、高速な応答が可能になるというメリットもある。

――ここからは『Deep Insider Brief』恒例の“ひと言コメント”として、今回の動きから技術の“今”を少し深く見ていく。

Deep Insider編集長の一色です。こんにちは。

EmbeddingGemmaは、ローカルLLMで情報検索やRAGを構築しようとする開発者や企業にとって、注目のモデルだと思います。端末内で動作し(オンデバイス)、ネット接続がなくても使える(オフライン)という特徴は、やっぱり魅力的ですね。

私自身も、Kaggle(AI・データ分析の競技プラットフォーム)で実際に動かしてみましたが、Webブラウザから5分ほどで動かせたので、試すのはとても簡単でした。Kaggle登録者であれば、

のがお勧めです。他にも、

から利用できます。

今回のリリース内容には、モデルの技術的詳細や、関連ツールとの連携など多くの情報が含まれていた。これらを丁寧に解説すると長くなるので、残りは以下に箇条書きでまとめておく。

その他の特徴

モデルの特徴

- パラメーター数は合計308Mで、その内訳は「モデル部分が約100M」+「埋め込み部分が約200M」

- 多言語に対応: 100以上の言語で学習しており、幅広い言語を扱える

- 長い文章に対応: 2Kトークン(目安としておおよそ2000語程度をイメージするとよい)の入力コンテキストを持つため、それなりに長いテキストを処理できる

- 高速な推論: GoogleのEdgeTPU(エッジデバイス向けのAI専用チップ)上では、256トークンの入力に対し15ミリ秒未満という高速な処理を実現

- 柔軟な出力サイズ:

- MRL(Matryoshka Representation Learning)という技術により、1つのモデルから768次元の高品質なベクトルだけでなく、用途に応じて512、256、128次元のより小さなベクトルを切り出して利用できる(マトリョーシカ人形のように、必要に応じて中身を取り出すイメージ)

- これにより、開発者は「品質」と「速度」と「ストレージコスト」のバランスを自由に調整できる

- オンデバイス、かつオフラインに最適化された設計:

- 量子化(モデルを軽量化する技術)を適用することで、200MB以下のRAM(作業用メモリ)でも動作可能

- テキスト処理には「Gemma 3n」モデルと同じトークナイザ(文章を単語などの単位に分割するツール)を使用しており、RAGアプリケーションでのメモリ消費を抑える

- 豊富なツールとの連携

- LangChain、LlamaIndex、Ollama、LM Studio、llama.cpp、MLX、LiteRT、Sentence Transformers、Transformers.js、Weaviate、Cloudflareなど、コミュニティで人気の主要AI開発ツールに既に対応済みで、導入が容易

モデルの種類

以下の3種類のモデルが提供されている。なお、モデル名の「unquantized」は「量子化前の配布形式」を指すが、Ollamaなど多くのツールやコミュニティが量子化済みモデル(GGUF形式など)を提供しているため、ユーザー自身が変換する必要はほとんどない。また、モデル名の「300m」は「308M」を分かりやすく丸めた表記である。

- embeddinggemma-300m: 基本となる標準モデル。量子化が施されていないオリジナルのバージョンで、最も高い精度を持つ。ファインチューニング(追加学習)の基盤としても利用できる

- embeddinggemma-300m-qat-q8_0-unquantized: 8ビット整数(int8)での利用に最適化されたモデル。「量子化を意識した学習(QAT)」という手法で訓練されており、軽量化による精度低下を最小限に抑えている。実際に利用する際のファイルサイズと精度のバランスに優れている

- embeddinggemma-300m-qat-q4_0-unquantized: 4ビット整数(int4)での利用に最適化されたモデル。8ビット版よりもさらにファイルサイズが小さく高速に動作するが、ごくわずかに精度が低下する可能性がある。最もメモリや計算資源が限られた環境向け

用途に応じた埋め込みモデルの使い分け

Googleには「Gemini Embedding」という埋め込みモデルが既に存在するので、これとの使い分け指針も示されている。

- オンデバイス、オフラインでの利用: プライバシー、速度、効率が重視される場面ではEmbeddingGemmaが最適

- 大規模なサーバサイドでの利用: 最高の品質と性能が求められる場合は、Gemini API経由で利用できるGemini Embeddingモデルを推奨

オフラインで動作する軽量の埋め込みモデル「EmbeddingGemma」の登場で、ローカルLLMの活用範囲がさらに拡大した。今後、エッジAI環境でもRAGや情報検索がどこまで普及するかに注目したい。

情報元

Copyright© Digital Advantage Corp. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ