米Microsoftの超巨大な“AI工場”構築進む 第2の巨大AI専用DCを開設

Microsoftは米国に2番目のAI専用データセンターを開設した。これにより、世界最初の「AIスーパーファクトリー」を実現したという。DC同士は専用WANで高速・低遅延に接続され、あたかも単一のスーパーコンピューターであるかのように機能する。DCはどのような設計になっているのか。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

米MicrosoftはAI(人工知能)専用データセンター(以下、DC)群の展開を進めている。2025年10月にはジョージア州アトランタで稼働を開始した。これは2025年9月に発表したウィスコンシン州フェアウォーターのDCに続く第2弾。世界で初の「AIスーパーファクトリー」を実現したとする。

「AIスーパーファクトリーと呼ぶ理由は、単一の複雑なジョブを数百万におよぶハードウェアにまたがって処理できるからだ。AIモデルを1か所でトレーニングするというだけではない。この単一のジョブを複数拠点のネットワークで処理できる」(Microsoftのブログポスト)

Microsoftは新DCファミリーを、第1号施設の所在地から「Fairwater」と名付けている。このファミリーでは、AIモデルの構築に最適化した同一の設計を採用している。それぞれ巨大な拠点だが、相互を専用の光ファイバー網で接続することで、超巨大な単一スーパーコンピューターを構成する。

アトランタのデータセンターは世界最速のスーパーコンピューターと比較して10倍のパフォーマンスを提供すると、Microsoftクラウド/AIグループ上席副社長のスコット・ガスリー氏は説明する。

「AIモデルにおける次の波を加速するには、こうした大規模な変革が必要だ。AI能力におけるブレークスルーとAIインフラの進化は、合わせてAIコストの指数関数的な低下ももたらす」(ガスリー氏)

Fairwaterシリーズの設計では、密度とスケーラビリティー、利用効率に着目し、さまざまな工夫を凝らしている。

GPU密度を高めるため2階建ての構造に

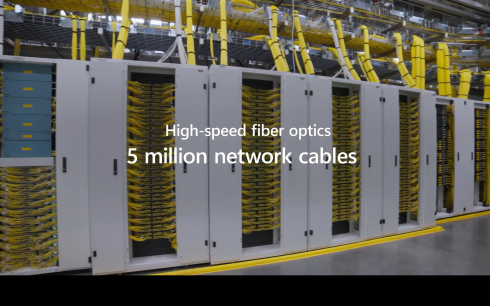

Fairwater DC群の施設は2階建て設計となっている。2階建てにすることで、ラックを3次元的に配置し、ケーブル長を最小限に抑えることができる。レイテンシー、帯域幅、信頼性、コストの点での改善により、GPUの設置密度を高めるという。ただし、ネットワークケーブルや冷却パイプの引き回し、2階部分の重量への対応で設計上の工夫が必要だった。

アトランタ州のDCは約120万平方フィート(11万平方メートル)。Blackwell GPUを数十万基収容できる。GPUは「NVIDIA GB200 NVL72」ラックスケールシステムとして設置している。各ラックには最大で72基の「NVIDIA Blackwell GPU」が収容される。GPUはNVLinkを介した低レイテンシーの通信によってメモリを共有する。

ラックをまたがった通信では2層のイーサネットネットワークを構成、800Gbpsで接続する。自社が生み出したオープンソースのネットワークOSであるSONiCの活用でベンダーロックインを回避するとともに、ホワイトボックススイッチによってコストを抑えているという。

ソフトウェア的な改善も組み込まれている。「packet spray」(パケット単位での経路分散)「Packet Trimming」(輻輳<ふくそう>時に受信側がタイムアウトを待たずに再送信要求)といった技術に改善を加えて利用しているという。

Fairwater DC群の「高度な」液冷システムとは

DCにおける計算密度を高める上で不可欠なのは熱対策だ。Fairwater DC群では液体冷却により、この課題の解決を図っている。配管、ポンプ、チラーの設計と配置における工夫により、世界最大級規模のチラーシステムを効率的に運用しているという。Fairwater DCはラック当たり約140kW、列当たり1360kWに対応する冷却能力を備えると説明している。

この液冷システムは閉ループ設計。液体は循環的に再利用される。液体は、化学的性質の変化に伴って必要となる6年程度の間隔の交換を除いては、補填したり入れ替えたりする必要がないという。

初期充てん水量が少ない点もMicrosoftはアピールしている。アトランタDCについては、20世帯の年間消費量に相当する量だけで済んでいるという。

ウィスコンシン州拠点では液冷と外気冷却を併用しているが、90%以上が液冷に依存しているとしている。

複数AI DCをつなぐWANは自社光ファイバー網を活用

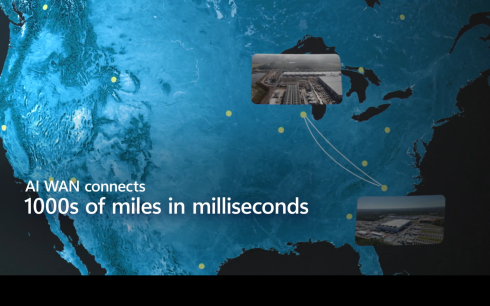

Microsoftは複数のFairwater DCを専用の光ファイバー網で接続し、単一のスーパーコンピューターとして構成する。

「FairwaterのDCは次世代フロンティアモデルの学習に最適だが、同時に『代替可能性』も念頭に置いて構築されている。トレーニングは単一で巨大なジョブから、プリトレーニング、ファインチューニング、強化学習、合成データ生成など、要求の異なるさまざまなワークロードへと進化してきた。Microsoftは、各Fairwaterサイトをより広範で弾力的なシステムに統合するために専用のAI WANバックボーンを展開し、多様なAIワークロードを動的に割り当てることで、全体のGPU利用率を最大化できる」(Microsoftのブログポスト)

分散DCの統合利用は、複数世代にわたるGPUの効率的な活用にもつながる。

先端的なAIモデルのトレーニングジョブにおける計算ニーズには単一施設で対応できず、複数の施設・地域にまたがるトレーニングが必要。このためMicrosoftは「AI WAN」と呼ぶAI専用WANでFairwater DC間を接続するという。これには同社が米国に展開している自社の新設・既設光ファイバーケーブルを活用する。2024年だけで19万kmを敷設したという。

Microsoftは、Fairwater DCファミリーの今後の展開に関する具体的な詳細を明らかにしていない(ウィスコンシン州にはあと1拠点を建設すると発表)。だが、「最終的には全米各地に建設するDCをAI WANで接続する」と表現している。また、AI WANにより、将来は大陸をまたぎ、既存のAzureデータセンターをニーズに応じて組み合わせて使えるようになると説明している。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ

アトランタのDC。中央に見えるのはチラーシステム群(Microsoft Ignite 2025基調講演より)

アトランタのDC。中央に見えるのはチラーシステム群(Microsoft Ignite 2025基調講演より) アトランタDCの内部(Microsoft Ignite 2025基調講演より)

アトランタDCの内部(Microsoft Ignite 2025基調講演より) フェアウォーターDCとアトランタDCを1000km以上の長さの専用光ファイバー網で接続(Microsoft Ignite 2025基調講演より)

フェアウォーターDCとアトランタDCを1000km以上の長さの専用光ファイバー網で接続(Microsoft Ignite 2025基調講演より)