コンテキストの腐敗(Context Rot)とは?:AI・機械学習の用語辞典

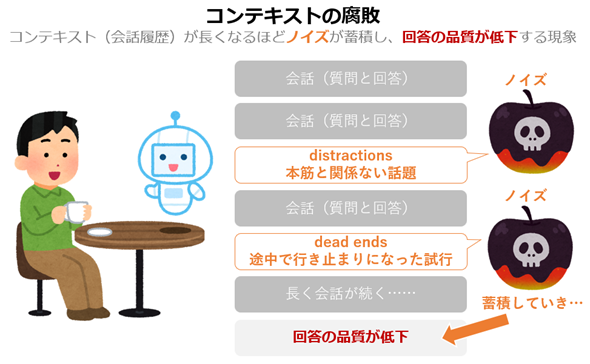

AIモデルとの対話が長く続く中で、「本筋とは無関係な話題」や「途中で行き止まりになった試行」といったノイズがコンテキスト内に蓄積し、その結果として出力品質が急速に低下していく現象。やり取りが進むほど回答が乱れたり、急に話がかみ合わなくなったりする際の主因と考えられる。

用語解説

コンテキストの腐敗(Context Rot)とは、LLM(大規模言語モデル)との対話やタスクが長く続く中で、コンテキスト(文脈、つまり会話履歴)の量が増えるほど「本筋とは無関係な話題(distractions)」や「途中で行き止まりになった試行(dead ends)」といったノイズが蓄積し、それに伴って出力品質が急速に低下していく現象である。コンテキストが肥大化するにつれて、モデルの推論(inference)はノイズに引きずられやすくなり、回答の正確性や一貫性が大きく損なわれる(図1)。最新のロングコンテキスト対応モデルであっても、この問題が依然として避けられない場合も多い。

この用語は、2025年6月に米国の人気技術掲示板「Hacker News」に寄せられた、Workaccount2氏の投稿をきっかけに広まった。同氏は、コンテキストの腐敗を次のように表現している(参考:Hacker Newsのスレッド)。

原文:They poison their own context. Maybe you can call it context rot, where as context grows and especially if it grows with lots of distractions and dead ends, the output quality falls off rapidly. Even with good context the rot will start to become apparent around 100k tokens (with Gemini 2.5).

翻訳:LLMは自分自身のコンテキストを汚染してしまう。これを「コンテキストの腐敗」と呼んでもよいだろう。コンテキストが長くなるにつれて、特に寄り道(distractions)や行き止まり(dead ends)がたくさん混ざった状態で肥大化していくと、出力品質は急速に低下する。たとえ良質なコンテキストであっても、(Gemini 2.5では)およそ10万トークン辺りから腐敗が目に見えて現れ始める。

この現象は、実務者コミュニティーで広く共有されつつあるだけでなく、専門組織による分析でも裏付けられている。ベクトルデータベースを提供する米国企業Chromaの研究部門「Chroma Research」は、入力トークン数の増加に伴う性能劣化を実証的に示した技術レポートを公開しており(Context Rot: How Increasing Input Tokens Impacts LLM Performance)、複数のLLMで“コンテキストが長くなるほど品質が低下する”現象が共通して観察されることを報告している。

さらに、AIモデル開発企業Anthropicも、長いコンテキストを扱うAIエージェントでは、情報が混在してモデルが混乱しやすくなる点を指摘しており、その対処として、必要な情報を選び出して整理し、モデルが扱いやすい形に整える「コンテキストエンジニアリング」の具体的な実践方法を紹介している(AIエージェントのための効果的なコンテキストエンジニアリング)。こうした技術的知見からも、コンテキストの腐敗はLLMの本質的課題として認識されつつある。

従来、LLMにおける課題の一つとして「コンテキストウィンドウのサイズ(扱える最大トークン数)」の制約が指摘されることは多かった。しかし、コンテキストの腐敗という現象は、「ウィンドウ内に収まっていれば問題ない」という前提が成り立たないことを示している。すなわち、上限以内であってもコンテキストの質が劣化すれば、モデルは容易に性能を損なう。LLMの限界を“量”だけでなく“質”の観点から捉える必要があることを明らかにした点で、この概念は重要である。

最近では、LLM自身がコンテキストを圧縮しながら思考(リーズニング)を進める技術が一般化しつつある。このような機能は、長い対話や複雑なタスクで発生しがちな混乱や品質低下を緩和する仕組みとして活用され始めており、大量のコンテキストを扱う際に生じる課題への一つの対応策となりつつある。とはいえ、コンテキストの腐敗という現象そのものをユーザーが理解しておくことは、AIをより安定して利用する上で今後も重要な視点となり得るだろう。

Copyright© Digital Advantage Corp. All Rights Reserved.