MapRの最新版「5.2.1」、Spark 2.1との連携を強化した「MapR Ecosystem Pack 3.0」がリリース:Sparkのセキュリティ機能強化、MapR-DBとHBaseへ接続対応、Hiveの高速化など

マップアール・テクノロジーズはビッグデータ解析に向けたデータ基盤の最新版「MapR 5.2.1」および「MapR Ecosystem Pack 3.0」をリリース。安定性、パフォーマンス、セキュリティ機能を強化した。

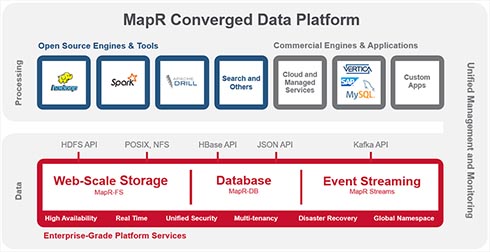

マップアール・テクノロジーズは2017年5月15日、ビッグデータ解析に向けたデータ基盤「MapRコンバージド・データ・プラットフォーム」の最新版「MapR 5.2.1」と、同基盤上で利用する際の互換性を保証したオープンソースソフトウェアを集めた「MapR Ecosystem Pack(MEP)」の最新版「MEP 3.0」の提供を開始すると発表した。

MapRコンバージド・データ・プラットフォームは、大規模データの分散バッチ処理基盤の「Apache Hadoop」やデータのリアルタイム処理基盤「Apache Spark」、NoSQLデータベース「MapR-DB」、カラム型分散データベース「Apache HBase」、データ処理基盤「Apache Drill」、Hadoop向けのデータウェアハウス構築基盤「Apache Hive」、ストリーム処理基板「MapR Streams」などを含めたプラットフォーム。Apache Sparkは「2.1.0」にバージョンが上がり、主に安定性やセキュリティを強化。データ型API(Application Programming Interface)を安定化させ、前バージョンで発見された1200以上のバグが修正されている。この他、Spark ThriftサーバやHiveメタストアに接続する際の認証プロトコルとして、Kerberosに加えてMapR-SASLにも対応した。

また、SparkとHBaseを接続するコネクターは、SparkでMapR-DBのバイナリテーブルに書き込めるように改善された。MapR-DBへの一括挿入や、Spark SQLでのMapR-DB検索が可能となっている。

Apache Drillは「1.10」にバージョンが上がり、BI(Business Intelligence)ツールを最適化した他、エンドポイントのセキュリティや処理性能、操作性も改善されている。例えば、データ可視化ツール「Tableau」にネイティブ接続できるようにし、TEMPORARY TABLE AS(CTTAS)コマンドなどに対応。その他、前バージョンで見つかった約110個のバグも修正されている。

Apache Hiveは「2.1.1」にバージョンが上がり、データタスクの処理速度が高められた。インタラクティブクエリの待ち時間を短縮し、バッチクエリの処理性能も向上させている。

なお、MapR 5.2.1では、MapR Streamsに対応するアプリケーションをC言語またはPython言語で開発できる。それぞれ、「MapR Streams C Client」または「MapR Streams Python client」を利用し、どちらも、分散メッセージング基盤である「Apache Kafka」を利用する。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

SAP、インメモリ分析プラットフォームの最新版「HANA Vora 1.3」を発表

SAP、インメモリ分析プラットフォームの最新版「HANA Vora 1.3」を発表

SAPジャパンが、Hadoop向けインメモリ分析プラットフォームの最新版「SAP HANA Vora 1.3」の提供を開始。MapRやレノボと共同で、SAP HANA Vora 1.3とHadoopを用いたインメモリデータ分析基盤のレファレンスガイドも提供する。 MapR、Docker向けの統合データ基盤「MapR Converged Data Platform for Docker」を発表

MapR、Docker向けの統合データ基盤「MapR Converged Data Platform for Docker」を発表

MapRがDocker対応の統合データ基盤「MapR Converged Data Platform for Docker」を発表。コンテナアプリケーションの開発/運用で課題となる「データの永続性の欠如」に対応した。 マイクロソフト、ビッグデータ解析プラットフォーム「Microsoft R Server 9.0」をリリース

マイクロソフト、ビッグデータ解析プラットフォーム「Microsoft R Server 9.0」をリリース

マイクロソフトが最新のオープンソースRエンジンをベースに機能を強化したビッグデータ解析プラットフォーム「Microsoft R Server 9.0」をリリース。より高度な予測分析ができるように機能を強化した。 「素のHadoop」をインストールして、簡単な処理を実行する

「素のHadoop」をインストールして、簡単な処理を実行する

実際にHadoopで処理を実装していきながら「Hadoopは、誰にだって扱える」を体感しましょう。今回は「実際にHadoopをインストール」し、基礎処理である「ワードカウント」を実行するまでを解説します。