「NVIDIA GPU Cloud(NGC)」が「Microsoft Azure」をサポート:NVIDIA GPUに最適化されたコンテナをAzureで実行

「NVIDIA GPU Cloud(NGC)」のサポート対象プラットフォームに「Microsoft Azure」が加わった。NGCのコンテナレジストリで提供されるGPUアクセラレーテッドコンテナを、NVIDIA GPUを搭載するAzureの3つのインスタンスタイプで実行できるようになった。

NVIDIAは2018年8月29日(米国時間)、同社のGPU対応クラウドプラットフォーム「NVIDIA GPU Cloud(NGC)」のサポート対象プラットフォームに「Microsoft Azure」が加わったことを明らかにした。

これにより、NGCのコンテナレジストリで提供される35種類のGPUアクセラレーテッドコンテナが、NVIDIA GPUを搭載するAzureの3つのインスタンスタイプで実行できるようになった。

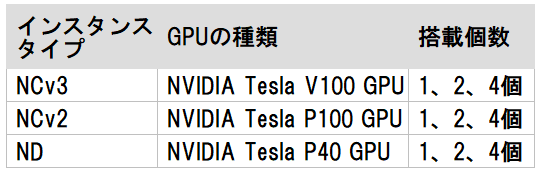

Azureのインスタンスタイプは以下の図の通り。

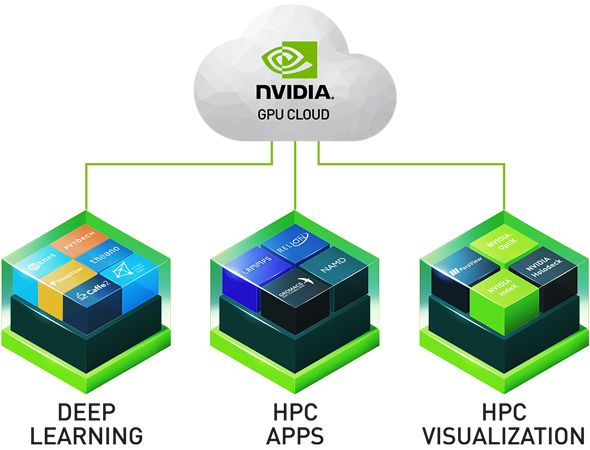

NGCのコンテナレジストリで提供されるコンテナの種類は複数ある。NVIDIAがチューニング、テスト、動作確認を済ませたディープラーニングソフトウェアのコンテナや、HPC(ハイパフォーマンスコンピューティング)用の完全にテストされたGPUアクセラレーテッドアプリケーション、ビジュアライゼーション(視覚化)ツールのコンテナなどだ。

こうしたディープラーニングソフトウェアは、「Microsoft Cognitive Toolkit」「TensorFlow」「PyTorch」「NVIDIA TensorRT」といったフレームワークも含まれる。

NVIDIAは広範な統合とテストの結果、各フレームワークに最適なソフトウェアスタック(必要なOSパッチ、NVIDIAディープラーニングライブラリ、「NVIDIA CUDA Toolkit」などを含む)を構築することで、こうしたディープラーニングソフトウェアのコンテナがNVIDIA GPUをフルに活用できるようにした。さらにディープラーニングコンテナは、ソフトウェアとコンポーネントの最新のアップデートにより、毎月更新される。

デプロイが容易でAzure仮想マシンもある

また、NGCでコンテナが提供されるGPUアクセラレーテッドアプリケーション、ビジュアライゼーションツールは、「NAMD」「GROMACS」「LAMMPS」「ParaView」「VMD」を含む。これらのコンテナはユーザーのデプロイを容易にし迅速な立ち上げを助け、最新機能を利用できるようにする。

また、AzureではこうしたNGCコンテナをユーザーが簡単に使えるように、Azure Marketplaceで「NVIDIA GPU Cloud Image for Deep Learning and HPC」という新しいイメージを提供する。これは、NGCコンテナの実行に必要な要素を完備した構成済みのAzure仮想マシンだ。

AzureでNGCコンテナを実行するには、NVIDIAが公開しているこのイメージを使う以外の方法もある。Azure NCv2、NCv3、ND仮想マシンから「Azure Batch AI」を使って、NGCコンテナをダウンロードして実行することだ。

NVIDIAは、NGCのAzureサポートにより、多くの開発者、データサイエンティスト、研究者が、GPUコンピューティングプロジェクトを素早く開始できるようになったと述べている。

関連記事

「Google Cloud Platform」で「NVIDIA Tesla V100 GPU」の正式提供を開始

「Google Cloud Platform」で「NVIDIA Tesla V100 GPU」の正式提供を開始

Googleは、「Google Cloud Platform」に含まれる「Compute Engine」「Kubernetes Engine」「Cloud Machine Learning Engine」「Cloud Dataproc」において、NVLinkをサポートする「NVIDIA Tesla V100 GPU」の正式提供を開始した。 リリース当初と比べてコンテナ数が3倍以上に――NVIDIAが「NVIDIA GPU Cloud(NGC)」で利用できるHPCコンテナを拡充

リリース当初と比べてコンテナ数が3倍以上に――NVIDIAが「NVIDIA GPU Cloud(NGC)」で利用できるHPCコンテナを拡充

NVIDIAのGPU対応クラウドプラットフォーム「NVIDIA GPU Cloud(NGC)」で利用できるディープラーニングやHPC、可視化といった分野のソフトウェアコンテナ数が、NGCのリリース当初と比べて3倍以上の35個に増えた。 なぜ人工知能研究でNVIDIAのGPUが使われるのか――安くて速いGeForceが尊ばれる理由

なぜ人工知能研究でNVIDIAのGPUが使われるのか――安くて速いGeForceが尊ばれる理由

最近、人工知能(AI)の研究開発における「計算」の分野でGPUメーカーNVIDIAの名前を見掛ける機会が増えた。グラフィックの表示を行うGPUが、なぜAI研究の計算で活躍するのかを、AIについてズブの素人である筆者が、超初心者目線で取材し、調べ、まとめた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ

NVIDIA GPU Cloudのコンテナレジストリでは、ディープラーニングソフトウェアのコンテナとHPCコンテナが提供される(出典:

NVIDIA GPU Cloudのコンテナレジストリでは、ディープラーニングソフトウェアのコンテナとHPCコンテナが提供される(出典: