NVIDIA、AI推論プラットフォーム「NVIDIA TensorRT Hyperscale Inference Platform」を発表:Tesla T4 GPU、TensorRT 5、TensorRT推論サーバなどでデータセンターを構成

NVIDIAは、音声や動画、画像、レコメンデーションサービス向けに高度な推論アクセラレーションを実現するAIデータセンタープラットフォーム「NVIDIA TensorRT Hyperscale Inference Platform」を発表した。

NVIDIAは2018年9月12日(米国時間)、音声や動画、画像、レコメンデーションサービス向けに極めて高度な推論アクセラレーションを実現するAIデータセンタープラットフォーム「NVIDIA TensorRT Hyperscale Inference Platform」を発表した。

TensorRT Hyperscale Inference Platformは、NVIDIAが画期的だと主張する「NVIDIA Turing」アーキテクチャに基づく推論アクセラレータ「NVIDIA Tesla T4 GPU」と、新しい包括的な推論ソフトウェアセットを含む。

Tesla T4 GPUは、CPUのみの場合と比べて最大40倍高速にクエリを処理し、推論ソフトウェアはリアルタイム推論に対応している。同GPUを採用することで、データセンターのスループットとサーバ使用率の最大化を目指した。

この結果、エンドツーエンドのアプリケーションで高いパフォーマンスを低いレイテンシで提供できるという。このため、同プラットフォームを採用したハイパースケールデータセンターでは、高度な自然言語応答や、検索に対して答えを直接提供するといった新しいサービスを提供できると、NVIDIAは述べている。同社は、5年後にはAI推論市場が200億ドル規模に成長すると推計しており、同プラットフォームはこの成長に寄与できるという。

TensorRT Hyperscale Inference Platformの主な3つの構成要素は次の通り。

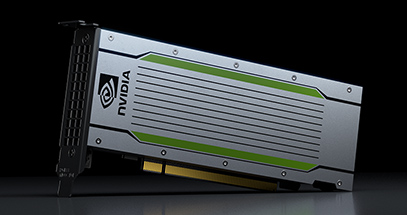

NVIDIA Tesla T4 GPU

NVIDIA Tesla T4 GPUは、320個の「Turing Tensor Core」と2560個の「CUDA」コアを備え、画期的なパフォーマンスとFP32、FP16、INT8、INT4での柔軟な多精度の推論機能を提供する。FP16でのピーク性能が65TFLOPS、INT8が130TFLOPS、INT4が260TFLOPS。

消費電力は75ワットであり、省電力型をうたう。パッケージはほとんどのサーバに組み込み可能な小型PCIeフォームファクタとなっている。

NVIDIA TensorRT 5

NVIDIA TensorRT 5は、推論の最適化を行うランタイムエンジン。Turing Tensor Coreに対応し、多精度ワークロードでニューラルネットワークの一連の最適化を拡張する。

NVIDIA TensorRT推論サーバ

NVIDIA TensorRT推論サーバは、コンテナ化されたマイクロサービスソフトウェアであり、アプリケーションがデータセンターの本番環境でAIモデルを利用できるようにする。

「NVIDIA GPU Cloud」のコンテナレジストリから無料で入手でき、データセンターのスループットとGPUの使用率を最大化し、広く普及したAIモデルおよびフレームワークを全てサポートする。「Kubernetes」や「Docker」とも連携可能だ。

関連記事

なぜ人工知能研究でNVIDIAのGPUが使われるのか――安くて速いGeForceが尊ばれる理由

なぜ人工知能研究でNVIDIAのGPUが使われるのか――安くて速いGeForceが尊ばれる理由

最近、人工知能(AI)の研究開発における「計算」の分野でGPUメーカーNVIDIAの名前を見掛ける機会が増えた。グラフィックの表示を行うGPUが、なぜAI研究の計算で活躍するのかを、AIについてズブの素人である筆者が、超初心者目線で取材し、調べ、まとめた。 「Google Cloud Platform」で「NVIDIA Tesla V100 GPU」の正式提供を開始

「Google Cloud Platform」で「NVIDIA Tesla V100 GPU」の正式提供を開始

Googleは、「Google Cloud Platform」に含まれる「Compute Engine」「Kubernetes Engine」「Cloud Machine Learning Engine」「Cloud Dataproc」において、NVLinkをサポートする「NVIDIA Tesla V100 GPU」の正式提供を開始した。 「NVIDIA GPU Cloud(NGC)」が「Microsoft Azure」をサポート

「NVIDIA GPU Cloud(NGC)」が「Microsoft Azure」をサポート

「NVIDIA GPU Cloud(NGC)」のサポート対象プラットフォームに「Microsoft Azure」が加わった。NGCのコンテナレジストリで提供されるGPUアクセラレーテッドコンテナを、NVIDIA GPUを搭載するAzureの3つのインスタンスタイプで実行できるようになった。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

NVIDIA Tesla T4 GPU(

NVIDIA Tesla T4 GPU(