機械学習アルゴリズムに見えない課題あり、米大学の研究者が指摘:AIというブラックボックス解明に一役

メリーランド大学のコンピュータサイエンス研究グループが、機械学習アルゴリズムを改善するための新しい有望なアプローチを開発した。意味のない入力に対して、回答しないアルゴリズムが必要なのだという。

米メリーランド大学は2018年11月5日(米国時間)、同大学のコンピュータサイエンスの研究グループが、機械学習アルゴリズムを解釈するための新しい有望なアプローチを開発したと発表した。ベルギーのブリュッセルで開催された「2018 Conference on Empirical Methods in Natural Language Processing」で同大学の准教授であるJordan Boyd-Graber氏が率いる研究チームが発表した「Pathologies of Neural Models Make Interpretation Difficult」を要約した内容だ。

機械学習アルゴリズムは現在、スペルミスの自動修正から新しい楽曲を推薦することまで、幅広い用途に活用されているが、誤った答えを出す場合もある。そうした場合、原因の把握は難しい。多くの機械学習アルゴリズムは、教師データを使って学習し、仮想の“ブラックボックス”内で予測を行うことから、その過程をたどる手掛かりがほとんど残らないからだ。

メリーランド大学の研究は、機械学習アルゴリズムが誤った答えを出す原因の理解と、信頼性の高いアルゴリズムの作成に貢献する。Boyd-Graber氏は研究アプローチを次のように説明している。

「ブラックボックスモデルが誤った答えや無意味な答えを返した場合、原因を理解するのは難しい。そこでわれわれは、正しい答えを得るための最小限の入力を見つけようとした。平均して約3単語の入力で正しい答えが得られたが、1つの単語でうまくいく場合もあった」

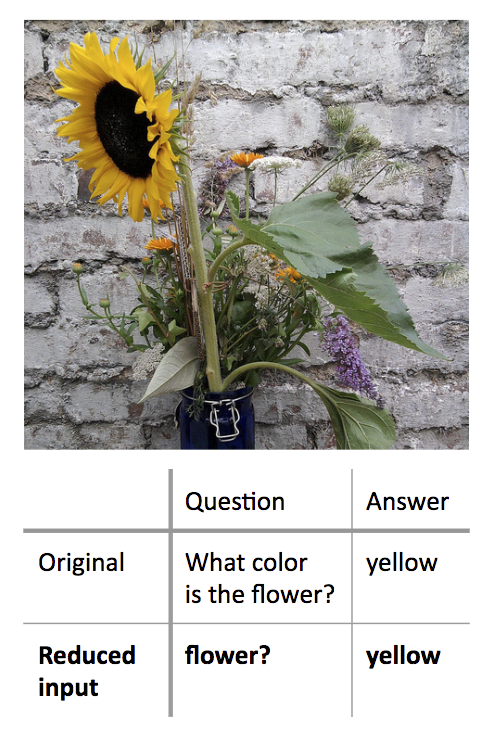

ある例では、研究者はひまわりの写真と質問テキスト「What color is the flower?」(花の色は何?)の両方をモデルアルゴリズムに入力したところ、「yellow」(黄色)という正しい答えが得られた。この質問をより短く言い換えたものを幾つか入力した後で、テキストとして「flower?」(花?)とだけ入力すると、やはり同じ答えが得られた。

より複雑な別の例では、研究者は、まず次のようなテキスト入力を与えた。

「In 1899, John Jacob Astor IV invested $100,000 for Tesla to further develop and produce a new lighting system. Instead, Tesla used the money to fund his Colorado Springs experiments.」(1899年にジョン・ジェイコブ・アスター四世は、新しい照明システムの開発と生産のために、テスラに10万ドルを投資した。テスラはその資金をコロラドスプリングス実験に充てた)

その後、「What did Tesla spend Astor’s money on?」(テスラはアスターの資金を何に使ったか?)という質問をアルゴリズムに入力し、「Colorado Springs experiments」(コロラドスプリングス実験)という正しい答えを得た。さらに、入力を「did」という1単語に縮めても、同じ正しい答えを得た。

「無意味な質問には答えない」ことが重要

これらの結果は、機械学習アルゴリズムが問題解決に適用するルールに関して、重要な洞察を提供する。機械学習アルゴリズムの問題点の多くは、人間にとって意味のある入力に対して、無意味な答えが返ってきてしまうというものだ。研究グループは、その逆の場合、つまり無意味な入力に対して、意味のある正しい答えが返されることもあり得ることを示した。こうすることで、「無意味な質問が与えられた場合に、質問が無意味なことを高い確度で認識できるアルゴリズムの必要性」を実証した。

「結局のところ、優秀に見える機械学習アルゴリズムも、実際は非常に愚かだということだ。コンピュータサイエンティストがこうしたモデルをトレーニングするとき、通常は意味のある質問や文を入力として渡す。意味のないフレーズや1つの単語を入力として使うことはない。こうした入力例に対しては、うまく回答できないことが正しいのだと、モデルが学習する機会はない」と、Boyd-Graber氏は説明する。

研究者によると、ほとんどの機械学習アルゴリズムは、不十分なデータや、矛盾するデータに対しても、無理やり答えを出そうとするという。研究に使われるアルゴリズムでも、既に実用化されているさまざまなアルゴリズムでも、機械学習アルゴリズムが誤った、あるいは無意味な出力を生成する場合の一部は、こうした動作が大きく関係している可能性がある。このようなエラーに対する理解を深めれば、解決策の発見や、信頼性の高いアルゴリズムの構築に役立つという。

「われわれは、うまく回答できない場合があることを理解するよう、モデルをトレーニングできることを証明した。こうしたトレーニングにより、モデルは、質問の意味が『理解できない』という意思表示ができるようになる」と、Boyd-Graber氏は述べている。

関連記事

MITの研究チーム、画像内のオブジェクトを音声によって識別する機械学習システムを開発

MITの研究チーム、画像内のオブジェクトを音声によって識別する機械学習システムを開発

マサチューセッツ工科大学(MIT)の研究者チームは、画像内のオブジェクトを画像の音声説明に基づいて識別する機械学習システムを開発した。「Siri」などとは異なり、あらかじめ何千時間分もの音声録音の文字起こしを必要とせず、話者の少ない言語にも拡張しやすい。 Recurrent Neural Networkとは何か、他のニューラルネットワークと何が違うのか

Recurrent Neural Networkとは何か、他のニューラルネットワークと何が違うのか

本連載では、Deep Learningの中でも、時系列データを扱うRecurrent Neural Networkについて解説。加えて、その応用方法として原稿校正(誤字脱字の検知)の自動化について解説します。 LSTMとResidual Learningでも難しい「助詞の検出」精度を改善した探索アルゴリズムとは

LSTMとResidual Learningでも難しい「助詞の検出」精度を改善した探索アルゴリズムとは

本連載では、Deep Learningの中でも、時系列データを扱うRecurrent Neural Networkについて解説。加えて、その応用方法として原稿校正(誤字脱字の検知)の自動化について解説します。今回は、Long Short Term MemoryとResidual Learningの概要、「助詞の検出」精度を改善した探索アルゴリズムについて。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ

研究チームは「質問」の単語数を減らした場合の機械学習アルゴリズムの応答を調べた(

研究チームは「質問」の単語数を減らした場合の機械学習アルゴリズムの応答を調べた(