AI/機械学習の品質保証が抱える課題に開発者はどう対応すべきか:「QA4AIガイドライン」とは(2/2 ページ)

1つの軸としてまとめられた「QA4AIガイドライン」

続けて石川氏は、QA4AIが2019年5月、37社の企業の協力を得てまとめた「QA4AIガイドライン」を紹介した。

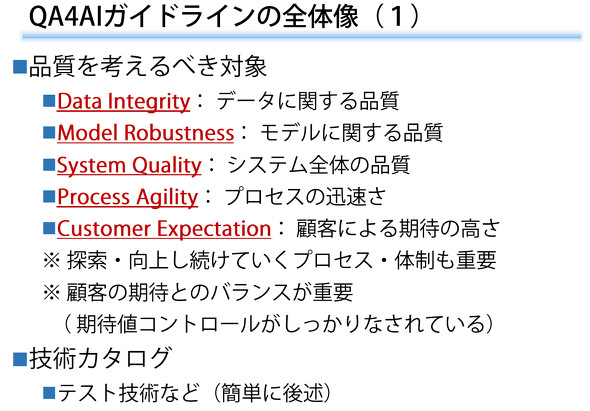

このガイドラインでは品質を確認する対象として、おかしなノイズが入っていないか、外れ値が処理されているかという観点を検証する「データ」、精度はもちろん、訓練データと違うものに対して対応できるか、ノイズを受けても動きが壊れていないかを測る「モデル」、挙動が説明できるかも含め、全体の品質を測る「システム全体」、不確実性を前提に、状況が変わったときに速やかに対応できるかを見る「プロセスアジリティ」、そして「1割は外す」ということをどう受け止めるかという「顧客による期待の高さ・考え方」という5つを想定している。

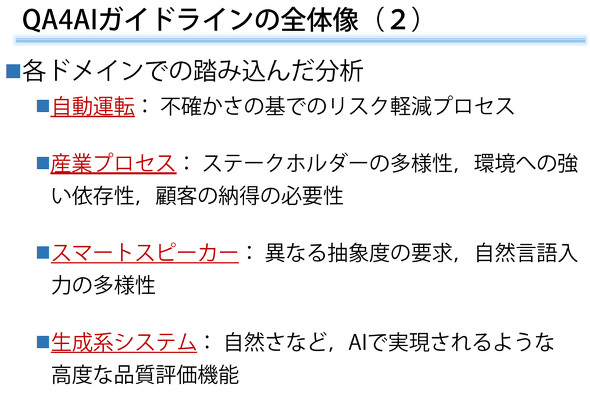

まだ最初のバージョンではあるがこういった形で「軸」を整備し、今後も適宜アップデートしていく方針だ。並行して、「機械学習全般を同じように評価するのは難しい」ことから、特定のドメインに踏み込んだ分析も実施し、まず自動運転、産業プロセス、スマートスピーカー、生成系システムという4つのドメイン向けに成果物を作成。有志の活動をベースに、他のドメインでの活動も進んでいるという。

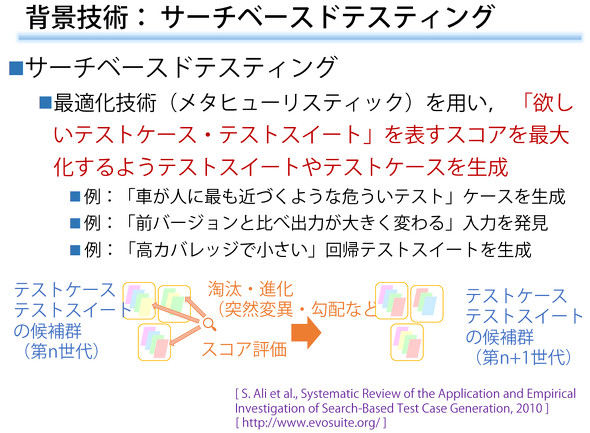

「唯一の正解がなかったり、正解を用意するのが大変だったりする上に、10分の1は自然に外す」――そんなあやふやな技術に対して、単体テストのような過去のアプローチは適用できない。そこで例えば、入力値の変化に伴って想定される出力値の変化を元に、あらかじめ答え(期待値)を用意できないようなテストを実施する「メタモルフィックテスティング」や、テストをある種の生き物として捉え、テストどうしの淘汰(とうた)、進化を通して、「欲しいテストケース、テストスイート」を表すスコアを最大化するようなテストケース、テストスイートを生成する「サーチベースドテスティング」といった考え方を発展させた新しい手法が追求されているという。

最後に石川氏は、「機械学習の開発は、『やってみないと分からない』ものを開発し、やってみた結果に基づいて意思決定し、動かしていく中で監視していくという具合に、今までのシステム開発とは全然違うことを、経営層や利用者もぜひ理解し、開発者に丸投げしないでほしい。人の営みに踏み込んだシステムを作るに当たって、こうした課題は避けられない」と呼び掛け、その上で、技術的にもポリシー的にも、ともに楽しみ、突き詰めていきたいとした。

関連記事

はてなのMackerelが明かす、機械学習プロジェクトに潜む2つの「不確実性の山」を乗り越えるコツ

はてなのMackerelが明かす、機械学習プロジェクトに潜む2つの「不確実性の山」を乗り越えるコツ

2019年8月29〜31日に開催された「builderscon tokyo 2019」のセッション「われわれはいかにして機械学習プロジェクトのマネージメントをすべきか」で、はてなの「Mackerel」のディレクターが機械学習技術の開発における「不確実性」のマネジメント術を説明した。 機械学習を活用して見えないインフラ障害を検知――九州のISPサービスを担う、QTnet運用エンジニアの挑戦

機械学習を活用して見えないインフラ障害を検知――九州のISPサービスを担う、QTnet運用エンジニアの挑戦

九州のISPサービスを担う、QTnet運用エンジニア木村氏は、ITインフラの監視に機械学習を活用し、これまで見えていなかった異常の検知や予測に取り組んでいる。「機械学習に関しては、ほぼど素人の取り組みだが、ソフトウェア開発に活用する際のヒントになれば」と謙遜しながら、その歩みを紹介した。 及川卓也×山田誠二対談「機械が人に合わせる」時代から「人が機械に合わせる」時代へ――エンジニアのシンギュラリティーを考える

及川卓也×山田誠二対談「機械が人に合わせる」時代から「人が機械に合わせる」時代へ――エンジニアのシンギュラリティーを考える

システム開発現場の在り方はAIや機械学習によってどのように変わるのか――@ITソフトウェア品質向上セミナーの特別講演「AI/機械学習、自動化で開発現場にも訪れるシンギュラリティーにどう備えるか」で、フリーランス エンジニアリング・プロダクトアドバイザーの及川卓也氏と、長年AIの研究に携わる国立情報学研究所教授の山田誠二氏が対談した。

Copyright © ITmedia, Inc. All Rights Reserved.