Stability AI、「LLaMA」ベースのオープンLLM「FreeWilly」を発表:一部のタスクでは「GPT-3.5」をしのぐパフォーマンスを発揮

Stability AIと同社のCarperAIラボは、オープンにアクセスできる新しい大規模言語モデル(LLM)「FreeWilly1」とその後継の「FreeWilly2」を発表した。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

画像生成AI「Stable Diffusion」を開発するStability AIと同社のCarperAIラボは2023年7月21日(米国時間)、オープンにアクセスできる新しい大規模言語モデル(LLM)「FreeWilly1」とその後継の「FreeWilly2」を発表した。両モデルとも、さまざまなベンチマークで優れた推論能力を発揮したとしている。

FreeWilly1は、基盤モデル「LLaMA 65B」を利用したもので、教師ありファインチューニング(Supervised Fine Tuning:SFT)で合成的に生成された標準的なAlpaca形式の新しいデータセットでファインチューニングされた。

同様に、FreeWilly2は基盤モデル「LLaMA 2 70B」を利用したもので、一部のタスクではOpenAIのLLM「GPT-3.5」をしのぐパフォーマンスに達している。

どちらのモデルも研究実験を目的としており、非商用ライセンスの下でオープンな研究を促進するために公開されている。

Stability AIによると、FreeWillyモデルのトレーニング方法は、Microsoftが論文「Orca: Progressive Learning from Complex Explanation Traces of GPT-4」で開拓した方法論に直接触発されている。ただし、Stability AIのデータ生成プロセスは似ているが、データソースは異なっているという。

Stability AIが使用したデータセットのバリエーションは、60万データポイントを含んでおり(Orca論文で使用されたデータセットサイズの約10%にとどまる)、機械学習エンジニアのエンリコ・シポル氏が作成した「COT Submix Original」「NIV2 Submix Original」「FLAN 2021 Submix Original」「T0 Submix Original」というデータセットから高品質の指示を言語モデルに与えることで作成された。

Orcaのオリジナル論文の10分の1のサンプルサイズでトレーニングし、同論文と比べて、モデルのトレーニングに伴うコストとカーボンフットプリント(温室効果ガス排出量)を大幅に削減したにもかかわらず、FreeWillyモデルはさまざまなベンチマークにおいて、優れたパフォーマンスを示し、合成生成データセットに対するStability AIのアプローチの妥当性を証明したと、同社は述べている。

パフォーマンス評価

Stability AIは、FreeWillyモデルを社内で評価するために、非営利の研究ハブであるEleutherAIのパフォーマンス評価ツール「lm-eval-harness」を使用し、それに「AGIEval」を追加した。AGIEvalは、人間の認知や問題解決に関する基盤モデルの能力を評価するためのベンチマークだ。

FreeWilly1とFreeWilly2はいずれも、複雑な推論、言語的な微妙さの理解、専門的な領域に関連する複雑な質問への回答(法律や数学的な問題解決など)など、多くの分野で優れていると、Stability AIは述べている。

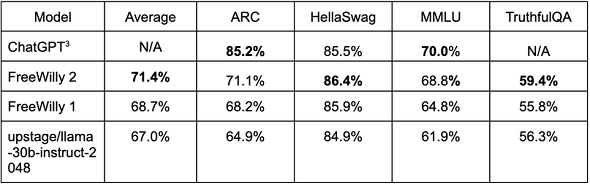

Open LLM Leaderboardベンチマーク

Stability AIは、自社の研究者によるFreeWillyの評価結果と、オープンソースAIコミュニティーのHugging Faceで2023年7月21日に独自に再現され、「Open LLM Leaderboard」に掲載された結果をまとめた下の表を紹介している。

表の各列は、以下のタスクの実行結果を評価している。

- ARC:要約と推論

- HellaSwag:常識を問う自然言語の推論

- MMLU:大規模マルチタスク言語理解

- Truthful QA:質問に対する回答

FreeWilly2の成績は、HellaSwagでChatGPTを上回っている。ChatGPTがFreeWillyを上回っているのは、ARCとMMLUだ。

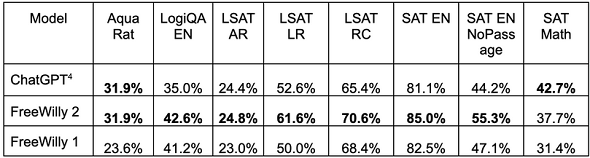

AGIEvalベンチマーク

Stability AIは、FreeWillyのAGIEvalベンチマーク結果と、Microsoftの上記論文に掲載されたChatGPTのベンチマーク結果も以下のように紹介している。多くの項目でFreeWilly2がChatGPTを上回っている。

関連記事

「Stable Diffusion」で話題のStability AIが、テキスト生成言語モデルを公開

「Stable Diffusion」で話題のStability AIが、テキスト生成言語モデルを公開

Stability AIは、テキストやコードを生成できる、オープンソースの言語モデル「StableLM」を公開した。「CC BY-SA-4.0」ライセンスに基づき、研究だけでなく、商用目的でも利用できる。 CarperAI、初の“指示チューニング”型オープンソース大規模言語モデルの開発計画を発表

CarperAI、初の“指示チューニング”型オープンソース大規模言語モデルの開発計画を発表

オープンソースAI研究者チーム「CarperAI」は、大規模言語モデル(LLM)のトレーニングのエキスパートであるEleutherAIとMultiおよびラベリングとヒューマンアノテーションのエキスパートであるScale、Humanloop、Hugging Faceと共同で、人間の指示に従うように明示的にトレーニングされたLLMの公開に取り組むと発表した。 「Metaが公開した『LLaMa 2』はオープンソースではない」――OSIが声明

「Metaが公開した『LLaMa 2』はオープンソースではない」――OSIが声明

オープンソース推進団体のOpen Source Initiative(OSI)は、「Metaが公開した『LLaMa 2』のライセンスはオープンソースではない」との声明を発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.