Google、商用利用可能な軽量オープンAIモデル「Gemma」を公開:主要ベンチマークで大型モデルを上回るパフォーマンスを発揮

Googleは、大規模言語モデル「Gemma」を提供開始した。「Gemini」と同じ研究と技術に基づく軽量のオープンモデルファミリーだ。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

Googleは2024年2月21日(米国時間)、新世代の大規模言語モデル(LLM)「Gemma」を提供開始した。Googleの生成AI(人工知能)「Gemini」と同じ研究、技術に基づいた軽量のオープンモデルファミリーだ。

20億パラメーターの「Gemma 2B」と70億パラメーターの「Gemma 7B」がリリースされており、それぞれ事前トレーニング済みモデルとインストラクションチューニング済みモデルが用意されている。

- 事前トレーニング済みモデル:Gemmaのコアデータトレーニングセット以外の特定のタスクや手順ではトレーニングされていない。チューニングした上でデプロイ(展開)する必要がある

- インストラクションチューニング済みモデル:人間の言葉による操作でトレーニングされており、チャットbotと同様に会話の入力に応答できる

これらのモデルはノートPC、ワークステーション、「Google Cloud」で実行できる。Google Cloudでは、「Vertex AI」と「Google Kubernetes Engine」(GKE)を使って簡単にデプロイできる。Gemma 2Bの対象プラットフォームはモバイルデバイスとノートPC、Gemma 7BはデスクトップPCと小規模サーバだ。

Gemmaの利用規約では、規模の大小を問わず全ての組織に、責任ある商用利用と配布を認めている。

Gemmaの特徴

先進的なパフォーマンス

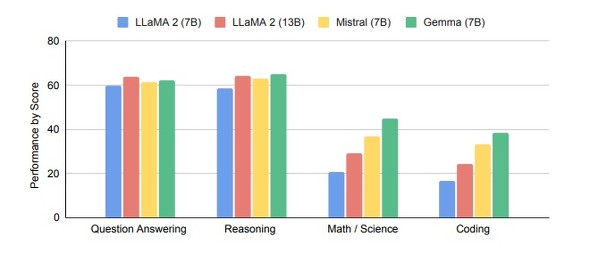

Googleが公開した技術レポートによると、Gemmaはオープンモデルの中でクラス最高のパフォーマンスを発揮するという。安全で責任ある出力のためのGoogleの厳格な基準を順守しながら、主要ベンチマークでより大型のモデルを上回る成績を収めているとした。

主要ベンチマーク(質問回答、推論、数学/科学、コーディング)でのLlama-2(7B)、Llama-2(13B)、Mistral(7B)、Gemma(7B)の比較(提供:Google DeepMind)

主要ベンチマーク(質問回答、推論、数学/科学、コーディング)でのLlama-2(7B)、Llama-2(13B)、Mistral(7B)、Gemma(7B)の比較(提供:Google DeepMind)責任ある設計

Gemmaは、GoogleのAI原則に基づいて設計されている。Googleは事前トレーニング済みモデルでは、安全性と信頼性を高めるため、自動化技術を用いてトレーニングデータセットから特定の個人情報などの機密データを除外した。広範なファインチューニングとRLHF(人間のフィードバックを用いた強化学習)により、インストラクションチューニング済みモデルを責任ある行動と整合させた。

GoogleはGemmaとともに、新しい「Responsible Generative AI Toolkit」を開発者や研究者向けにリリースした。このキットは、安全で責任あるAIアプリケーションの構築を支援するガイダンスやツールを提供する。

フレームワーク、ツール、ハードウェアにわたる最適化

Gemmaモデルは、要約や検索拡張生成(RAG)のような特定のアプリケーションのニーズに合わせて、独自のデータでファインチューニングできる。以下のようなさまざまなツールやシステムをサポートしている。

マルチフレームワークツール

マルチフレームワークのKeras 3.0、ネイティブPyTorch、JAX、Hugging Face Transformerにわたる推論とファインチューニングのレファレンス実装により、お気に入りのフレームワークを適用できる。

最先端のハードウェアプラットフォーム

GoogleはNVIDIAとの提携に基づき、データセンターからクラウド、ローカルのRTX AI PCに至るまで、GemmaをNVIDIA GPUに最適化し、業界をリードするパフォーマンスとともに、最先端技術との統合を実現している。

Google Cloudへの最適化

Vertex AIが提供する幅広いMLOpsツールセットは、さまざまなチューニングオプションと、組み込みの推論最適化によるワンクリックデプロイ機能を備える。

関連記事

Googleが次世代AIモデルで「Geminiの時代へようこそ」、搭載Bardは日本でも使える

Googleが次世代AIモデルで「Geminiの時代へようこそ」、搭載Bardは日本でも使える

Googleが新AIモデルのGeminiをリリースした。人の専門家を超える能力を備えると同社が主張するGeminiは、日本でもBardで使えるようになっている。実力はどうなのか。 日本語版「Bard」でも「Gemini Pro」が利用可能に 要約、コーディング能力など向上

日本語版「Bard」でも「Gemini Pro」が利用可能に 要約、コーディング能力など向上

Googleは「Bard」日本語版で「Gemini Pro」が使用できるようになったことを発表した。また、Bardの英語版に画像生成機能を導入した。 マルチモーダルAI(Multimodal AI)とは?

マルチモーダルAI(Multimodal AI)とは?

用語「マルチモーダルAI」について説明。テキスト/画像/音声/数値など複数の種類のモダリティー(データ種別)を一度に処理できる統合されたAIモデルを指す。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.