オープンマルチモーダルAI「Molmo」リリース 公開された4つのモデルのパフォーマンス、既存モデルとの違いとは?:「オープンなAIとプロプライエタリなAIのギャップを埋める」

アレン人工知能研究所は、オープンマルチモーダルAI「Molmo」を発表した。最初のリリースとして、4つのモデルを公開した。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

アレン人工知能研究所は2024年9月25日(米国時間)、オープンマルチモーダルAI(人工知能)モデル「Molmo」を発表した。

アレン人工知能研究所は「今日、最も先進的なマルチモーダルモデルは依然としてプロプライエタリで独占的なものだ。オープンデータを活用して視覚言語モデル(VLM)を構築する研究は、最先端のマルチモーダルモデルに大きく後れを取っている。昨今の強力なオープンウェイトモデルも、既存のVLMからの合成データに依存している。つまり、クローズドなモデルからの蒸留に頼っている」とし、「Molmoは最先端のオープンなマルチモーダルAIモデルファミリーであり、さまざまな学術ベンチマークや人間による評価において、オープンなAIとプロプライエタリなAIのギャップを埋めるものだ」と述べている。

4つのモデルをリリース、既存モデルとの違いとは?

Molmoは、「CLIP(Contrastive Language-Image Pre-Training)」ベースの事前学習済みビジョンエンコーダーと大規模言語モデル(LLM)を使用して構築されている。そして、VLMパイプライン(ウェイト、コード、データ、評価)はオープンであり、他のVLMの蒸留はしていない。

Molmoの最初のリリースには、次のモデルがある。全てのウェイト、キャプション/ファインチューニングデータ、ソースコードをリリースするという。

- 「MolmoE-1B」:1B(10億)、7B(70億)パラメーターを持つMoE(Mixture of Experts)モデル

- 「Molmo-7B-O」:最もオープンな7Bモデル

- 「Molmo-7B-D」:デモ用モデル

- 「Molmo-72B」:最も高性能なモデル

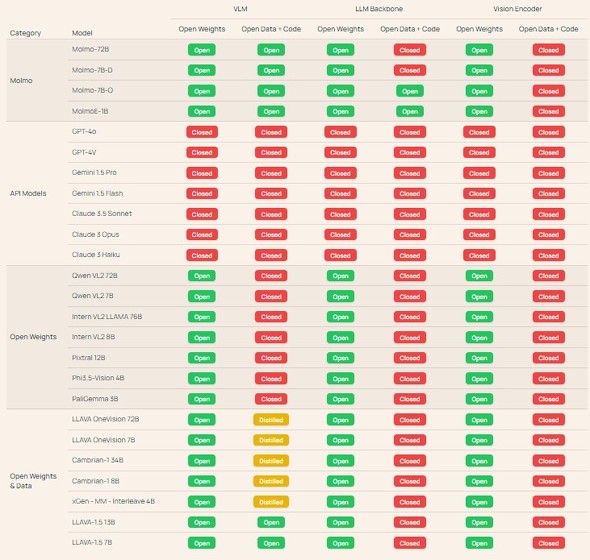

アレン人工知能研究所は、Molmoのオープン性を、既存のVLMと次のように比較している。

Molmoの革新性

アレン人工知能研究所によると、Molmoの革新的な部分は、既存のVLMを使わずに収集された詳細なデータセット「PixMo」にあるという。PixMoは、マルチモーダルの事前学習用の密なキャプションデータと、質疑応答、文書の読み取り、点群データなどを含む、幅広いユーザーインタラクションを可能にするための教師付きファインチューニングデータから構成されている。

キャプションデータについてアレン人工知能研究所は、「既存のVLMを使用せずに、人間のアノテーターに最大90秒間、画像のキャプションになる説明(空間的な位置関係を含む)をしてもらい、71万2000枚分の高品質なキャプションデータを得られた」と述べている。

Molmoの評価

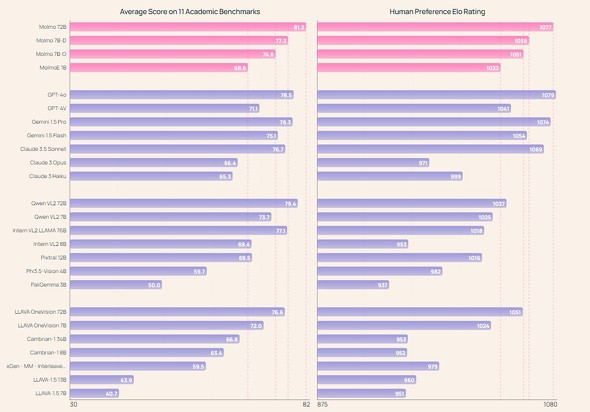

アレン人工知能研究所は、11の学術的ベンチマークと870人以上のアノテーターによる評価に基づき、Molmoの性能を次のようにまとめている。

- MolmoE-1Bは、学術的ベンチマークと人間による評価の両方で「GPT-4V」のパフォーマンスにほぼ匹敵する

- Molmo-7B-OおよびMolmo-7B-Dは、学術的ベンチマークと人間による評価の両方で「GPT-4V」と「GPT-4o」の中間の性能を示し、最近リリースされた「Pixtral 12B」モデルを両方のベンチマークで大幅に上回る

- Molmo-72Bは、学術的ベンチマークで最高スコアを達成し、人間による評価では2位にランクインした。Molmo-72Bは、「Gemini 1.5 Pro」「Flash」「Claude 3.5 Sonnet」など、最先端のプロプライエタリシステムよりも優れた性能を発揮する

アレン人工知能研究所は2024年内に、技術レポートの詳細版や、追加のモデルウェイト、PixMoのデータセットファミリーをリリースする計画だ。

関連記事

OpenAI、AIモデルのマルチモーダル対応やファインチューニング機能強化を発表 無料でどこまで使える?

OpenAI、AIモデルのマルチモーダル対応やファインチューニング機能強化を発表 無料でどこまで使える?

OpenAIは、同社のAIモデル向けの「Realtime API」(パブリックβ版)、「Chat Completions API」の音声入出力サポート、「ビジョンファインチューニング」機能、「Model Distillation」スイート、「プロンプトキャッシング」を発表した。 Gartnerが生成AIのハイプ・サイクルを発表 RAGなどが「過度な期待のピーク」に、幻滅期に入ったのは?

Gartnerが生成AIのハイプ・サイクルを発表 RAGなどが「過度な期待のピーク」に、幻滅期に入ったのは?

Gartnerは、2027年までに生成AIソリューションの40%がマルチモーダルになり、テキスト、画像、音声、動画、数値など、複数種類のデータを一度に処理できるようになるとの見通しを明らかにした。 UIとインフォグラフィックスの理解に特化した視覚言語モデル「ScreenAI」 Googleが開発

UIとインフォグラフィックスの理解に特化した視覚言語モデル「ScreenAI」 Googleが開発

Googleは、UIとインフォグラフィックスの理解に特化した視覚言語モデル「ScreenAI」を公式ブログで紹介した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ