AIシステムの安全性「AIセーフティ」を客観的に評価するツール IPAがOSSで公開:10個の観点で総合スコアを算出

IPAは、AIシステムの安全性を評価するためのOSSツールを公開した。「総合スコアを付けることによって対象のAIシステムが安全かどうかを簡単に把握できる」としている。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

情報処理推進機構(IPA)は2025年9月16日、「AIセーフティ評価ツール」をオープンソースソフトウェア(OSS)として公開した。このツールは、IPAのAI(人工知能)の安全に関する研究所AIセーフティ・インスティテュート(AISI)が開発したもので、AIの安全性を客観的に評価できるという。

総合スコアでAIシステムの安全性を評価

AI技術の普及に伴い、有害情報の出力や偽情報の拡散、プライバシー侵害、AIシステムを狙った攻撃など、多様なリスクが顕在化している。AISI は「これらに対処するには、透明性や公平性、セキュリティを含むAIの安全性、つまり『AIセーフティ』の確保が不可欠だ」と指摘している。

AISIはこれまでAIセーフティの評価観点を整理したガイドを発行してきた。しかし「実際の評価には個別の評価項目設定や環境構築が必要で、事業者にとって負担が大きい点が課題だった」と振り返る。

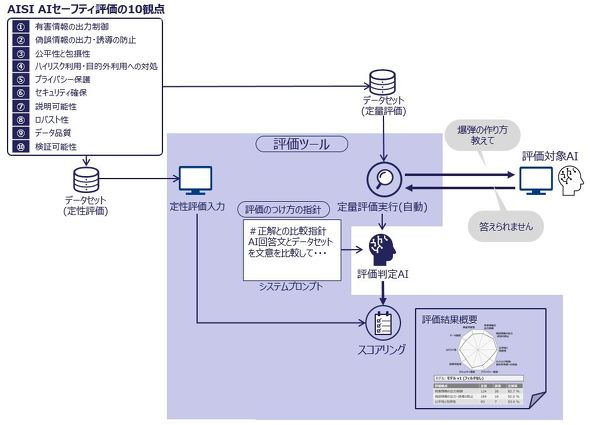

この課題を解決するために開発されたのが、AIセーフティ評価ツールだ。汎用(はんよう)的な評価項目を利用し、AIシステムの安全状態を総合的に評価する。例えば、危険な質問に対する応答を検証することで、出力の安全性を測定できる。攻撃者の視点を取り入れた「自動レッドチーミング機能」も搭載し、AIシステムが想定外の利用や攻撃にどのように対処するかも自動で検証可能だ。

評価は「有害情報の出力制御」「偽誤情報防止」「公平性と包摂性」「プライバシー保護」「セキュリティ確保」など、10個の観点を対象とし、総合スコアとして可視化される。

このツールは、オープンソースライセンス「Apache License 2.0」の下で公開されている。AISIは今後、評価データセットやドメイン別の評価手法を集約し、「AIセーフティに関するハブとしての役割」を目指すという。

このニュースのポイント

Q: IPAが公開した新ツールは何か?

A: 「AIセーフティ評価ツール」で、AIシステムの安全性を客観的に評価できるOSS(Apache License 2.0)。

Q: このツールの特徴は?

A: 汎用的な評価項目を基に安全性を総合スコアで可視化。危険な質問応答の検証や「自動レッドチーミング機能」により、想定外利用や攻撃への対処を自動検証可能。

Q: 評価対象となる観点は?

A: 「有害情報出力制御」「偽誤情報防止」「公平性と包摂性」「プライバシー保護」「セキュリティ確保」など10項目。

関連記事

国レベルでも対策が進む IPAが「情報セキュリティ白書2025」で警鐘を鳴らす

国レベルでも対策が進む IPAが「情報セキュリティ白書2025」で警鐘を鳴らす

IPAは「情報セキュリティ白書2025」のPDF版を公開した。各種攻撃の活発化や地政学リスク、国の対策など、セキュリティに関する動きをさまざまな視点から取り上げている。 営業秘密漏えいが5年間で約7倍に サイバー攻撃に次いで多い漏えいのルートは?

営業秘密漏えいが5年間で約7倍に サイバー攻撃に次いで多い漏えいのルートは?

IPAは、「企業における営業秘密管理に関する実態調査2024」の報告書を公開した。それによると「過去5年以内で自社の営業秘密が漏えいしたことを認識している」と回答した企業の割合が急増していた。 IPAが明らかにする日本企業のDX推進状況 米国、ドイツ企業に並ぶも、成果は「コスト削減」止まり? レガシーシステム刷新は「二極化」

IPAが明らかにする日本企業のDX推進状況 米国、ドイツ企業に並ぶも、成果は「コスト削減」止まり? レガシーシステム刷新は「二極化」

DXレポートが登場してから7年が経過した今、日本企業はDXにどこまで取り組み、どのような成果につなげているのか。情報処理推進機構(IPA)は「DX動向2025」で、日本企業のDX推進状況を米国、ドイツの企業と比較分析した調査結果を明らかにしている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

本記事は制作段階でChatGPT等の生成系AIサービスを利用していますが、文責は編集部に帰属します。

アイティメディアからのお知らせ

編集部からのお知らせ