Microsoft、新AIチップ「Maia 200」発表 推論性能3倍でNVIDIA依存から脱却へ:Tech News

Microsoftは、新型AIアクセラレータ「Maia 200」を発表した。FP4で10ペタFLOPSを上回り、Amazon Trainiumの約3倍の性能を実現するという。既にOpenAIのGPT-5.2など主要サービスに採用され、推論コスト削減とNVIDIA依存脱却を進める戦略的チップとして注目されている。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

Microsoftは2026年1月26日(米国時間)、同社のクラウド向けに開発したAI(人工知能)アクセラレータ「Maia 200」を発表した。同社が「これまでで最も効率的な推論システム」と位置付けるこのチップは、生成AIの普及に伴って急増する推論処理の需要に応えるために設計されたものだ。FP8/FP4の低精度演算を軸に性能とコスト効率を大幅に引き上げた点が特徴である。MicrosoftがNVIDIA依存の脱却を目指す戦略的なチップとなりそうだ。

Maia 200は、TSMCの3nmプロセスで製造され、1400億個以上のトランジスタを搭載する。4ビット精度(FP4)で10ペタFLOPS以上、8ビット(精度FP8)で5ペタFLOPS超の演算性能を実現する。7TB/sのメモリ帯域を持つ216GBのHBM3e(広帯域メモリ)と、より高速な272MBのオンチップSRAM(Static Random Access Memory)を備えることで、大規模モデルの推論で生じやすいデータ供給のボトルネックを大幅に緩和している。

ネットワークは、InfiniBandではなく、Ethernetを採用する。独自のトランスポート層とNIC(Network Interface Chip)を組み合わせることで、コスト効率と信頼性を両立したスケールアウト構成を可能にした。クラウド事業者がNVIDIA独自のネットワーク技術「NVIDIA Spectrum-X」への依存度を下げようとする潮流とも一致しており、Microsoftの戦略的意図がうかがえる。

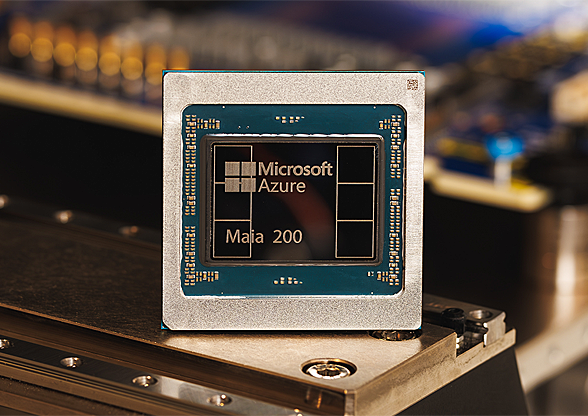

MicrosoftのAIアクセラレータ「Maia 200」

MicrosoftのAIアクセラレータ「Maia 200」4ビット精度(FP4)で10ペタFLOPS以上、8ビット(精度FP8)で5ペタFLOPS超の演算性能を実現する。Official Microsoft Blog「Maia 200: The AI accelerator built for inference」より。

Maia 200は、既に米国アイオワ州の「US Central」リージョンで稼働を開始しており、アリゾナ州の「US West 3」にも導入される予定だ。利用先としては、OpenAIのGPT-5.2系モデルの推論基盤をはじめ、Microsoft 365 Copilot、Microsoft Foundry、さらに同社のスーパーインテリジェンスチームによる合成データ生成や強化学習のワークロードなどが挙げられている。特に合成データ生成パイプラインでは、Maia 200の高いデータ処理能力が大きく寄与すると述べている。

競合との比較では、第3世代のAmazon Trainiumに対してFP4性能で約3倍、Googleの第7世代TPUに対してもFP8性能で上回る性能を実現しているという。クラウド各社が自社設計チップを強化する中、Microsoftも独自路線を明確に打ち出した格好だ。

生成AIの普及により、企業にとって学習よりも推論コストが収益性を左右する段階に入っている。Microsoftは、「Maia 200はこれまでに導入した中で最も効率的な推論システムでもあり、現在の当社のシステムに搭載されている最新世代のハードウェアよりも、1ドル当たり30%のパフォーマンス向上が見られる」としている。Maia 200の登場は、AIインフラの主導権争いが一段と激しさを増す中で、Microsoftが推論時代の中心的プレイヤーとしての地位を固める動きといえる。

■関連リンク

- Maia 200: The AI accelerator built for inference(Microsoft公式ブログ)

- Microsoft introduces Maia 200: New inference accelerator enhances AI performance in Azure(Microsoft Source EMEA)

- Deep dive into the Maia 200 architecture(Maia 200の技術的な詳細情報)(Azure Infrastructure Blog)

Copyright© Digital Advantage Corp. All Rights Reserved.