潜入! 北陸StarBED技術センター:これが世界最大規模のテストベッドの全貌だ(3/3 ページ)

サーバルームも実験スペース? StarBEDの心臓部を拝見

ここまで話を聞くと、やはり見てみたいのが同センターの心臓部、サーバルームだ。シミュレータ研究室と呼ばれるそこは、センター入口から真っすぐ進んだ奥にある。

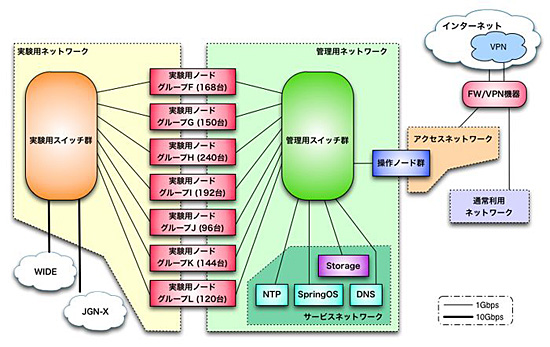

StarBEDは前述のとおり、操作ノードを介して外部から管理用ネットワークにアクセスできる(図6)。

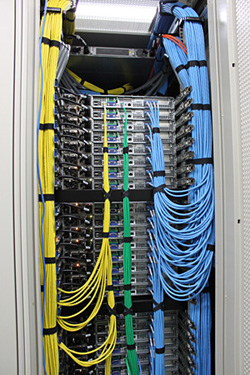

内部に入ると、手前から新規ラック、管理用ラック、2002年から2011年にかけて利用された実験用ノード群のラック群、StarBED3に入ってからの実験用ラックと続く。

手前の新規ラックには、デルの高密度型サーバが224台入る予定だ(実は、取材日は搬入日だった)。スイッチには昨年Interopでジュニパー・ネットワークスが出展していたQFabricの1Uタイプが入る。データラインは10Gで、サーバ間はオーバーサブスクリプションがないという、非常に珍しい構成となる。ジュニパーの性能は最大限活用され、低遅延で高速な実験ノード群ができあがる。

下記の写真左(写真8)は、2008年に整備されたHP ProLiant240台が入ったラックだ。灰色のケーブルは、6本のケーブルを集約した特殊ケーブルになる。ラック自体はラックベンダと相談し、1200mmの奥行きで作ってもらった。現在のデルやHPの64ビットサーバのサイズは1200mmが標準仕様なので、時代を先取りしたラックと言える。

上の写真右(写真9)は、2010年に整備したCisco UCS C200 M2群。こちらでも、冷却装置を手前に出すようベンダとやり取りしてラックを設計した。上部に空気を上がりやすくすることで、冷却効率を上げた。

裏へ回ると、100Gbpsのケーブルが2本出ていた。スイッチのモジュール間のバックブレーンは200Gbpsで、その速度をフルで賄っている。オーバーヘッドのない運用に一役買っている。

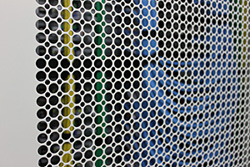

別の実験ノード群では、自然排気型のラックが採用されていた。これは金属加工会社の自信作で、排気効率を上げる方法はないかと聞いたら、大きい丸に小さい丸を開けてくれたという。この作業はなかなか大変らしい。

その中を開けると、電源、データライン、コントロールラインがフル接続で結束されたサーバが。これ以上はどうするか悩ましいくらい、ぎりぎりの状態だ。

ユニークだったのは、試験導入されたVETTE社の「RDHx」だ。背面の扉には、水冷式の冷却装置が取り付けられている。サーバから吹き出された熱い空気は装置に当たって冷やされ、外に吐き出される。暖まった空気全体を冷却するパッケージ型エアコンと比べて、冷却効果とエネルギー効率は断然高い。

「一般的なデータセンターの排熱は1ラックあたり4〜10KW程度だが、高密度のStarBEDは16〜18KWだ。パッケージ型エアコンの冷却では間に合わない」。RDHxを導入した結果、エアコン使用時よりも1/5〜1/10も低い消費電力で高い冷却効果が得られたと三輪氏は言う。

ラックも含めて、設備全体が実験スペースとなっているところが、いかにもStarBEDらしい。

Glimmerglassの光スイッチもあった。OpenFlowの実験など、物理層でL0/L1の切り替えが必要なときに利用される。これにつながるサーバとネットワーク側は、現在準備中だ。

Glimmerglassの近くには、OpenFlowスイッチ群もあった。StarBEDのサーバ96台がつながったOpenFlowテストベッドで、JGN-Xのテストベッドにもつながっている。「広域ネットワークでのテストと、サーバが必要なテストの両方を組み合わせ次第で行える」(三輪氏)。これはJGN-Xのアクセスポイントの一部でもあり、各社の実験機器が入っているなど、InteropのOpenFlow相互接続実験に近い環境が構築されている。

最後は、外出先でXENebulaなどのデモンストレーションに使っていた、“持ち運び用StarBED”だ。外側のラックはオーディオメーカーしか扱っていない特殊なケースで、米軍などに卸しているメーカー製の非常に耐久性に優れた入れ物だ。ちなみに、このラックを購入するまでは、納入用のダンボールにサーバを詰め込んで持ち歩いていたそうだ。

基盤やエミュレータの力を引き出す“人”の力

これだけの基盤やエミュレータも、性能がフルに引き出せなければ宝の持ち腐れだ。そんな懸念も、やや人間離れした技術力と運用力を持った同センターの運用チームの前では一蹴される。

運用チームの業務は、基盤やエミュレータの研究開発と運用、各プロジェクトの実験に関する調整、検証環境や期間の整備、運用サポートなど、難易度が高い上に多岐に渡る。これをすべて支えられるのも、運用チームの実力あってこそだ。

そうは言っても、負担はかなり大きい。例えば実験の予約受付などをオンライン予約形式にしてしまえば、多少は楽になるのではないかと考えてしまう。

しかし、人が介在するからこそ柔軟な運用ができ、むしろ利用の効率化にもつながっていると、宮地氏は言う。例えば予約受付では、ただスケジュールを埋めるだけではダメだ。「前年度の同プロジェクトの成績からすると必ず延長の申し出があるから、延長枠を用意しておこう」といった判断をしつつ、全プロジェクトで十分な実験期間がとれるよう調整する。こうした臨機応変な判断が、運用の柔軟性と効率化につながっている。

「オンライン予約形式にしてしまうと、みんな予約をとれるだけとってしまう。しかし、中には予約したのに実験しなかった期間も出てくる。人が間に入れば、こうしたリソースの無駄使いがなくせる」(宮地氏)

このような人間力の良さを残しつつ、現在StarBED3では基本サービスメニューの増設など、運用の負担軽減と合理化を進めている。

「StarBED時代から利用していた企業は、自由度が下がったと感じるかもしれない。そうした不満を吸収しながら、root権限がなくても自由に実験できる、そんなインターフェイス作りを目指している」(宮地氏)

強力な三本柱を支えに、北陸StarBED技術センターは着々と未来へ前進している。新世代ICTシステムの夢が実現するのも、そう遠くない。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ

写真5●右がシミュレータ研究室で、StarBEDの中核となるサーバなどが運用されている。左は施設利用者用の部屋や研究員用の部屋がある

写真5●右がシミュレータ研究室で、StarBEDの中核となるサーバなどが運用されている。左は施設利用者用の部屋や研究員用の部屋がある 図6●シミュレータ研究室の構成図(2012年5月時点)

図6●シミュレータ研究室の構成図(2012年5月時点)