「偽装攻撃データを用いてAIモデルに誤判定させる攻撃」への耐性を強化する技術を富士通研究所が開発:通信ログやサービス利用履歴など系列データ向けに開発

富士通研究所は、「偽装攻撃データを用いてAIモデルに誤判定させる攻撃」への耐性を強化する技術を開発した。偽装攻撃の模擬データを大量に自動生成し、元の学習データを結合させることで判定精度を維持したまま偽装攻撃への耐性を向上させる。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

富士通研究所は2020年10月29日、偽装攻撃データを用いてAI(人工知能)モデルをだまし、意図的に誤判定させる攻撃への耐性を強化する技術を開発したと発表した。AIの誤判定を意図的に引き起こす攻撃への対策技術は、これまで画像や音声といった「メディアデータ」を対象としたのものが多く、通信ログやサービス利用履歴といった「系列データ」に対しては、模擬偽装攻撃データを用意する難しさや精度低下といった課題があった。

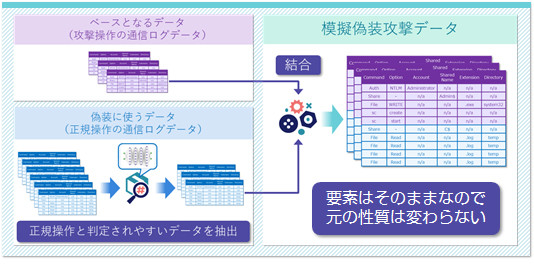

正規操作と判定されやすい偽装効果の高いデータを抽出

系列データに敵対的訓練技術を適用するには、偽装攻撃を模擬した学習データを大量に生成する必要がある。ただし、系列データの場合は、どの要素が元データの性質に影響しているか分からないため、単純にデータの一部を加工すると元データの性質が失われてしまうことが課題だった。

富士通研究所が開発した技術は、偽装攻撃の模擬データと元の学習データを結合させることで判定精度を維持したまま偽装攻撃への耐性を向上させる。

例えば通信ログを偽装する攻撃の場合、攻撃者は攻撃操作を正規操作に偽装させることが多いため、攻撃操作時の通信ログデータと偽装に使う正規操作時の通信ログデータを用意する。

そして、偽装に使う正規操作の通信ログデータを対策前のAIモデルで分析し、その結果から正規操作と判定されやすい偽装効果の高いデータを抽出する。抽出したデータを攻撃操作の通信ログデータに結合して模擬偽装攻撃データを生成する。

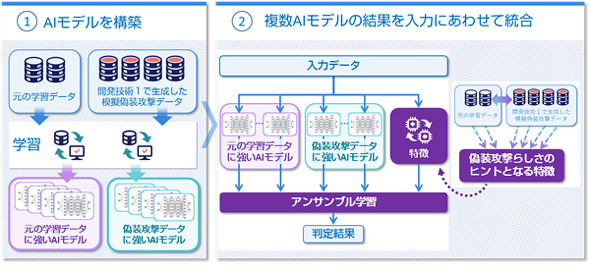

次に、元の学習データを学習させたAIモデルと、模擬偽装攻撃データを学習させたAIモデルの2つを構築する。これら2つのAIモデルの判定結果を、入力データに合わせて統合(アンサンブル学習)する。

富士通研究所は「系列データは一部でも変更すると元の性質が失われてしまう。この方式であれば攻撃操作の通信ログデータは変更していないため、元の性質を失うことなく、自動的に大量の模擬偽装攻撃データを生成できる」としている。

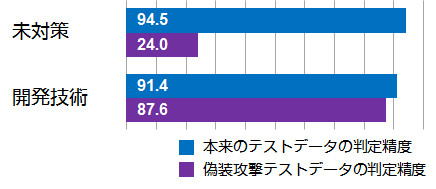

実際に、同社独自の偽装攻撃テストデータに適用したところ「約88%の精度で誤判定を防げることを確認した」という。判定に失敗した偽装攻撃テストデータについては「特定操作の組み合わせを偽装攻撃と判断していたことから単純なルールで対応可能であり、実質的に全ての偽装攻撃を防げる」としている。

関連記事

画像データをキーワード検索で効率的に収集する方法(Python「icrawler」のBing検索)

画像データをキーワード検索で効率的に収集する方法(Python「icrawler」のBing検索)

Bingキーワード検索による画像データの収集を、Pythonライブラリのicrawlerを使って簡単に行う方法を紹介する。たった3行のコードで非常にシンプル。 「データサイエンス100本ノック」の生みの親はなぜ「3言語のサポート」と「Docker」にこだわったのか

「データサイエンス100本ノック」の生みの親はなぜ「3言語のサポート」と「Docker」にこだわったのか

データサイエンスに興味がある技術者の間で話題になった「データサイエンス100本ノック(構造化データ加工編)」。生みの親である森谷和弘氏によると、この取り組みが生まれた背景には「データ分析の最も大きいニーズに応える環境がない」という課題があったという。 「データセットの準備を丸投げしない」――健康管理アプリ「FiNC」AI開発5つの教訓

「データセットの準備を丸投げしない」――健康管理アプリ「FiNC」AI開発5つの教訓

ヘルスケアプラットフォームアプリ「FiNC」を開発するFiNC Technologiesで代表取締役CTOを務める南野充則氏は、AI研究開発プロジェクトを通じて得た「5つの教訓」を紹介した。その教訓とは。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.