「本人はどう聞こえているか」を客観視できる技術を東京工業大学の研究チームが開発:脳波信号から音声を再現

東京工業大学の研究チームは、脳波信号から音声を再構築する手法を開発した。CNNによって音声情報を表現しているパラメーターを推定し、耳で聞き分けられる母音を脳波信号から合成する。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

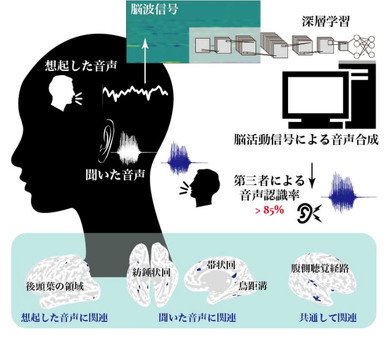

東京工業大学と科学技術振興機構(JST)は2021年1月8日、畳み込みニューラルネットワーク(CNN)を用いて、脳波信号から音声を直接再構築する手法を開発したと発表した。音がどのように聞こえているのか、あるいは聞こえていないのかを客観的に把握でき、脳のどこを使っているのかを調べられる可能性があるとしている。

今回の手法を開発したのは、東京工業大学科学技術創成研究院の准教授でJSTの「さきがけ研究者」を兼務する吉村奈津江氏と、同大学の大学院生の明石航氏、同研究院の助教を務める神原裕行氏、同研究院の特任助教を務める緒方洋輔氏、同研究院の教授を務める小池康晴氏、同研究院の特定准教授を務めるルドビコ・ミナチ氏の研究チーム。

脳波信号をCNNで音声に復元

同研究チームは、被験者の頭皮に装着した32個の電極で「母音の『ア』と『イ』、白色雑音(ホワイトノイズ:同程度の強度で広い周波数成分が含まれる雑音)を聞いているとき」と「その後、聞いた音声を想起しているとき」のEEG(脳内の神経細胞の活動を反映した電気信号)を記録した。

CNNを用いて、EEGから「被験者に聞かせた音源のパラメーター信号」を推定して音声を復元し、復元した音声が人間の耳で聞き分けられるかどうかを調べたところ、全ての被験者のEEGについて8割程度の判別できた。

研究チームによると「高精度に音声情報が抽出できたということは、この手法が脳内の音声処理過程を間接的に反映していると考えられる。CNNが音声を推定するのに利用した脳の領域を調べると、脳内の聴覚処理で『何の音かを検知するための信号を処理する脳領域群』だった。これはCNNで抽出した脳内の特徴が脳科学的にも妥当だったことを示唆している」という。

「音を聞いているとき」と「音を思い出しているとき」でCNNが抽出する脳領域が異なっており、この技術をさらに進歩させることで、脳内の聴覚や音声、言語の処理メカニズムが解明できる可能性があるとしている。

同研究チームは「本人がどのように聞こえているかを第三者に伝えることができ、聴覚検査の客観的な手法として使える可能性がある」としている。

関連記事

機械学習/統計学/データサイエンスの無償gacco動画、全まとめ【2022年秋版】

機械学習/統計学/データサイエンスの無償gacco動画、全まとめ【2022年秋版】

2022年3月末の最新状況に合わせて改訂。はじめてのAIから、機械学習、深層学習、自然言語処理、統計学、社会人のためのデータサイエンス(実用知識)、大学生のためのデータサイエンス(理論知識)まで、全28個の講義内容を紹介。本稿独自に考察した、学習者対象やお勧めの学習方法についても示す。 複数のスマホで撮影したビデオから「4D映像」を生成、カーネギーメロン大

複数のスマホで撮影したビデオから「4D映像」を生成、カーネギーメロン大

カーネギーメロン大学の研究チームが、スタジオや特殊なカメラを使わなくても、「4D映像」を生成できる手法を開発した。複数の「iPhone」で撮影したビデオ映像を組み合わせ、さまざまな角度から動きを見たり、視線を一時的に遮る人や物体を消去したりできる。 CNNなんて怖くない! その基本を見てみよう

CNNなんて怖くない! その基本を見てみよう

画像認識などでよく使われるCNN(畳み込みニューラルネットワーク)ではどんなことが行われているのでしょう。図を見ながら、CNNの基本を理解しましょう。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ