なぜ今AI倫理なのか? AIがもたらす「意図しない結果」を防ぐために開発者ができること:エンジニアが知っておくべきAI倫理(1)

正しくAIを作り、活用するために必要な「AI倫理」について、エンジニアが知っておくべき事項を解説する連載。初回は、AIの普及により浮き彫りになった課題と、AI開発プロセスに内在するリスクについて。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

スマートフォン、スマートスピーカーに搭載されている音声アシスタントやお掃除ロボットなど、身の回りのさまざまなところにAI(人工知能)が導入され、私たちの生活は今まで以上に便利になっている。だが、新しい技術であるが故に、AIのブラックボックス化やAIによる差別の助長など、今までなかったような新たな課題が見えつつある。本連載では正しくAIを活用するための手法である「AI倫理」について解説する。

今回はまず、AIの普及により浮き彫りになった課題と、AI開発プロセスに内在するリスクを開発フェーズごとに整理する。

AIがもたらした「意図しない結果」 どう防ぐ?

AIの普及が進むにつれ、さまざまな課題が顕在化してきている。中でも、「Black Lives Matter」運動に後押しされ、顔認証AIへの批判が集まったり、サービス停止に追いやられたりしたケースは記憶に新しい。以前から肌の色などでAIの認識精度に差があることや、黒人画像をゴリラと誤認識するなど顔認証AIに関する課題は指摘されていた。それがプライバシーやAIの公平性、透明性の問題に関する昨今の世の中の関心と相まって大きな社会問題となったのだ。

IBMやAmazon.comなどは顔認証ソフトウェアを捜査機関などに提供することを停止すると発表し、EUや米国では新たに法執行機関における顔認証AIの利用禁止の規則が制定された。誤認識を引き起こす問題は差別以外にもさまざまなものがあり、AIを使ったサービスにおいて誤認識への対応は避けることのできない問題である。

もう1点、意図していなかった結果をAIが引き起こしてしまった例として触れておきたいのが、自動運転における「トロッコ問題」だ。「ブレーキが壊れたトロッコが暴走している。線路の先には5人の人間がいて、そのままでは間違いなく5人をひき殺してしまう。トロッコの進路を変えることができて、変えた場合の線路の先には1人の人間がおり、その人間をひき殺すことになる。トロッコの運転手は進路を変えるべきか否か」という、思考実験としても有名な問題である。

この問題が注目されるのは自動運転車(ここでは完全自動の自律運転車とする)が事故をどう回避するかの議論とも関係するからだ。「唯一無二の正しい答え」はなく、人間ですら国や地域、文化、宗教などによって回答の傾向が異なることが知られている。答えのない問題や国や地域によって答えの異なる問題にAIがどのような正解を出す必要があるかということも課題である。

このような状況下で、欧州を中心としてAIの利活用に関する法律やガイドラインを整備する流れが加速している。詳しくは次回以降で解説するが、AIの利活用で生じるリスクに対する適切な対応などの安全性向上と、AI利活用の促進を通じた競争力強化を両立させるものとして位置付けられている。

ではどのようにしてAIの安全性とAIを用いた成長を両立していけばよいのか。単に精度だけを追い求めてAIを開発していくだけでなく、いかに社会に受け入れられるAIを開発していくか、その際の鍵となるのがAI倫理である。

AIの開発、利用において、あらゆる場面での意思決定の中心は人間であるべきだ。そのため人に対しての行動指針、すなわちAI倫理が必要といえる。本連載では、AI倫理に基づいて、企業が顧客や社会に対してAIの公平性や透明性を担保する方法論を「責任あるAI」と位置付けて解説する。この方法論に基づいてAIを設計、構築、展開することで、真に人間中心のAI活用を目指すことが可能となる。つまりAI倫理によって企業はAIの持つリスクを正確に理解できるようになり、かつAIが持つ潜在的リスクへの対策を行うことでAIへの信用が生まれる。その信用が形成されて初めて、人間はAIを信頼できるようになるのである。この信用と信頼こそが、AIを自社のビジネスに応用し、拡大利用するための礎になるのだ。

アクセンチュアでは責任あるAIを形作るための行動原則(TRUST)として次の5つを提唱している。

- T:信用できる(Trustworthy)

AIの設計・構築時、安全性を重視して物事に誠実に向き合い、多様で広い視点を持つ、という実績を一つ一つ積み上げる - R:信頼できる(Reliable)

積み上げられた信用から、将来の高度な判断とより良い意思決定への支持を集める - U:理解できる(Understandable)

信用を得るためにはAIが透明性を持ち、人によって解釈可能にする - S:安全が保たれている(Secure)

信用を得るためには企業や顧客の情報、データのプライバシーに配慮し、安全性を確保する - T:共に学びあう(Teachable)

信用、信頼を勝ち得たAIと人間とが情報交換し、共創し、相互教育をする世界を実現して人間中心のデザインを目指す

何をどう対処すべきか? AI開発の段階ごとに解説

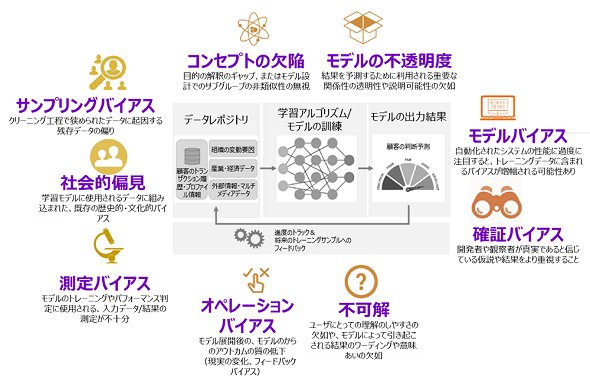

続いて、具体的に何をどう対処すればよいのか、AIの開発プロセスであるデータ収集、AI設計、AIモデル学習・評価、AIモデル運用について、ステップごとに解説していく。

データ収集

- 社会的偏見とサンプリングバイアス

データ収集の段階では、AIモデルの学習のために集めたデータそのものにバイアスが含まれているという課題がある。具体的には「社会的偏見」や「サンプリングバイアス」だ。社会的偏見とは人種、性別、職業など社会的に存在しているギャップがデータの中にバイアスとして入り込んでしまうことである。

例えば、与信審査を担当するAIが、女性の貸出限度額を男性よりも少なく見積もってしまうという事象はこの社会的偏見によるデータバイアスである。特にAIモデルは後述するモデルバイアスによりデータの持つバイアスを増幅する傾向があるため、取得データに社会的偏見が入りこまないよう注意が必要である。

サンプリングバイアスは、データ取得時やデータ加工時に、取捨選択されたデータが入りこんでしまうことが原因で起こる。例えば、年齢による身体能力の衰えを予測するため体育館にはり紙をして多数の人から体力測定のデータを取得し、AIモデルを作ったとする。この場合、健康意識の高い属性の人々が体育館を利用していることが想像されるため、世の中の平均の身体能力よりも高い基準で予測するAIモデルができるだろう。

データ加工時やデータ変換の際はバイアスが入り込みやすい。分析者が先入観を持ったデータ分類を行ったり古いデータを使い続けたりすることによって発生するバイアスもある。

AI設計

- コンセプトの欠陥

本来の目的とAI設計との間に生じたずれが主な原因で、コンセプトの欠陥が生じる。特に、データの中のグループ間に差異がある場合にはAIを利用する中でそのバイアスを増幅することにもなりかねないので注意が必要である。

例えば、犯罪防止のために犯罪予測AIを利用したと考えよう。地域による犯罪率に偏りがあると、特定の地域の警戒を強める。そのためその地域の犯罪検挙率が向上し、その地域の犯罪率が(実質変化していなくても、数値上は)さらに悪化してしまう、とった具合に結果的に負のフィードバックになってしまうことがある。

- 確証バイアス

確証バイアスとは、真実であると信じている仮説や結果をより重視することにより、紛れ込んでしまうバイアスのことである。人間は無意識に自分にとって都合の良い情報を優先し、そうでない情報を軽視する傾向があるため、先入観によってモデル設計の中でバイアスが発生するリスクがある。

有名な例としてよく取り上げられるのが、チョコレートの年間消費量が増えるとノーベル賞受賞者数が増えるという分析結果だ。冷静に考えると直接的な相関ではなく国の裕福度などによる疑似相関であると分かりそうだが、分析者がチョコレートに含まれるフラボノールで認知機能が向上するという仮説にとらわれるあまり、客観的なデータ分析ができなかったという事例だ。

このように分析、設計の段階で作業者の持つバイアスにより、誤った結果を導くリスクが大いにある。そのため分析者は論理的に分析仮説を構築するとともに、先入観なくデータに向き合うことが重要である。

学習、評価段階

- モデルの不透明度

モデルの不透明度とは、モデルの入力と出力との関係性に対する透明性や説明可能性を指す。透明性の高いモデルにするためには、入力データの各項目が出力結果に及ぼす影響について理解しやすいことが重要だ。つまり、結果が悪かった際に入力データのどの項目が影響しているのか、解釈できるようにしなければならない。

一般にディープラーニングなどの複雑なモデルは予測精度が高い一方で透明性が低く、ブラックボックスになりやすい。こういったモデルに対しても近年は「SHAP」(SHapley Additive exPlanations)や「LIME」(Local Interpretable Model-agnostic Explanations)といった予測根拠を可視化する手法が開発されている。Google傘下のDeepMindは眼底画像のAI診断で、単に疾患を判別するだけでなく、予測に寄与した特徴量の可視化も含めたディープラーニングのモデルを開発している。今後、医療など複雑な判断を必要とする場面でのAI活用は一層進むだろう。モデルの精度と説明可能性の両立はますます求められていくことになる。

モデル自体のバイアス

- 測定バイアス

測定バイアスとは、モデルの学習や評価に用いるデータが不十分である際に紛れ込むバイアスである。データ数が少ない状態でモデルに学習させる過学習(特定のデータにモデルがフィットし過ぎて汎用《はんよう》性を失った状態)が起きる可能性が高く、モデルの精度検証時のデータ分布が実際の分布と異なるために正確な精度検証ができないリスクがある。

- モデルバイアス

モデルバイアスとは、学習データに含まれるバイアスがモデル構築の過程で増幅されることである。構築したAIモデルの精度が高かったとしても、それがバイアス増幅によるものである場合には、特定グループの優遇や機会損失、差別の助長につながることがあるので注意が必要だ。

社会の中にある偏見を取り除くことは容易ではない。AIモデルの改良だけで対応するには限界があり、利用方法の工夫など別の対応方法も考える必要がある。過去にGoogle検索のオートコンプリート機能で偏見を伴う予測が表示されることが問題視されたが、Googleは議論を呼ぶ可能性のある単語をブロックした。このようにリスクへの対応は単にモデルを改善するだけでなく、運用も含めサービス全体で考えていく必要がある。

AIモデル運用

- オペレーションバイアス

AIモデルの運用の段階では、運用中に徐々にモデルの質が低下していくオペレーションバイアスのリスクがある。モデルを学習した段階と現時点でのデータに差が出てきた場合にこのようなバイアスが生じるので、マーケティングなどデータの分布が変化しやすい領域では注意したい。

ユーザーや環境からのフィードバックを新たに学習データに追加して学習をし直したり(再学習)、既存モデルのチューニングを行ったり、フィードバックを使ってAIの挙動を改善(強化学習)したりする取り組みも多いが、こういったフィードバックによって混入するフィードバックバイアスもオペレーションバイアスの一種だ。

ここまで具体的な例も取り上げつつAI開発の中に内在するリスクについて解説してきた。次回はこれらのリスクへの対処法を具体的な技術手法も交えつつ解説していく。

筆者紹介

保科 学世(ほしな がくせ)

アクセンチュア ビジネス コンサルティング本部 AIグループ日本統括 兼 アクセンチュア・イノベーション・ハブ東京共同統括 マネジング・ディレクター 理学博士。

アナリティクス、AI部門の日本統括として、AI HubプラットフォームやAI Poweredサービスなどの各種開発を手掛けるとともに、アナリティクスやAI技術を活用した業務改革を数多く実現。『責任あるAI』(東洋経済新報社)はじめ著書多数。

右衛門佐 誠(よもさ まこと)

アクセンチュア ビジネス コンサルティング本部 AIグループ プリンシパル 工学博士。大阪府立大学大学院博士後期課程修了。

製造業をはじめとする画像分析案件やAIやデータサイエンスに関する人材育成などの案件に従事。企業だけでなく大学との共同研究や講座提供なども担当。

特集:AIを使う人、作る人に知ってほしい 「AI倫理」との付き合い方

システムやサービスにAI(人工知能)を活用することが珍しくなくなった昨今、AIが引き起こす倫理的な問題もまた身近なものとなった。すでに欧米諸国ではAI倫理に関する法整備も進んでおり、日本国内にもその影響が及ぶことは想像に難くない。本特集ではそんなAI倫理について「AI倫理とはどういうものなのか」といった初歩的なテーマから「AI倫理に関してエンジニアは何を知っておくべきなのか」「AI倫理の観点から見たAI開発プロセスにおけるリスクとその対処法とは何か」といった実践的なテーマまで、深堀りして解説する。

関連記事

実は無関係じゃない、AI開発者も知っておきたい欧米のAI法規制・倫理と日本の現況

実は無関係じゃない、AI開発者も知っておきたい欧米のAI法規制・倫理と日本の現況

AI利活用が広まる一方、法律や倫理の観点から問題提起されるケースが見受けられるようになった。企業のAIビジネス動向に詳しい弁護士の三部裕幸氏が語る、欧米の法律、AI倫理の動向と日本の現況とは。 信頼の置けるAIを実現するには

信頼の置けるAIを実現するには

企業におけるAIを守り、AIが信頼の置けるものとして認識されるようにするために、新しいリスク軽減策を実施する必要がある。 アカウンタビリティ(Accountability、説明責任)とは?

アカウンタビリティ(Accountability、説明責任)とは?

用語「アカウンタビリティ(Accountability)」について説明。ガバナンスと倫理の観点で、AIシステムの設計/実装の情報開示から結果/決定の説明までを行い、利害関係者に納得してもらう責任を指す。簡単に言うと、「AIシステムの挙動に対して、誰が/何が、責任を持つのか」を明らかにすること。

Copyright © ITmedia, Inc. All Rights Reserved.