Anthropic、生成AIモデル「Claude 3」ファミリーを提供開始:「Haiku」「Sonnet」「Opus」の3モデル

米国スタートアップ企業のAnthropicは、大規模言語モデルファミリーの「Claude 3」を発表した。「Haiku」「Sonnet」「Opus」からなるClaude 3は、各モデルとも強力な性能を備えているという。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

米国スタートアップ企業のAnthropicは2024年3月4日(米国時間)、大規模言語モデル(LLM)ファミリーの「Claude 3」を発表した。

「『Haiku』『Sonnet』『Opus』の3つからなるClaude 3は、幅広い認知タスクにおいて新たなベンチマークとなる。各モデルとも強力な性能を備えている」と、Anthropicは述べている。

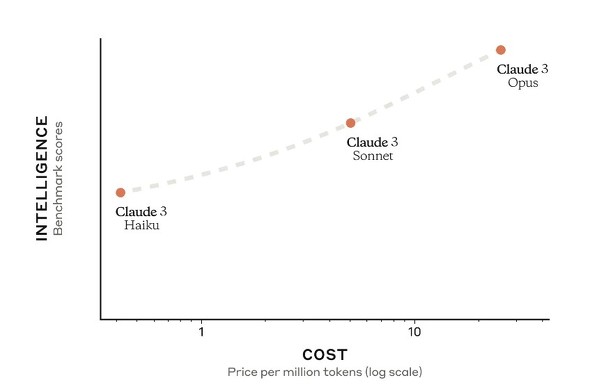

ユーザーは特定のアプリケーションに最適なインテリジェンス、スピード、コストのバランスを踏まえて、3つのモデルを選択できる。これらのモデルは、Anthropicが運営するWebサービス(「Claude.AI」)や、159カ国で一般利用可能なClaude APIを通じて利用できる。

Claude 3の特徴

Anthropicは、Claude 3の特徴を次のように解説している。

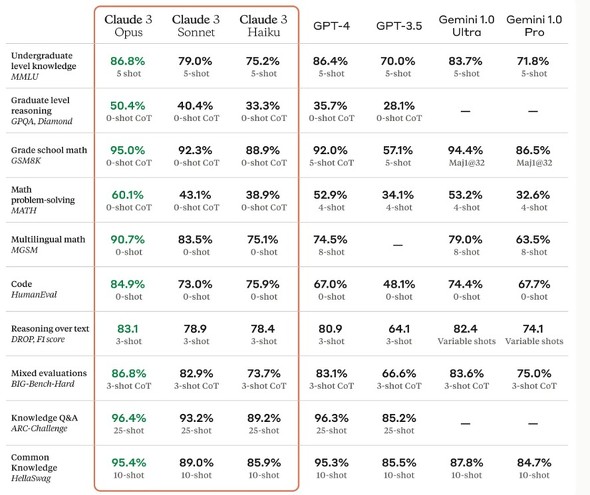

知能の新しい基準

Opusは、学部レベルの専門知識(MMLU)、大学院レベルの専門家の推論(GPQA)、基本的な数学(GSM8K)など、AIシステムの主要ベンチマークのほとんどで、他モデルをしのぐ。複雑なタスクにおいて人間に近いレベルの理解力と流ちょうさを示している。

リアルタイムの応答

Claude 3モデルは、顧客チャット、オートコンプリートおよび応答が即時かつリアルタイムでなければならないデータ抽出タスクに大きな効果を発揮する。

Haikuは、そのインテリジェンスカテゴリーにおいて、市場で最も高速かつ費用対効果の高いモデルだ。Haikuは、arXivに掲載されている情報量とデータ量の多い研究論文(10万トークン以内)を、チャートやグラフとともに3秒以内に読み取ることができる。

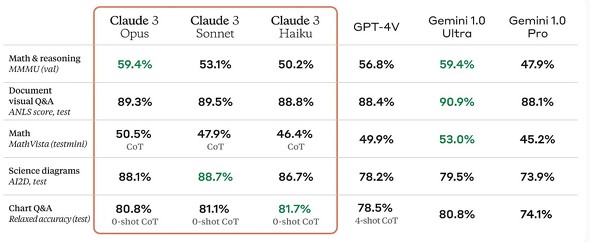

強力なビジョン機能

Claude 3モデルは、写真、チャート、グラフ、テクニカルダイヤグラムなど、さまざまなビジュアル形式を処理することができる。

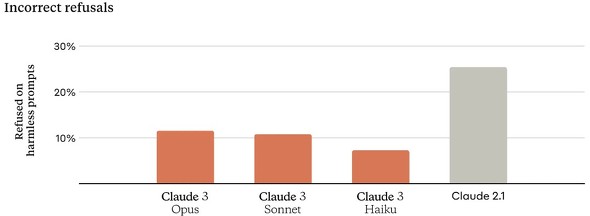

拒否する頻度の減少

前世代のClaudeファミリーは、文脈の理解不足による不必要な拒否をしていた。Claude 3は前世代のモデルと比べて、プロンプトへの回答を拒否する確率が大幅に減った。

精度の向上

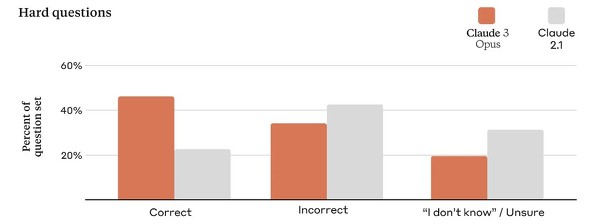

回答を「正解」「不正解」「分からない(不正確な情報を提供する代わりに答えを知らないと言う)」に分類した。Claude 2.1と比較して、Opusは正答率が2倍に向上したと同時に、不正解のレベルも低下した。今後、Claude 3ファミリーで資料の引用を可能にし、参考資料の正確な文章を指して回答を確認できるようにする予定だ。

コンテキストウィンドウは100万トークンに対応

Claude 3ファミリーのコンテキストウィンドウは、初期リリース時の20万トークンから100万トークンを超える入力を受け入れ可能になった。

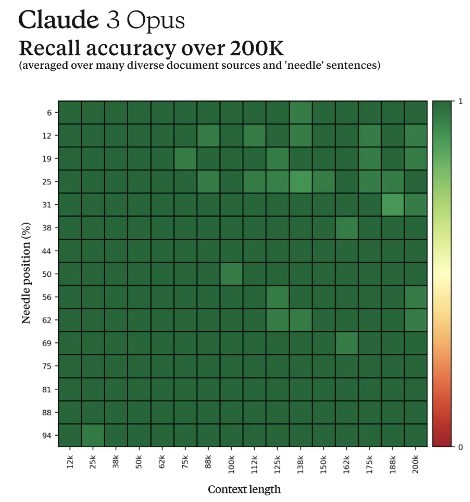

長いコンテキストのプロンプトを効果的に処理するには、モデルに強力な想起機能が必要となる。膨大なデータコーパスから情報を正確に想起する能力を持つかどうか測定する「Needle In A Haystack」(NIAH)ベンチマークでは、Claude 3 Opusの場合、99%の精度を超える完璧に近い想起を達成しただけでなく、テキストが人為的に挿入されていることを認識しており、NIAHベンチマーク自体の限界を特定した。

責任あるデザイン

Anthropicは、Claude 3ファミリーの誤情報、性的虐待、生物学的悪用、選挙妨害などさまざまなリスクに対応する専門チームを設置している。Constitutional AI(憲法AI)のような手法は安全性と透明性を高め、プライバシーの懸念にも対処している。

Bias Benchmark for Question Answering(BBQ)によると、Claude 3は以前のモデルよりもバイアスが少なくなっている。バイアスを減らし、モデルの中立性を高め、特定の党派的スタンスに偏らないようにする技術の開発が続けられている。

Claude 3ファミリーは、生物学的知識、サイバー関連知識、自律性の主要な指標において、以前のモデルと比較して進歩しているが、AI安全レベル2(ASL-2)にとどまっている。レッドチームによる評価は、現時点では、このモデルが深刻なリスクをもたらす可能性はごくわずかであると結論付けているが、さらなる安全性のために監視が続けられている。

より使いやすく

Claude 3は、複雑な複数ステップの指示に従うことができる。特にブランド固有の音声と応答ガイドラインを順守しつつ、ユーザーが信頼できる顧客対応体験を開発することに強みを持っている。Claude 3ファミリーは、JSONのようなフォーマットで出力を生成するのに優れているため、自然言語分類や感情分析のようなユースケースで容易になる。

関連記事

2024年の「AI/機械学習/データ分析」はこうなる! 7大予測

2024年の「AI/機械学習/データ分析」はこうなる! 7大予測

昨年2023年は、ChatGPTやGoogle BardなどのチャットAIに注目が集まり、企業やサービスに生成AIが導入されていくなど、大きな変化が一気に起こりました。今年2024年の「AI/機械学習/データ分析/データサイエンス」かいわいはどう変わっていくのか? 現状を踏まえつつ、未来を予測します。 GPT-4に次ぐ性能? LLM「Mistral Large」が登場 Azureでも利用可能

GPT-4に次ぐ性能? LLM「Mistral Large」が登場 Azureでも利用可能

Mistral AIがリリースしたLLM、Mistral Largeはテキスト理解、変換、コード生成などさまざまなタスクに活用できる。MistralはAzure AI Studioなどで利用できる。 GoogleのLLM「Gemini 1.5 Pro」は最大100万トークンのロングコンテキストウィンドウに対応 どう役立つのか?

GoogleのLLM「Gemini 1.5 Pro」は最大100万トークンのロングコンテキストウィンドウに対応 どう役立つのか?

GoogleがリリースしたGemini 1.5の強みの一つに、ロングコンテキストウィンドウがある。Googleが実装したロングコンテキストウィンドウとは何か、そしてこの機能が開発者にどのように役立つのか。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ