GoogleがKubernetesクラスタでの生成AI推論の最適化機能を発表 6710億パラメーターモデルのマルチホスト推論を可能にする仕組みとは:Red Hat、ByteDanceと共同で

GoogleはRed HatおよびByteDanceと共同で、大規模言語モデル(LLM)推論を実行するKubernetesクラスタにおいて、ロードバランシング、スケーリング、モデルサーバ性能を最適化する新機能を発表した。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

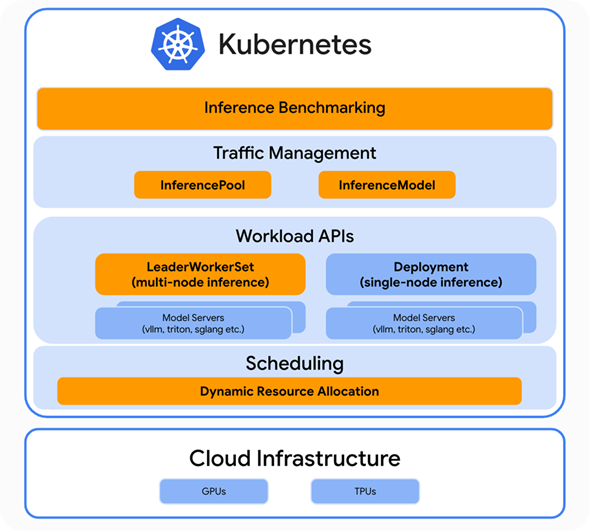

Googleは2025年4月3日(米国時間)、Red HatおよびByteDanceと共同で、大規模言語モデル(LLM)推論を実行するKubernetesクラスタにおいて、ロードバランシング、スケーリング、モデルサーバ性能を最適化する新機能を発表した。

この新機能は、複数のPodをグループとして扱えるLeaderWorkerSet(LWS)APIの成功に基づいており、Kubernetes上でのAI(人工知能)推論の可能性を押し広げると、Googleは述べている。LWSは、AI/ML(機械学習)マルチノード推論ワークロードの一般的なデプロイ(展開)パターンに対応するKubernetes Deployment API。最先端のモデル(671B〈6710億〉パラメーターのモデルを含む)のマルチホスト推論を可能にする。

Googleは、新機能で重要な役割を果たすオープンソースプロジェクトについて、次のように説明している。

Gateway API Inference Extension

新しい「Gateway API Inference Extension」(推論拡張)は、ext-proc対応プロキシまたはゲートウェイ(Envoy Gateway、kGateway、GKE Gatewayなど)をアップグレードし、推論ゲートウェイとする。これにより、Kubernetes上でLLMをセルフホスティングする推論プラットフォームチームをサポートする。

従来のラウンドロビンではなく、LLMを考慮したルーティングをサポートするため、LoRA(Low-Rank Adaptation)のような一般的なPEFT(Parameter-Efficient Fine Tuning)(※)手法を、より高い費用対効果で大規模に運用できるようになる。これは、ベースモデルを使用し、ユーザーニーズに基づいてファインチューニングされたモデル(「アダプター」)を動的にロードすることで可能になる。

(※)高パラメーター効率ファインチューニング。LLM内のパラメーターの一部のみを調整してリソースを節約する一連のトレーニング手法

今回発表の新機能では、PEFTをネイティブにサポートするために、新しい「InferencePool API」と「InferenceModel API」も導入されている。

Inference Perf

新しい「Inference Perf」(推論性能)プロジェクトは、生成AIの推論性能のベンチマーク基準を提供する。Kubernetes上での生成AI推論の拡大に伴い、モデルサーバ、アクセラレータ、Kubernetesオーケストレーションの性能とともに、サービングワークロードの性能を測定できるようにすることが重要になる。

Dynamic Resource Allocation

Intelなどと共同開発されたDynamic Resource Allocation(DRA)は、Pod間およびPod内のコンテナ間でリソースを要求、共有するためのAPIだ。KubernetesがGPU(Graphics Processing Unit)やTPU(Tensor Processing Unit)などのデバイスをPodやワークロードに割り当ててスケジュールする方法を、簡素化、自動化する。vLLM推論およびサービングエンジンとともに使用することで、コミュニティーはスケジューリング効率とアクセラレータ間のポータビリティという点で恩恵を受ける。vLLMは、LLM推論およびサービングのための高速で使いやすいライブラリだ。

Googleは、「これらのプロジェクトを組み合わせることで、顧客はInference Perfプロジェクトでアクセラレータの評価とベンチマークを実施し、Gateway API Inference ExtensionでLLMを考慮したルーティングによってスケールアウトアーキテクチャを運用し、DRAとvLLMにより、幅広いアクセラレータにわたってスケジューリングとファンジビリティ(代替可能性)の利点を持つ環境を提供できる」と説明している。

関連記事

生成AIで注目の「RAG」を試せる環境を「Open WebUI」で構築 GPU活用による高速化もチャレンジしてみよう

生成AIで注目の「RAG」を試せる環境を「Open WebUI」で構築 GPU活用による高速化もチャレンジしてみよう

気軽に試せるラップトップ環境で、チャットbotを提供するオールインワンの生成AI環境構築から始め、Kubernetesを活用した本格的なGPUクラスタの構築やモデルのファインチューニングまで解説する本連載。今回は、生成AIで注目の「RAG」を試せる環境を「Open WebUI」で構築する方法など、Open WebUIを本格活用するためのポイントを解説します。 Kubernetesの本番運用が8割の今、セキュリティが最大の課題だったクラウドネイティブ活用はどう変化した?

Kubernetesの本番運用が8割の今、セキュリティが最大の課題だったクラウドネイティブ活用はどう変化した?

Cloud Native Computing Foundation(CNCF)は、クラウドネイティブ技術の導入状況に関する12回目の年次調査の結果をまとめたレポート「Cloud Native 2024」を発表した。 NVIDIA、AIエージェントに重要なリーズニングも高速化する「Blackwell Ultra」を発表 その特徴と性能は?

NVIDIA、AIエージェントに重要なリーズニングも高速化する「Blackwell Ultra」を発表 その特徴と性能は?

NVIDIAは、約1年前に発表したAIファクトリープラットフォーム「NVIDIA Blackwell」の後継となる「NVIDIA Blackwell Ultra」を発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.