ローカルLLMって何? メリット、デメリット、活用例を分かりやすく解説

ローカルLLMは、クラウドサービスではなく、社内サーバやクライアント端末上でLLMを利用できる技術だ。本記事では、GPUコストや運用面に不安を抱えるIT部門、情報システム担当者、経営層向けに、ローカルLLMの概要と導入のポイントを分かりやすく解説する。

「ローカルLLM(大規模言語モデル)とは何か」「生成AI(人工知能)の便利さを享受したいが、クラウドサービスだとGPU(Graphics Processing Unit)インスタンスや運用にかかるコストが不安」。そんな疑問や悩みを抱えるIT部門、情報システム担当者、そして開発コストとスピードに敏感な経営層に向けて、本記事ではローカルLLMの概要から導入ポイントまでを解説する。

ローカルLLMとは

ローカルLLMとは、LLMをクラウドのマネージドサービスに頼らず、社内サーバなどのローカル環境で学習、推論できる形で実装したものを指す。注目される理由は「通信を社内ネットワークの外に出さない」「レイテンシの少なさ」「カスタマイズのしやすさ」の3つがそろうためだ。

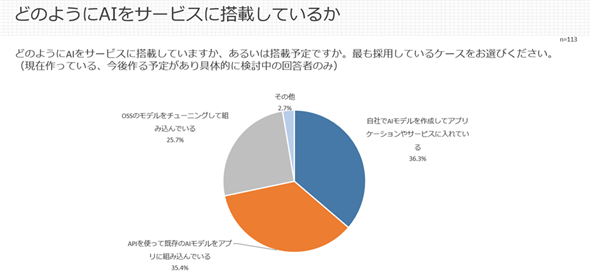

この注目度の高さを裏付ける調査結果がある。2025年4月に実施した@IT読者アンケート(※1)のサービスにAIを搭載する方法を聞いた質問で、「自社でAIモデルを作成」(36.3%)と「OSS(オープンソースソフトウェア)のモデルをチューニングして組み込んでいる」(25.7%)を合わせた、いわゆるローカル環境での実装(計62.0%)が「API利用」(35.4%)を大きく上回る結果となった。

特に、2024年に実施した調査と比較して「OSSモデル利用」が8.9ポイント増加している。これは、AI開発が具体化する中で、柔軟性の観点からオープンソースのLLMを自社環境で活用することが、現実的な選択肢として強く意識され始めていることの表れといえる。

調査ではAIモデル全般を対象としており、この結果がそのままローカルLLMへの注目の表れと断定できるわけではない。しかし、目的や要件に応じてローカル環境でLLMを実装することが、選択肢としても注目度が高まっていることを示唆している。

(※1)@IT読者意識調査2025年4月「アジャイル・DevOps編」

ローカルLLMの3つの特徴

1.規制&ガバナンス強化

各国の 個人情報保護法などの法規制によりデータ越境転送への圧力が増大している。”クラウド型LLM”を全面採用すると監査コストが跳ね上がるため、「社内完結」が経営判断の重要項目になっている。

2.運用コストの可視化

”クラウド型LLM”のコストは「トークン数×単価」でスパイクが読みにくいのに対し、ローカルLLMにかかるコストはハードウェア購入と電気代が主となる。設備を5年償却にすると月額単位でランニングコストを計算でき、コストを予測しやすい。

3.オープンソースLLMの高性能化

性能も高まっている。例えば、「Microsoft Phi-4-Reasoning」は14B(14億)パラメーターながらも「DeepSeek-R1 distilled 70B」モデルなどの大規模モデルを広範な推論ベンチマークで上回りことが多く、単一GPUでの運用が可能な小型モデルとして注目されている。

ローカルLLMの5つのメリット

メリット1:セキュリティとデータ主権

ローカルLLMは外部ネットワークへ通信を出さないため、中間者攻撃(MITM:Man-In-The-Middle攻撃)などのリスクを低減する。また、利用ログを全て社内のSIEM(Security Information and Event Management)に統合できるので、証跡を一元管理しやすく、迅速な監査対応が可能になる。

メリット2:レイテンシ削減

”クラウド型LLM”がインターネットを経由して応答を返すのに対し、ローカルLLMはPCや社内サーバで処理が完結する。このため、通信の往復時間(ラウンドトリップタイム)が抑えられ、ストレスのない応答速度が期待できる。

メリット3:オフラインでも利用できる

ローカルLLMは、インターネットに接続できない環境でも学習、推論できる。航空機内や山間部、またはセキュリティ対策の観点でインターネット接続を遮断した工場など、通信が不安定または不可能な場所でも、AIの利用を継続できる。モデルの追加学習(ファインチューニング)もオフラインで完結できるため、外部に持ち出せない機密性の高いデータを安全に活用し、独自のAIモデルを継続的に構築、改善し続けることができる。

エッジLLMもローカルLLMと同様にオフラインで動作するが、利用するハードウェアとモデルの規模が異なる。エッジLLMがスマートフォンなどの端末で軽量モデルを動かすことを主目的とするのに対し、ローカルLLMは高性能なPCやサーバの計算能力を活用して学習、推論する。そのため、より大規模なモデルの学習から高精度な推論までを実行できる。

メリット4:カスタマイズ(ファインチューニング)自由度の高さ

ローカルLLMは、財務や顧客などに関わる社内の機密データを外部に出すことなく、クローズドな環境で安全にモデルへ反映できる。

クラウドLLMでもモデルのカスタマイズ(ファインチューニング)は可能だが、学習のために社内の機密データをクラウド環境へアップロードする必要がある。また、プラットフォームが提供する手順やモデルに縛られ、最新の技術を柔軟に試すことが難しい場合もある。

QLoRAやPEFT(Parameter-Efficient Fine Tuning)などの軽量学習手法を使うと、ファインチューニングに必要なVRAMを8〜24GB程度に抑えられる。これにより、クラウドの複雑な手順や制約を待つことなく、手元のPCやサーバで組織独自のモデルをすぐに何度でも試作、改善できる。

メリット5:コスト予見性とTCO削減

”クラウド型LLM”の従量課金とは異なり、主な費用が自社で調達したハードウェアと電力に限定されるため、ランニングコストをあらかじめ把握しやすい。初期投資は必要となるが、利用量が増えても月ごとの追加課金は発生せず、将来の予算計画を立てやすくなる。大量のリクエストを長期間処理する用途では、クラウド利用に比べ総保有コスト(TCO)を抑えられるケースがある。

ローカルLLMの3つのデメリット

デメリット1:知識の陳腐化と、自社で担う更新作業

ローカルLLMは、学習時点の知識にAIが固定されており、最新情報を自律的に取り込めない。情報を最新に保つためには追加作業が必須だ。より新しいデータで学習されたモデルを利用したい場合も、既に施したファインチューニングを再度適用する作業が発生する。一方、”クラウド型LLM”の場合、ベンダーが情報をアップデートするためユーザーは提供される新しいモデルへ切り替えるだけでよい。

デメリット2:ハードウェア&電力コスト

高性能GPUは発熱と消費電力が大きく、常時稼働させると電源容量や空調の追加対応が避けられない。ラックスペース、UPS(無停電電源装置)、冷却設備などの間接費も増える。電力制限や騒音対策など、設置場所による制約も考慮が必要となる。

デメリット3:全レイヤーに及ぶ運用保守の責任と専門体制

”クラウド型LLM”を利用する場合、モデル自体や基盤インフラの運用保守はベンダーが担う「責任共有モデル」が一般的だ。しかしローカルLLMは、運用保守の責任がインフラからモデル、アプリケーションまで全レイヤーに及ぶ。

例えば、利用するOSSモデルや推論サーバ、さらにはGPUドライバといったモデルを取り巻くエコシステム全体に脆弱(ぜいじゃく)性が発見された場合、その情報収集からパッチ適用、依存関係の解消までを全て自社で実施する必要がある。

ローカルLLMの主な活用例

| 活用領域 | 具体例 |

|---|---|

| 情報検索、要約 | 社内ナレッジbot、契約書/論文の自動要約 |

| ソフトウェア開発 | オフラインコード補完、セキュリティ静的解析 |

| 音声・映像処理 | 現場作業員向けAR(拡張現実)グラスの音声翻訳 |

| 規制産業 | 金融機関のリスクレポート草稿、医療問診の暫定案生成 |

| エッジIoT | 製造ライン端末での異常検知、対話型操作パネル |

ローカルLLMに向いているケース、向かないケース

向いているケース

- 法務、医療など高機密データを扱う場合

- 常時接続できない工場や船舶、山間部の現場

- APIトークンコストが月100万円を超える大規模利用

向かないケース

- 最新ニュースやSNSトレンドを扱うサービス(RAG〈検索拡張生成〉追加必須)

- GPU投資予算を確保できない中小規模の利用

- 数十言語の多国籍ユーザー向けのケース(多言語モデルの更新が必要になる)

おすすめのローカルLLM

Meta Llama 4 Scout 17B(※2)

- 2025年4月リリース。画像+テキストのマルチモーダルと長文処理を同時に実現

- トークンごとに最適と思われるエキスパートを呼び出すMixture-of-Experts (MoE)アーキテクチャで構築され、精度と計算量のバランスをとっている

(※2)https://ai.meta.com/blog/llama-4-multimodal-intelligence/

Mistral Magistral Small 24B(※3)

- 2025年6月リリースの推論モデル。Apache 2.0ライセンスで商用利用、再配布が自由

- 思考過程を出力するテンプレートを備え、根拠説明が求められる場面に適している

(※3)https://mistral.ai/news/magistral

Microsoft Phi-4 14B(※4)

- 2025年1月リリースの単一GPU運用が可能な小型モデル。MITライセンスで個人開発にも適している

- 数学、科学、コーディングの複雑推論で70B以上のモデルを超えるベンチマークを示したという

(※4)https://azure.microsoft.com/en-us/blog/one-year-of-phi-small-language-models-making-big-leaps-in-ai/

ローカルLLM導入を成功させるためのポイント

1.導入前の要件整理

- ユースケースを5W1Hで記述(誰が、何を、いつ、どこで、どの程度使うか)する

- レイテンシ要件(例:応答1秒以内)と同時接続ユーザー数をKPI(重要業績評価指標)で定義する

2.適切なツール選定

下図のようなツールを選定する。

| レイヤー | 主な選択肢 | 選定ポイント |

|---|---|---|

| モデル | Meta Llama 4 Scout 17B、Mistral Magistral Small 24B、Microsoft Phi-4 14B | 日本語性能、商用ライセンス |

| 推論エンジン | vLLM、Ollama、llama.cpp | スケールアウトの容易さ |

| ファインチューニング | QLoRA、LoRA、PEFT | GPUメモリ要件と実装難易度 |

| 監視 | Prometheus + Grafana | GPU使用率、応答時間の可視化 |

3.運用・保守体制の確立

- MLOpsパイプラインをCI/CD(継続的インテグレーション/継続的デリバリー)と統合(MLflow + GitHub Actions)

- 週次でベンチマークを自動実行し、精度劣化を検知

- ハード障害に備えたGPU冗長構成+バックアップ電源

ローカルLLMについて、もっと知りたくなったら

@ITでは、ローカルLLMだけでなくLLMやAIに関する記事も多く掲載しているので、ご参考に。

関連記事

生成AIの必修用語10選 〜 もはや現代人の新常識に

生成AIの必修用語10選 〜 もはや現代人の新常識に

社会人から学生まで、今や現代人の大半は生成AIと無縁ではいられないでしょう。もはや“常識”となりつつある用語として「AI」「生成AI」「AGI」「ASI」「AIアライメント」「LLM」「ローカルLLM」「マルチモーダルAI」「エッジAI」「AIエージェント」の10語を紹介します。 ChatGPTライクなUIのローカルLLMを構築できるGPT4Allとは?

ChatGPTライクなUIのローカルLLMを構築できるGPT4Allとは?

ChatGPTやMicrosoft Copilotなどの生成AIサービスは「情報漏えいなどが心配」と感じているのならば、手元のWindows 10/11上でLLM(大規模言語モデル)を実行すればよい。ChatGPTライクなユーザーインタフェースを持つ「GPT4All」を使えば、簡単にLLMが利用可能だ。その使い方を紹介しよう。 ローカルLLM(Local LLM)とは?

ローカルLLM(Local LLM)とは?

ローカルLLMとは、ユーザーが所有するローカル環境(PCやエッジデバイスなど)で直接動作するLLM(大規模言語モデル)、またはその仕組みのこと。データをクラウドに送信せずにローカル環境内で処理するため、プライバシーが保護される。特定のタスクや業界向けの調整がしやすいメリットもある。

Copyright © ITmedia, Inc. All Rights Reserved.

本記事は制作段階でChatGPT等の生成系AIサービスを利用していますが、文責は編集部に帰属します。