ローカルLLM(Local LLM)とは?:AI・機械学習の用語辞典

ローカルLLMとは、ユーザーが所有するローカル環境(PCやエッジデバイスなど)で直接動作するLLM(大規模言語モデル)、またはその仕組みのこと。データをクラウドに送信せずにローカル環境内で処理するため、プライバシーが保護される。特定のタスクや業界向けの調整がしやすいメリットもある。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

用語解説

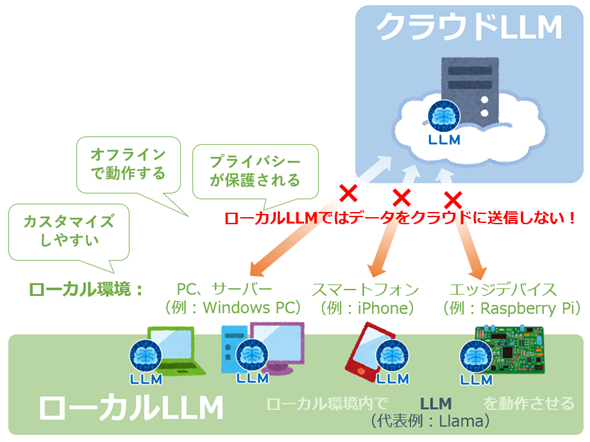

ローカルLLM(Local LLM)とは、クラウド環境ではなく、ユーザーが所有するローカル環境(PC、オンプレミスサーバー、スマートフォン、エッジデバイスなど)で直接動作する大規模言語モデル(LLM)のこと、またはそれを動作させる仕組みを指す。例えば、ノートPCにLLMの一つであるLlama(「ラマ」と読む、Meta社が公開するLLM)を入れて、自分だけのチャットボット(チャットAI)を動かす、そんなことがローカルLLMなら可能だ。

比較: ローカルLLM vs. クラウドLLM

「ローカルLLM」と対照的な概念として「クラウドLLM」が挙げられるだろう。この場合のクラウドLLM(Cloud-based LLM)とは、クラウド環境上で動作するLLMのこと、またはそれを動作させる仕組みを指す。例えば、インターネットのWebサイトを通じてチャットできるChatGPTや、その内部で動作するLLM(2024年12月17日時点では例えば、OpenAIが提供するGPT-4oやo1など)が、クラウドLLMの典型的な例である。

クラウドLLMは、インターネットさえあれば即座に利用できるという大きな利点を持つ。例えばPC上のWebブラウザや、スマートフォン/タブレットのアプリから簡単にアクセス可能で、手元に高性能なハードウェア環境を用意する必要がない。専門知識も不要で、誰でも手軽に利用できるという点が大きな魅力だ。

一方でローカルLLMの特性と利点は、クラウドLLMのそれとは異なり、以下のような特徴が挙げられる。

- オフラインで動作する: クラウド接続なしでも利用可能で、インターネット環境に依存しない。

- プライバシー保護: データをローカルで処理するため、センシティブな情報を外部に送信しない。

- カスタマイズしやすい: 特定のタスクや業界向けにモデルを調整すること(例:ファインチューニングで独自のデータを用いてモデル性能を向上させるなど)が可能。

- コスト効率が高い場合もある: クラウド利用料金が不要なため、大量データを長時間処理する場合にはコストを抑えられることがある。

このためローカルLLMは、インターネットに接続できない(または不安定な)環境や、高度なプライバシー保護が求められるシナリオで特に有用だ。個人が手元で動かして、チャットボットや文章生成といったユースケースを試すのも人気である(例:WindowsでローカルLLMを利用する方法を紹介している記事)。また、特定の業界や企業が抱える独自のニーズに応じたカスタマイズも容易である点から、金融や医療、製造業など幅広い分野で利用が進んでおり、企業向けの用途でも大いに注目されている。

ただしローカルLLMには、以下のような課題も存在する。これらは「クラウドLLMとは真逆の特性」と言えるだろう。

- ハードウェア要件: 高性能なGPUや大量のメモリが必要な場合があり、一般的なPCでは扱えないことがある。そのため、個人利用ではハードルが高い場合がある。

- 初期設定の難易度: モデルのインストールや設定、調整(例:ファインチューニング)には高度な技術が求められる場合がある。

- モデルのアップデート: 最新の研究成果を取り入れるためには、モデルの更新や再調整などが必要になる。

最後に、ローカルLLMとして使える代表的なものを紹介する。

代表的なローカルLLM

LLMは、各企業や組織の公式サイトなどでダウンロードできる場合や、企業向けのみに非公開で提供されている場合もある。また、AIモデルを簡単に参照したり利用したりできるAIコミュニティーのHugging Face(「ハギングフェイス」と読む)には、数多くのLLMが公開されている。それらのLLMの多くがローカル環境で動かせるため、「ローカルLLM」と呼べるモデルは非常に多い。その中でも執筆時点(2024年12月17日現在)で特に代表的なものを幾つか紹介しておこう。

- Llama: Meta社が公開するLLMで、多くの派生モデル(後述のELYZA LLMやSwallow LLMなど)を生み出している。公式サイトからダウンロードできる他、Hugging Faceのmeta-llama(Meta Llama)から利用可能。

- ELYZA LLM for JP: ELYZA(イライザ)社が開発する日本語性能に優れるLLMで、Llamaをベースに追加学習されている。最新モデルは企業向けに提供されているが、一部のモデルはHugging Faceのelyza(ELYZA.inc)から利用できる。

- Swallow LLM: 東京科学大学(旧・東京工業大学)と国立研究開発法人の産総研(産業技術総合研究所)が開発する日本語性能に優れるLLMで、Llamaをベースに追加学習されている。モデルはHugging Faceのtokyotech-llm(tokyotech-llm)から利用でき、研究と商業目的に使える(詳しいライセンス条件は公式ページを確認してほしい)。

Hugging Faceで公開されているモデルは、Hugging FaceのTransformersライブラリ(Pythonパッケージ)を使用することで数行のコードでモデルを動かせるので手軽だ。ただし、Transformersライブラリではチャット機能の実装が必要であったりと手間がかかる場合もある。そのため、より簡単にLLMを利用できるツールとして、あらかじめチャット機能が組み込まれたものも登場している。代表的なツールを1つ紹介しておこう。

- Ollama: macOS/Linux/Windows OSに対応しており、ターミナル上で簡単なコマンドを実行するだけで、ローカル環境でLLMが使える。先ほど「WindowsでローカルLLMを利用する方法」として紹介した記事では、このOllamaが使われている。

Copyright© Digital Advantage Corp. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ