より高速で長時間タスク対応の「GPT-5.1-Codex-Max」がCodexモデルを置き換え? GitHub Copilotなどで利用可能に:Deep Insider Brief ― 技術の“今”にひと言コメント

GitHub Copilotなどにもようやく追加されたOpenAIの新モデル「GPT-5.1-Codex-Max」。静かに進むCodexの世代交代と、性能向上や長時間タスク対応といった開発者が押さえるべき進化ポイントを解説する。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

多くの開発者が日常的に利用しているGitHub CopilotやCursorのモデル選択リストに、「GPT-5.1-Codex-Max」という名称が追加されたことに気付いただろうか。大きな話題にはなっていないものの、2025年12月4日(米国時間、以下同)より、各種AI開発ツールやOpenRouterなどのAPIで、この新しいCodex系モデルが利用可能になっている。

GPT-5.1-Codex-Maxそのものは、11月19日に既に発表されていた。当初はOpenAI Codex(ターミナルで利用できるCLIツールなど)内で限定的に提供されており、前日に発表されたGemini 3 Proの衝撃を緩和するために“名前だけ先行して発表したのではないか”という見方もあった。しかしその後、約2週間をかけて提供範囲が広がり、ようやく幅広い開発環境で正式に使えるようになった、ということになる。

一見すると、Maxモデルは「触らなくてもよい一時的なモデル」のように思えるかもしれない。しかし、このモデルは実は重要だ。OpenAIはMaxモデルを現行のCodexモデルの後継として位置付けており、順次置き換えていく方針を示している。性能面でも改善が見られ、特に応答速度は従来のCodexやCodex-Miniより高速であることが、OpenAI公式サイトのモデル比較ページで確認できる。また、思考トークン数を30%程度も抑えた効率的な処理が可能になる場面もあるとされる。

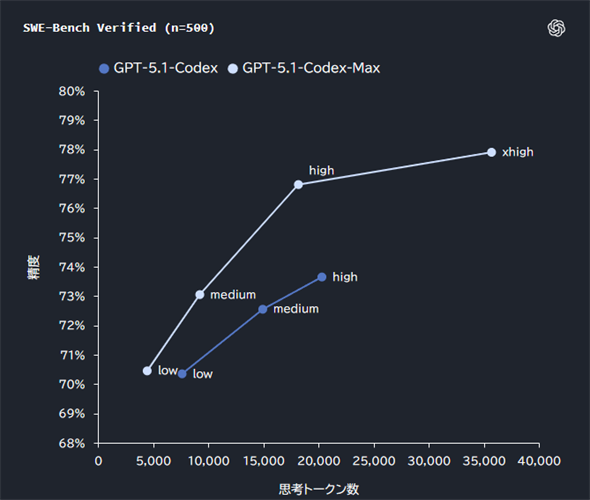

ソフトウェアエンジニアリング分野のベンチマーク(SWE-bench Verified)におけるコーディング性能比較(公式発表ページより引用)

ソフトウェアエンジニアリング分野のベンチマーク(SWE-bench Verified)におけるコーディング性能比較(公式発表ページより引用)横軸はモデルが内部で使用した思考トークン数(reasoning tokens)、縦軸は「課題を正しく解決できた割合(%)」を表しており、上に行くほどコード生成や修正タスクの精度が高いことを意味する。濃い線が従来のGPT-5.1-Codex、薄い線がGPT-5.1-Codex-Maxを示しており、同じリーズニングレベル(low/medium/high)で比較すると、Maxはより少ない思考トークン数で同等以上の精度を達成している。さらに、Maxのみに用意されたxhigh設定では精度がおよそ78%まで伸びており、Codex系モデルの中で最も高いスコアを記録している。

今回のMaxモデルでは、思考プロセス(リーズニング)の最適化による思考トークン削減に加え、コンパクション(Compaction:圧縮)と呼ばれる新しいコンテキスト圧縮技術が導入された。コンパクションは長時間タスク中のリーズニングや会話の履歴を自動で圧縮して保持する仕組みで、チャットが長引いてもコンテキスト(文脈)が失われにくく、複雑な作業が継続しやすくなる。

この技術により、Maxモデルは非常に長い指示や作業履歴を扱えるようになり、単一のタスクでも“数百万トークン規模”のコンテキストを維持できる設計になっている。例えば、長い工程を伴うコーディング作業(long-horizon coding)も途切れず進められるとOpenAIは説明している。また、社内テストでは24時間以上にわたり連続してエンジニアリング作業を進められた例もあったとされる。

――ここからは『Deep Insider Brief』恒例の“ひと言コメント”として、今回の動きを手がかりに技術の“今”をもう少し深く眺めてみたい。

Deep Insider編集長の一色です。こんにちは。

「OpenAIは名前付けが分かりづらい」とよく言われますが、今回の「GPT-5.1-Codex-Max」もその典型例です。本来は従来の標準モデル「GPT-5.1-Codex」の後継なのに、名称だけを見ると“上位版の追加モデル”のように見えてしまい、「どれが標準で、どれが上位なのか」が非常に判別しづらい構成になっています。

また、Max専用の思考モードとして「xhigh(Extra High)」が追加されました。これは応答速度(レイテンシ)を犠牲にして、より長く深く考えさせたいときに使うモードです。ただし、通常のコーディング作業ではmediumが推奨されており、xhighを使う場面はそれほど多くないでしょう。なお、xhighを明示的に指定できるのは現状、OpenAI Codexの各種ツールやAPIなどで、GitHub Copilotなど一部の環境では選択肢として表示されない点には注意してください。

いずれにしても、今後はMaxモデルがCodex系列の“標準”として扱われていく流れです。価格は従来版と同じにもかかわらず、応答速度や長時間タスクへの耐性は向上しています。現在、GPT-5.1-Codexを利用している方は、早めにMaxモデルへ切り替えておくのがお勧めです。

最後に、GPT-5.1-Codex-Maxは、OpenAIとして初めて「Windows環境で動作するように学習された」モデルでもある。これにより、Windowsを利用する開発者にとって、実際の作業環境により適した動作を期待できるとしている。

情報元

Copyright© Digital Advantage Corp. All Rights Reserved.