第308回 NVIDIAの一強は続くのか? 新プラットフォーム「Rubin」が描くエコシステムとDRAM危機の正体:頭脳放談

NVIDIAが新プラットフォーム「Rubin」を発表。AI需要の爆発によりDRAM不足が深刻化し、PCやスマホの供給にも影響が出始めている。単なるチップから「エコシステム」へと進化し、ネットワークやストレージまでをも飲み込もうとするNVIDIAの戦略と、AIへの過度な投資が招く世界規模のリスクを考察する。

NVIDIAの新プラットフォーム「Rubin」が描くエコシステムとDRAM危機の正体

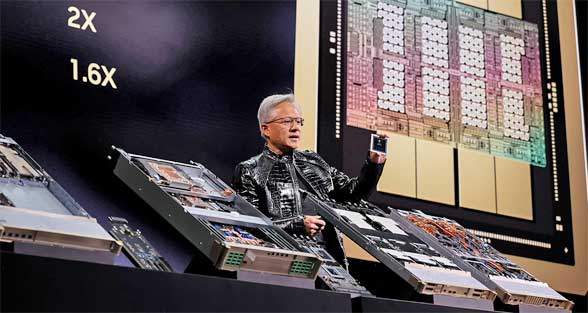

NVIDIAの新プラットフォーム「Rubin」が描くエコシステムとDRAM危機の正体NVIDIAがCES 2026で新プラットフォーム「Rubin」を発表。AI需要の爆発によりDRAM不足が深刻化し、PCやスマホの供給にも影響が出始めている。単なるチップから「エコシステム」へと進化し、ネットワークやストレージまでをも飲み込もうとするNVIDIAの戦略と、AIへの過度な投資が招く世界規模のリスクを考察する。写真は、NVIDIAのプレスリリース「NVIDIA Rubin Platform, Open Models, Autonomous Driving: NVIDIA Presents Blueprint for the Future at CES」より。

みなさんご存じだと思うのだが、DRAMの供給不安のニュースを最近よく聞くようになった(Tech News「『安価なメモリ』の時代は終焉へ。AI需要が招く世界的なメモリ、ストレージ不足、PCとスマホ価格への深刻な打撃」参照のこと)。AI(人工知能)用プラットフォーム(データセンター)がDRAMを大量消費していることが原因だという。その影響は既にメモリやSSDの値上がりとして表面化しており、DRAM調達の困難からPCベンダーが受注を停止するといった事態も相次いでいる。

データセンターが使用するのは、「HBM(High Bandwidth Memory)」と呼ばれるような高性能デバイスだ。それで限られた分野の話かと言えば違う。現在DRAMを生産できる半導体ベンダーというのは長年の淘汰(とうた)で、「Samsung Electronics」「SK Hynix」「Micron Technology」の3社程度に限られている。限られたDRAM生産能力をHBMに傾斜配分すれば、安いはずの汎用DRAMにもしわ寄せが行くのは自明の理だ。

AIがDRAMを大量に飲み込んでしまうために、そのあおりがAI利用者である末端のユーザーのPCやスマートフォンの供給にまで影響を及ぼすというのは、ある種の本末転倒にも思える。しかし、それでDRAM調達に躊躇(ちゅうちょ)しているようでは、AIベンダーの担当者は責任を問われかねない。まさに引くに引けない競争が繰り広げられているのだ。

DRAMの件をはじめ、AIにあまりに資源が集中し過ぎていないかと不安になる今日この頃である。株式市場における「クジラ」や「ゴジラ」のような巨大な投資規模、地球の許容範囲を超えかねない消費電力量、そして製造業のキーデバイスである半導体生産を左右する単一にして最大の需要者。AIはあらゆる面で突出した存在となっている。

NVIDIAの次世代プラットフォーム「Rubin」の正体

こうしたAI一極集中が続く中、その中心に君臨するNVIDIAが新たなAIプラットフォーム「Rubin(ルービン)」を発表した(NVIDIAのプレスリリース「NVIDIA Rubin Platform, Open Models, Autonomous Driving: NVIDIA Presents Blueprint for the Future at CES」)。もちろん、ターゲットは生成AI、主としてデータセンター向けの高性能製品である。2026年1月の電子機器の見本市「CES 2026」で披露されたが、その構想は数年前に予告されていたものだ。

NVIDIAの次世代プラットフォーム「Rubin」

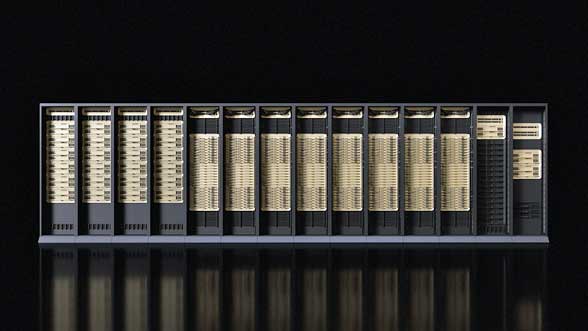

NVIDIAの次世代プラットフォーム「Rubin」Rubinのターゲットは、このラックの写真を見ても分かる通り、生成AIを中心としたデータセンター向けだ。写真は、NVIDIAのプレスリリース「NVIDIA Kicks Off the Next Generation of AI With Rubin - Six New Chips, One Incredible AI Supercomputer」より。

「Rubin」という名前を聞いたとき、無知蒙昧(もうまい)な筆者はピンとこなかった。しかし、歴代製品(「Maxwell」「Tesla」など)に偉大な学者の名前を冠してきたNVIDIAである。その例に漏れず、「ダークマターの母」として知られる天文学者、Vera Rubin(ヴェラ・ルービン)氏から名付けられているそうだ。しっかり過去の命名の系譜に連なるお方じゃないかと思う。それもあってか、GPU部分はRubin、CPU(Armベースコア多数からなる)部分は、「Vera(ベラ)」と呼ばれているようだ(コアの設計自体には別の名が付けられているらしい)。

このRubinを一言で表すなら、半導体チップではなくシステムである。NVIDIAは「エコシステム」と呼んでいる。ハードウェアやソフトウェアの枠を超えた、ビジネス的な「生態系」を成立させるプラットフォームという認識だろう。

生態系を成り立たせるのは、NVIDIAを中心に巨大なAIデータセンターを運営するプラットフォーマーということになるだろう。並みの会社がそういう風呂敷を広げると鼻で笑われるのが落ちだが、市場を支配するNVIDIAの場合は違う。

大風呂敷を広げるのは、NVIDIAの守備範囲を旧来の半導体チップ部分から外へ外へと押し広げていかないと、機能性能を向上させるという面でも、ビジネス規模を大きくする面でも頭打ちになりかねないということがあるのだろう。

NVIDIAの役割を中心の半導体から外へ外へと広げる一方、その上で走らせる応用は、生成AIへとフォーカスをしぼり込んでいくのだ。桁違いの最大の市場がそこにあるからだ。その様子を、最近の何世代かのNIVIDA製品を振り返って確認したい。

歴代GPUから見えてくる、NVIDIAの「守備範囲」の拡大

近年のNVIDIA製品を振り返ると、その進化の過程がよく分かる。

3世代前になる「Ampere(アンペア)」から見ていこう。この世代は単品の半導体チップとしてのGPUらしさが残る最後の世代ではないかと思う。GPGPU(General-Purpose GPU)のGP、つまり「汎用の」並列な計算機というコンセプトにまだ合致しているのではないかと思う。もちろん、AI応用のために「FP16(16bit浮動小数点)」のような汎用の浮動小数点演算では使われないAI特化機能も盛り込んではいるのだが。

これが2世代前の「Hopper(ホッパー)」になると、フォーカスがさらに絞られてくるのが見てとれる。ChatGPTの台頭に呼応し、大規模言語モデル(LLM)に対応したエンジンになってくるのだ。より限定的な用途向けのデータ型「FP8(8bit浮動小数点)」がサポートされてくる。

一方、使用するDRAMは、Ampere世代のHBM2eからHBM3へグレードアップされ、より高速な転送も可能になる。しかし当然、消費電力は大きくなっている。

1世代前の「Blackwell(ブラックウェル)」になると、これまでのGPUという旧来の守備範囲からは大きく踏み出してくる。集積度の点、消費電力の点で、単なる半導体チップの範囲では収拾がつかなくなってきたからだ。

Hopper世代のような単体GPU構成では巨大な規模のモダンなLLMを収容するのに非常に多くのGPUを並べることになる。その眺めはひと時代前のスパコン的な眺めだろう。しかし見た目に反して、外部、そして距離の遠い部分への接続は性能、消費電力ともに不利だ。

そこでこの世代では、とうとう液冷式のラックシステムの中にCPU(Armベース)とGPUを統合したものを多数並べる構成へと進化した。集積度は格段に上昇したものの、その分、発熱は大きくなっている。それを液冷で乗り切ってラックの中に巨大LLMを押し込めたということだ。データ型としてはさらにフォーカスがしぼられた「FP4(4bit浮動小数点)」が導入された。使用するDRAMはHBM3eだ。

そしてRubinの登場だ。RubinもBlackwell同様にラックシステム中心だと思う(デスクトップもあるようだ)が、モダンなLLMには新たな要求がある。巨大なストレージへの高速なアクセスである。モダンなLLMは巨大な背景知識を要求するからだ。

AI一極集中が孕む、地球規模のリスク

GPUは計算が速いことを主要命題として進化してきた。これはRubinでも同様だ。それで高速なメモリアクセスも追及してきた(Rubin世代ではHBM4)が、それは主として計算の足を引っ張らないための「チップ間」の高速性であった。しかしストレージとなるとレベルが違う。容量も形式も不明な存在に高速にアクセスできる経路の実装が必須である。ハードウェア的にはさらに一歩外側、通信というレベルまでNVIDIAの守備範囲に取り込んでしまったわけだ。

ハードウェア的には外へ外へと守備範囲を拡大して取り込み、応用的には巨大LLMにフォーカスを絞り込む。これにより、性能向上、運用コスト低下を図ってきた。そこはNVIDIAのもくろみ通りに成功している。これは半導体チップ内での改良のみに汲々(きゅうきゅう)としていたらとても達成できる話ではない。もちろん世代ごとに採用する半導体プロセスも新しいものにしてきたわけだが。

技術的には、こうした方向性の進化は合理的である。しかし、個人的には「とてつもない危うさ」を感じずにいられない。前述した通り、AIへの過度な集中、比喩でなく地球規模の急激なリソース投入、があるからだ。

好意的に捉えれば、DRAMの高騰は長年のDRAM覇権に代わるメモリ技術の勃興を促すかもしれない。またデータセンターの消費電力問題は新たな低消費電力の半導体技術の進展をもたらす可能性もある。

しかし、一歩間違うと恐ろしい事態を招くことになる。AIへの巨大投資のバブルが崩壊すれば、全世界的な経済変動、さらには政治変動への引き金を引きかねないからだ。私たちは止まれないチキンレースに足を踏み入れているのではないか。そんな恐怖感を禁じ得ないのである。

筆者紹介

Massa POP Izumida

日本では数少ないx86プロセッサのアーキテクト。某米国半導体メーカーで8bitと16bitの、日本のベンチャー企業でx86互換プロセッサの設計に従事する。その後、出版社の半導体事業部などを経て、現在は某半導体メーカーでヘテロジニアス マルチコアプロセッサを中心とした開発を行っている。

Copyright© Digital Advantage Corp. All Rights Reserved.