Baiduの人工音声合成「Deep Voice 3」は、大幅に進化している:「The Next Platform」で読むグローバルITトレンド(17)

中国の検索大手Baidu(百度)は最近、人工音声合成フレームワーク「Deep Voice 3」をリリースし、アルゴリズムとハードウェア効率の両面で目覚ましい前進を遂げた。2400人以上の話者の声を、短時間の訓練で合成できるようになった。

英国のIT専門媒体、「The Register」とも提携し、エンタープライズITのグローバルトレンドを先取りしている「The Next Platform」から、@IT編集部が独自の視点で“読むべき記事”をピックアップ。プラットフォーム3へのシフトが急速に進む今、IT担当者は何を見据え、何を考えるべきか、バリエーション豊かな記事を通じて、目指すべきゴールを考えるための指標を提供していきます。

ディープラーニングを利用した音声技術では音声認識が大きな注目を集めているが、ニューラルネットワークのアプローチによる人工音声の合成、あるいはテキスト読み上げ(TTS:text-to-speech)の技術開発も急速に進んでいる。

テキスト読み上げにおけるディープラーニングの目標は、他の音声関連のディープラーニング分野と同様に、訓練と推論にかかる時間を大幅に短縮し、サービスの迅速なリリース、省電力、ハードウェアリソースの有効活用を実現することにある。

ディープラーニングによる音声認識とTTSで先進的な成果を何度も達成している中国の検索大手Baidu(百度)は最近、TTSフレームワーク「Deep Voice 3」をリリースし、アルゴリズムとハードウェア効率の両面で目覚ましい前進を遂げた。

Deep Voice 3が前バージョンから大きく進化しているのが、人間の発声の再現性(実際の声にかなり近づいている)と推論の高速化だ。Deep Voice 3の合成音声は、ユーザーには、本人の音声サンプルを使用して短時間の訓練により合成された特定の人物の声のように聞こえる。

2017年夏にリリースされた最新バージョンは、30分間のスピーチサンプルに基づく訓練だけで、その話者の声を忠実に模倣した。また、この最新バージョンは、2400人以上の声から音声を合成できるようになっている。Baiduによると、その仕組みは特に、WaveNetモデルによる複雑性の取り込みに支えられている。

Baiduは、Deep Voice 3アーキテクチャのためにGPUカーネルを実装し、他のワークロードセクションをCPUで並列処理することで、20CPUコアと1GPUを搭載するサーバで、1日当たり1000万クエリ(1秒当たり116クエリ)に対応できることを確認している。

これはアプリケーションの観点から興味深いだけでなく、訓練と推論の効率化という点でも大きな進歩だ。Baiduは、このアーキテクチャのおかげで、これまでより格段に高速な訓練を行うことができ、800時間以上分の訓練データを基に、抑揚やアクセントがまちまちな多数の声から音声を合成できると説明している。

多数の話者の声を高速に合成できる理由

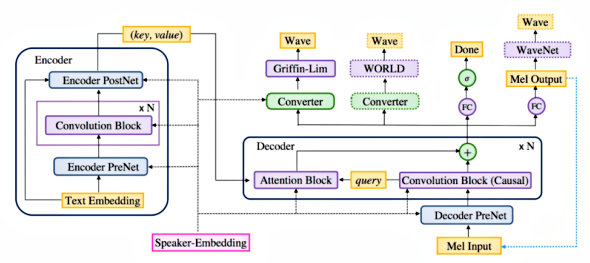

Deep Voice 3のアーキテクチャは完全畳み込みシーケンスtoシーケンスモデルであり、テキストを音響スペクトログラムなどの音響パラメータに変換し、音声波形合成法で使えるようにする。Baiduは話者の低次元埋め込みを利用して、データセットにおける数千人の話者間のばらつきをモデル化している。

Deep Voice 3のようなシーケンスtoシーケンスモデルは、エンコーダとデコーダから構成される。エンコーダは入力を、出力に関連する情報を含む埋め込みにマップする。デコーダは、こうした埋め込みから出力を生成する。だが、リカレント(再帰型)セルを使ってデータを順次処理する大半のシーケンスtoシーケンスアーキテクチャとは異なり、Deep Voice 3は完全畳み込みネットワークを採用しているため、計算の並列化が可能になり、ひいては非常に高速な訓練が実現する。

BaiduはDeep Voice 3を、最近公開されたアテンションベースのTTSシステム「Tacotron」と比較している。Deep Voice 3では、1個のGPUを使った1話者のデータの訓練における平均繰り返し時間(バッチサイズ4の場合)は、0.06秒であるのに対し、Tacotronでは0.59秒だ。これは、Deep Voice 3の方が10倍速い訓練速度を示している。

さらにBaiduの実験では、Deep Voice 3は3つのデータセット全てについて、50万回以下の繰り返しで収束する。一方、Tacotronの収束には200万回以下の繰り返しが必要だ(詳細はこちら)。Deep Voice 3の訓練速度が大幅に上回っているのは、完全畳み込みアーキテクチャを生かし、訓練の際にGPUの並列処理を活用しているからだと、Baiduは述べている。

2017年10月に発表されたDeep Voice 3に関する詳細な論文は、このアーキテクチャが訓練可能な話者の埋め込みによって強化され、多数の話者の声をいかに効果的に合成できるかを明らかにしている。この埋め込みを利用する手法は、Deep Voice 2の論文で説明されていたものだ。また、Deep Voice 3の論文は、Deep Voice 3システムが本番環境への対応が可能であることについても、テキストの正規化やパフォーマンス特性などを含めて包括的に解説している。さらに、幅広いMOS(平均オピニオン評点)評価を通じて最先端の品質も紹介している。

Baiduによると、今後の取り組みには「暗黙的に学習された書記素音素モデルの改良、ニューラルボコーダによる訓練の併用、数十万人の話者の声やアクセントのばらつき全体をモデル化するためのスケーリングを目的とした、よりクリーンで大規模なデータセットによる訓練」が含まれるという。

出典:Deep Voice 3: Ten Million Queries on a Single GPU Server(The Next Platform)

筆者 Nicole Hemsoth

former Editor in Chief of HPCwire

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ