Cloud AutoML Visionは、どう使えるサービスなのか:画像の機械学習を簡単に行える(2/2 ページ)

機械学習が終わると、評価画面が示される

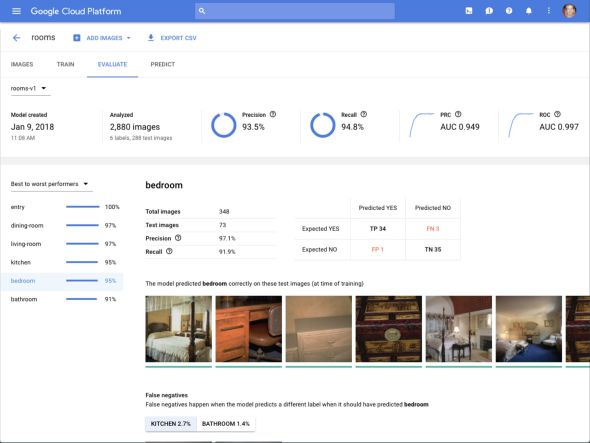

機械学習が終了すると、下図のような画面が表示される。ここで、適合率(Precision)、再現率(Recall)、偽陽性(False Positive)、真陽性(True Positive)などの指標を見ることができる。

Cloud AutoML Visionにおける機械学習の内容はブラックボックスであり、ユーザーが構築されたモデルの品質に不満足であっても、機械学習プロセス自体について手を加えるといったことはできない。ユーザー側ができるのは、訓練用の画像を増やし、あるいは訓練画像の品質を向上して、再訓練を行うことだ。

機械学習の選択肢は2つ

GoogleはCloud AutoML Visionで、機械学習に2つの選択肢を提供するとしている。1つは「転移学習により、短時間で行う機械学習」。もう1つは、「Learning to learnと呼ばれる手法を利用して、高精度を実現する機械学習」だ。前者の場合、機械学習の所要時間は「minutes」だという。この英語表現は通常、「1時間以内」を意味する。後者では、1日でモデルを構築できるとする。

Googleによる説明には、前者について「AIアプリケーションのパイロット運用」、後者については「本番運用」といった記述も見られるが、前出の大藪氏は、前者でも本番運用に使えるという。

Cloud AutoML Visionが今後、ベータから一般提供の段階に至っても、Googleが現時点で説明しているように、利用料金が消費リソース量に基づくのであれば、前者を選ぶユーザーが多くなると想定できる。

理由は次の通りだ。

GoogleはCloud AutoML Visionの料金体系について、現時点では機械学習で消費するコンピューティングリソース(および画像のストレージ量)に基づくと説明している。機械学習では、複数のプロセスが並列稼働する可能性があるため、前者であっても後者であっても、コンピューティングリソースがCloud AutoML Visionでどれくらい使われるのかをユーザーは制御できない。つまり、Cloud AutoML Visionの料金は、やってみないと分からない。

そうであれば、1日掛かるサービスよりも、1時間以内に終わるサービスの方が、費用が膨大になる可能性が低いという点で安心感がある。

少なくとも、ほぼ全てのユーザーは前者で試し、結果に満足できない場合に限って、後者を試すことになるだろう。

なお、前述の通り、Cloud AutoMLの機械学習プロセスはブラックボックスだ。構築されたモデルの品質については、現在のところGoogleを信じるしかない。

Googleの行っている説明の中には、「人気の高い公開されたデータセットであるImageNetやCIFERをCloud AutoML Visionを使った初期的な成果として、一般的な ML APIよりも少ない間違いで、より正確に分類することができた」といった記述はある。だが、精度について数値データは示されていない。Googleは、その理由の1つに、同サービスがまだアルファ段階であることを挙げている。

もし、品質の数値的な目安が示されたとしても、ユーザーは、自分のケースでどれくらいの精度が得られるか、前もって正確に知ることはできない。とはいえ、Cloud AutoML Visionと同種のサービスが増えてきたときに、どれを使うべきか選びにくいのも事実だ(Microsoft Azureでは、「Custom Vision Service」というサービスを、プレビュー提供している)。

機械学習の用途が広がる

一方、Cloud AutoML Visionが世界で最も優れた画像認識モデルを構築できるサービスかどうかにかかわらず、こうしたサービスが機械学習の用途を広げてくれるという期待がある。

今回のサービスを説明したGoogleの幹部たちも、「Googleが想定していないユニークな使い方を、ユーザーが生み出してくれるはず」との期待を示している。

ただし、このサービスが、あらゆる用途で、画像認識における画像のアップロードとラベル付け以外の作業を不要とするかというと、そうとは言えない。

例えば単純な話、画像中のどの部分(どのオブジェクト)を認識させたいかを教えるため、「アノテーション」などと呼ばれる作業が必要とされることがある。こうした作業は、現在のCloud AutoML Visionのサービス内容には含まれていない。

訓練画像の数や質について、専門家のアドバイスが求められる場面はこれからもあるだろうと、Googleでは説明している。

また、現在のところ、Cloud AutoML Visionで構築されたモデルは、外に取り出すことはできない。そのままGCP上で動かし、適用する。

だが、例えば機械学習ライブラリTensorFlowを使ってベビーフードの原材料不良検査を行っているキユーピーは、機械学習モデルを(現時点では)工場で動かしている。こうした検査の場合、応答速度の観点から、なるべく適用対象の近くでモデルを動かしたいケースは多いだろう。

参照記事:キユーピー、機械学習を生かした原料不良検査は、「現場力を生かすためのAI」の第1章

このように、訓練はクラウドで行うが、「構築されたモデルをローカルで動かしたい」というニーズが増えることは十分に予想できる。GCPでは、機械学習ライブラリTensorFlowをホストする「Google Cloud ML Engine」で、構築したモデルをユーザーが取り出し、任意の場所で動かせるようにしている。将来、Cloud AutoML Visionでも、ローカルにモデルを動かす方法が提供されるなら、このサービスの用途はさらに広がることになる。

Copyright © ITmedia, Inc. All Rights Reserved.