東北大学の研究グループが「AIの説明能力」を客観的に評価する方法論を構築:「この画像は犬ではないので猫です」は不正確

東北大学の塙一晃氏らの研究グループは、AIの説明能力を客観的に評価するための方法論を構築した。既存の手法には、最低限の要件を満たさないものがあり、それらには共通の特徴があったという。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

東北大学は2021年4月27日、同大学大学院情報科学研究科理化学研究所の研究員である塙一晃氏、助教授の横井祥氏、教授の乾健太郎氏と、大阪大学産業科学研究所の准教授である原聡氏の研究グループが、AI(人工知能)の説明能力を客観的に評価するための方法論を構築したと発表した。

「AIの判断」の根拠として過去の事例を提示

研究グループは「自動運転や機械翻訳など、機械学習手法がさまざまな分野に応用されており、その有用性が示されている。だが、機械学習で出力された判断の根拠は不明なことが多い。医療や教育の分野ではAIの判断理由が特に重要なため、AIの判断根拠を示すための研究を進めている」という。

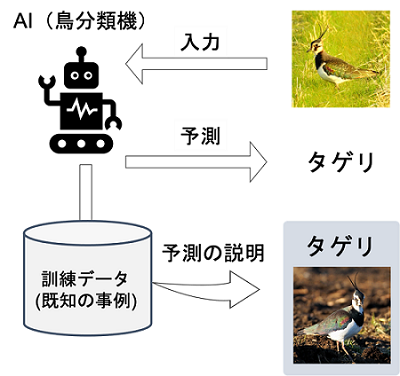

判断の根拠を示す方法として今回発表されたのが、判断で利用した「過去の類似事例」を提示する方法だ。これは、例えば画像の鳥の種類を当てる場合、AIが判断した鳥の名前と合わせて、別のその鳥の画像を提示するといった手法。「このよく似た画像が『タゲリ(ハト程度の大きさで、チドリ科の鳥。日本には冬に渡ってくる)』だからこの画像も『タゲリ』だと判断した」と判断根拠を示す。

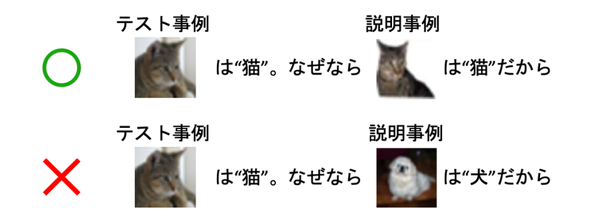

塙氏らの研究グループは、「類似事例に基づく説明可能AI」が適切な事例を提供しているのかを確かめるため、最低限満たすべき要件を定式化し、既存の手法群を再評価した。研究グループが定めた要件は「説明に用いる事例が、対象としている事例と同じクラスになっていなければならない」というもの。

例えば、AIがある画像を「猫」だと予測したとき、その根拠は「猫」の画像であるべきだという考え方だ。AIが「犬ではない特徴があるからこの画像は猫と判定した。その根拠は犬の画像だ」と「犬」の画像を提示されても、納得感は薄い。

研究グループはこの方法を使って既存の説明法を再評価した結果、「この要件を満たしていないものがあり、その原因を数理的に解明できた」としている。

関連記事

MITとIBMの研究者、自動プログラミングツールの弱点を発見し修正する方法を提案

MITとIBMの研究者、自動プログラミングツールの弱点を発見し修正する方法を提案

MITとIBMの研究者はディープラーニングに基づくコード処理モデルの弱点を発見し、モデルを再トレーニングして、攻撃に対する回復力を高める自動的な方法を発表した。 無料で受講できる「ディープラーニング講座」を開講 日本ディープラーニング協会

無料で受講できる「ディープラーニング講座」を開講 日本ディープラーニング協会

日本ディープラーニング協会は、新講座「AI For Everyone」を開講する。DeepLearning.AIが提供する非エンジニア向けのオンライン講座を基に、デジタルトランスフォーメーションの推進に向けたAI活用の重要性や、日本での活用事例などを盛り込んだ。 ディープフェイク検出システムをすり抜ける攻撃手法を実証、米国の研究チーム

ディープフェイク検出システムをすり抜ける攻撃手法を実証、米国の研究チーム

カリフォルニア大学サンディエゴ校の研究チームは、AIをだます新しい手法とその実証結果を発表した。実際の映像を改変操作したディープフェイク動画を検出するAIが対象だ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ