MITとIBMの研究者、自動プログラミングツールの弱点を発見し修正する方法を提案:セキュリティリスク低減に役立つ

MITとIBMの研究者はディープラーニングに基づくコード処理モデルの弱点を発見し、モデルを再トレーニングして、攻撃に対する回復力を高める自動的な方法を発表した。

マサチューセッツ工科大学(MIT)は2021年4月15日(米国時間)、自動プログラミングツールに関する研究成果を発表した。

MIT電気工学・コンピュータサイエンス学部の大学院生シャシャンク・スリカント氏と、MIT-IBM Watson AI Labによる最新の論文では、ディープラーニングに基づくコード処理モデルの弱点を発見し、モデルを再トレーニングして、攻撃に対する回復力を高める自動的な方法を扱っている。

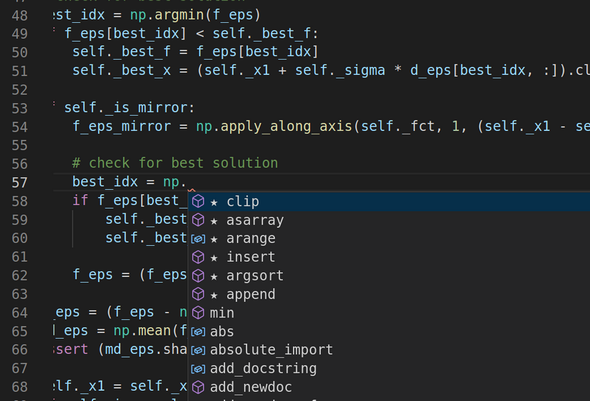

MITとIBMの研究者が開発したフレームワークは、自動プログラミングツールを攻撃の危険にさらす弱点を発見し、修正する。画像のツールは、開発者が記述するコードをリアルタイムで読み取り、コードを提案する。写真は、PythonのNumPyライブラリにある数千の選択肢から、タスクに最適な関数を選んでいるところ(出典:MIT、撮影:Shashank Srikant氏)

MITとIBMの研究者が開発したフレームワークは、自動プログラミングツールを攻撃の危険にさらす弱点を発見し、修正する。画像のツールは、開発者が記述するコードをリアルタイムで読み取り、コードを提案する。写真は、PythonのNumPyライブラリにある数千の選択肢から、タスクに最適な関数を選んでいるところ(出典:MIT、撮影:Shashank Srikant氏)現在、コンピューティング能力の飛躍的向上や自然言語処理の発展、インターネットで無償公開されている膨大なソースコードのおかげで、コード処理モデルを用いたソフトウェア設計の一部を自動化することが可能になった。

GitHubのようなソースコード共有サイトで公開されているコードでコード処理モデルをトレーニングすることで、プログラムの生成を学習させる。学習後はスマートアシスタントとして機能し、開発者が次にすることを予測して、支援を行う。

コード処理モデルはタスクに適したプログラムを提案したり、プログラムの要約を生成したり、ソフトウェアの仕組みを文書化したりできる。さらにバグを発見、修正するようにトレーニングすることもできる。

セキュリティリスクが紛れ込む

コード処理モデルには開発生産性やソフトウェア品質を高める可能性があるものの、セキュリティリスクも伴う。ここが研究チームの注目した課題だ。

スリカント氏などが参加する研究チームは、まず、コード処理モデルを簡単にだませることを発見した。コード処理モデルが処理しようとするプログラムのコードで変数名を変更したり、偽の出力ステートメントを挿入したりといったごく小規模な操作を行うだけでよい。このようにわずかに改変されたプログラムは、正常に機能するものの、同時にコード処理モデルをだまして処理を誤らせ、間違った判断に導いてしまう。

こうしたミスは、さまざまなコード処理モデルで深刻な結果につながる恐れがある。例えば、「マルウェア検知モデルが悪意あるプログラムを見落とす」「コード入力補完モデルが間違った、または悪意ある候補を提案する」といった具合だ。

ディープラーニングに基づく言語モデルの常として、コード処理モデルには、一つの決定的な欠陥がある。それは、コード処理モデルが単語とフレーズの間の統計的関係に関するエキスパートではあるものの、それらの本当の意味については、ごく漠然としか「理解」していないことだ。

スリカント氏はこう指摘する。「コード処理モデルがプログラムの本質的な特性を本当に学習していれば、だますことは難しいだろう。だが、今は比較的簡単にだませる」

コード処理モデルの弱点を指摘する

今回、研究チームは、自動的にプログラムを改変して、プログラムを処理するモデルの弱点を明らかにするフレームワークを提案した。このフレームワークが使用するアルゴリズムは、テキストの追加または置き換えによって、モデルに最大のミスを起こさせるプログラム中の位置を特定する。さらに、どんな編集を行うと、最大のミスが起こるのかも特定する。

研究チームによれば、このフレームワークは一部のコード処理モデルがいかに脆弱(ぜいじゃく)なのかを浮き彫りにしたと述べている。研究で使ったコード処理モデルは、ある種のテキスト要約モデルだ。このモデルはプログラムに対して編集を1回加えた場合、3分の1の割合でミスを犯し、編集が5回加えられた場合は、5割以上の割合でミスを犯した。一方、このモデルはミスから学習でき、その過程で、プログラミングをより深く理解する可能性があることも分かった。

「コード処理モデルを攻撃し、特定の弱点についてモデルを再トレーニングするわれわれのフレームワークは、コード処理モデルがプログラムの意図をより良く理解するのに役立つ可能性がある。これは、今後の探索が待たれるエキサイティングな方向性だ」(リュー氏)

今回の研究は、AIの活用によって自動プログラミングツールのスマート化とセキュリティを強化するため、MITの研究者ウナメイ・オライリー氏とIBMの提携研究者シジア・リュー氏が取り組んでいる研究の一環だ。

研究チームは2021年5月に、「International Conference on Learning Representations」で今回の研究成果を発表する。

関連記事

機械学習/ディープラーニングが無料で学べる、米国有名大学の「オンライン講座/講義動画」

機械学習/ディープラーニングが無料で学べる、米国有名大学の「オンライン講座/講義動画」

アメリカのスタンフォード大学/MIT/ハーバード大学/コロンビア大学/ニューヨーク大学といった有名大学の一部では機械学習や深層学習のオンライン講座/講義動画を無料で配信している。その概要と特長をまとめる。 SIも知っておくべき、ローコード開発でトラブルが起こる理由

SIも知っておくべき、ローコード開発でトラブルが起こる理由

「ローコード開発」に対する企業の関心が高まっているが、どう捉え、導入を進めればよいのか。考慮しておかなければならない点は何か。ガートナー ジャパンのアナリストに、ローコード開発の市場動向や注意点、今後の展望などを聞いた。 Microsoft、「Excel」の数式をベースにしたローコード言語「Microsoft Power Fx」を発表

Microsoft、「Excel」の数式をベースにしたローコード言語「Microsoft Power Fx」を発表

Microsoftは、「Excel」の数式をベースにしたオープンソースのローコードプログラミング言語「Microsoft Power Fx」を発表した。Excelの数式や関数に慣れていればノーコードやローコードで開発でき、他のプログラミング言語と組み合わせた「プロコード」でもアプリケーションを開発できるという。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ