超長文が処理できるオープンソース商用利用可LLM「MPT-7B」が公開:LLM最新モデル4種類のMPT-7Bが登場

MosaicMLはオープンソース、商用利用可のLLM最新モデル「MPT-7B」を発表した。この基本モデルを元に構築できるMPT-7B-Instruct、MPT-7B-Chat、MPT-7B-StoryWriter-65k+もあわせてリリースした。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

MosaicML Foundationは2023年5月5日(米国時間)、商業利用可能なオープンソースのLarge Language Models(LLM)、MPT(MosaicML Pretrained Transformer)シリーズをリリースした。最初のモデルである「MPT-7B」は、テキストとコードの1兆トークンをゼロから学習したトランスフォーマーモデルである。MPT-7Bにより、ユーザーはデータの準備からトレーニング、ファインチューニング、デプロイまで、プライベートなモデルを自ら構築できる。

MPTモデルシリーズは以下の4種である。

MPT-7B Base

ベースモデルの「MPT-7B Base」は、デコーダーのみを持つトランスフォーマーモデルで、67億のパラメータを持つ。1兆トークンのテキストとコードでトレーニングを行った。

MPT-7B-StoryWriter-65k+

「MPT-7B-StoryWriter-65k+」は読み書きを行うために設計されたモデルで、非常に長いコンテクストを扱うことができる。MPT-7Bを6万5000トークンのコンテキスト長でファインチューニングし、books3データセットのフィクション作品の一部を使用して構築された。6万5000トークンを超える推測も可能であり、A100-80GB GPUの単一ノードで8万4000トークンまでの生成を実証している。

MPT-7B-Instruct

「MPT-7B-Instruct」は短い指示で優れたパフォーマンスを発揮するモデルである。MPT-7BをDatabricks Dolly-15kおよびAnthropicのHelpful and Harmlessのデータセットでファインチューニングして構築した。

MPT-7B-Chat

「MPT-7B-Chat」は対話生成に特化したモデルである。MPT-7Bを「ShareGPT-Vicuna」「HC3」「Alpaca」「Helpful and Harmless」「Evol-Instruct」のデータセットでファインチューニングして構築した。

独自のカスタムMPTモデルの構築と展開

MosaicMLプラットフォームで独自のカスタムMPTモデルを構築、展開したい場合は、同社のユーザーフォームからサインアップして始めることができる。

MPTモデルは、GPTスタイルのデコーダーのみのトランスフォーマーであり、パフォーマンスに最適化されたレイヤーの実装、トレーニングの安定性を高めるアーキテクチャの変更、コンテキスト長制限の排除などの改良がなされている。こうした改良によってユーザーは効率的にMPTモデルを訓練することができる。

MPT-7B(基本モデル)

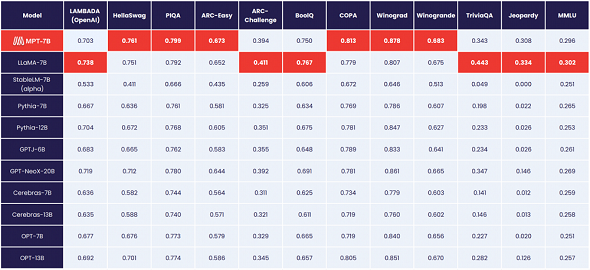

「MPT-7B」は、標準的なアカデミックタスクで優れたパフォーマンスを発揮する。モデルの品質を評価するために、インコンテキスト学習(ICL)で一般的に使用される11のオープンソースベンチマークを収集し、業界標準の方法で評価を行った。また、独自に選定したベンチマークを追加し、モデルが難しい質問に対して事実に基づいた正しい回答を生成する能力を評価した。

MPT-7BとLLaMA-7Bは、全てのタスクにおいてほぼ同等の品質を持ち、それぞれのモデルが12のタスクのうち6つで最高のスコア(赤で表示)を獲得している。

MPT-7B-StoryWriter-65k+

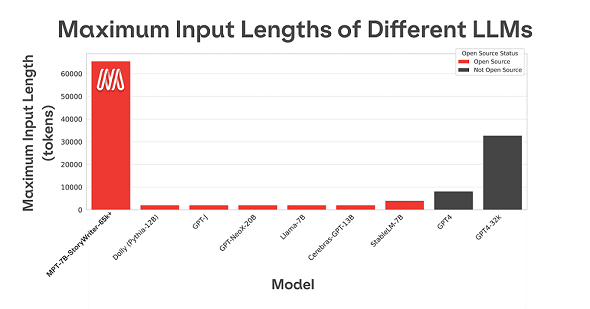

多くのオープンソースLLMは数千トークンまでのシーケンスしか処理できないが、MosaicMLプラットフォームと8台のA100-80GBを搭載した単一のノードを使用し、MPT-7Bをファインチューニングすることで、最大6万5000トークンの長いコンテキストを扱うことができるようになった。

他のオープンソースモデルで入力できる最も長いコンテキストは4000トークンにとどまる。GPT-4は8000トークンが可能で、GPT-4の別モデルは32000トークンが可能となっている。

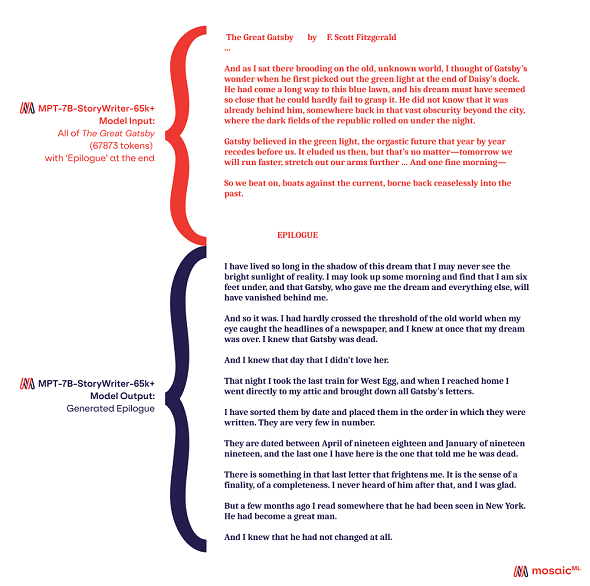

この機能を示すために、また実際に6万5000トークンが表示できるウィンドウで何ができるかを示すために、6万8000トークンからなる小説『グレート・ギャツビー』を読み込ませ、エピローグを生成させた。

エピローグは『グレート・ギャツビー』のテキスト全体(約6万8000トークン)をStoryWriterへの入力として提供した後に、「エピローグ」という単語を入力し、そこから生成を継続できるようになっている。

MPT-7B-Instruct

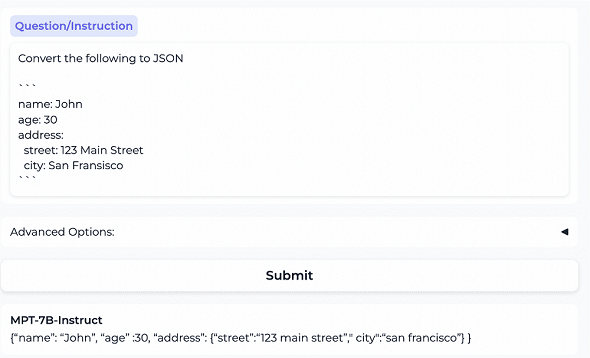

LLMのプレトレーニングは、入力に基づいてテキストを生成し続けるようモデルに学習させる。しかし、実際には、LLMが入力を指示として処理することが期待される。そのため、LLMが指示に従うようにトレーニングを行う。MPT-7B-Instructは1兆トークンにわたるトレーニングを行った。

この例ではYAML形式で書かれたコンテンツをJSON形式に変換するよう指示され、適切に変換している。

MPT-7B-Chat

MPT-7B-Chatは、ShareGPT-Vicuna、HC3、Alpaca、Helpful and Harmless、Evol-Instructを使用してファインチューニングされており、幅広い会話タスクやアプリケーションに適している。

上の例では、AI(人工知能)を活用して絶滅の危機にひんする野生動物を保護できないかという問いに対して、MPT-7B-Chatはニューラルネットワークライブラリ「Keras」を使用し、そのうちの1つをPythonで実装することを提案している。

使用したツールはMosaicMLの全ての顧客が利用できる。また、MPT-7B-InstructおよびMPT-7B-Chatはコードやデモなどがリリースされている。

関連記事

大規模言語モデル(LLM:Large Language Model)とは?

大規模言語モデル(LLM:Large Language Model)とは?

用語「大規模言語モデル」について説明。大量のテキストデータを使ってトレーニングされた自然言語処理のモデルのことを指す。 Google Cloud、生成系AI利用のセキュリティプラットフォーム「Security AI Workbench」を発表

Google Cloud、生成系AI利用のセキュリティプラットフォーム「Security AI Workbench」を発表

Googleは「Google Cloud Security AI Workbench」を発表した。セキュリティに特化した大規模言語モデル(LLM)である「Sec-PaLM」をベースにした業界初の拡張可能なセキュリティプラットフォームとうたっている。 Microsoft、大規模言語モデル(LLM)を用いたAIアプリ開発を支援するVS Code拡張機能を公開

Microsoft、大規模言語モデル(LLM)を用いたAIアプリ開発を支援するVS Code拡張機能を公開

Microsoftは、Visual Studio Codeの拡張機能「Semantic Kernel Tools」を公開した。大規模言語モデルを用いたAIアプリケーションをVisual Studio Codeで素早く簡単に開発できる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ