大規模言語モデル(LLM:Large Language Model)とは?:AI・機械学習の用語辞典

用語「大規模言語モデル」について説明。大量のテキストデータを使ってトレーニングされた自然言語処理のモデルのことを指す。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

用語解説

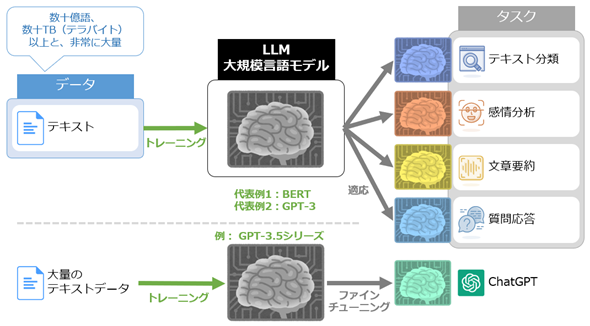

大規模言語モデル(LLM:Large Language Models)とは、大量のテキストデータを使ってトレーニングされた自然言語処理のモデルのことである。一般的には大規模言語モデルをファインチューニングなどすることによって、テキスト分類や感情分析、情報抽出、文章要約、テキスト生成、質問応答といった、さまざまな自然言語処理(NLP:Natural Language Processing)タスクに適応できる(図1)。

大規模言語モデルの代表例としては、2018年にGoogleが発表した「BERT」や、2020年にOpenAIが発表した「GPT-3」などが挙げられる。2022年12月に発表された「ChatGPT」は、2022年初頭にトレーニングした「GPT-3.5シリーズ」をチャット(対話)向けにファインチューニングしたものであり、大規模言語モデルの応用例の一つだ。

この他、Meta社が商用利用可能なライセンスで公開する「Llama」や、Googleが展開する「Gemini」、Anthropicが展開する「Claude」などが有名である。日本語に特化したLLMも多数発表されており、例えばLlama 2をベースとした商用利用可能な「ELYZA-japanese-Llama-2-13b」などがある。

大規模言語モデルの「大規模」に明確な基準はないが、BERTとGPT-3を参考値として示しておく。BERTは、28億語のWikipediaデータと8億語のGoogle BookCorpusデータで合計33億語のデータからトレーニングされている。GPT-3は、45TB(テラバイト)のデータ(最終的に合計4990億トークン)からトレーニングされている。GPT-3.5のデータセットについては筆者が調べた限り発表されていない。

大規模言語モデルは、その内部のニューラルネットワークに含まれるパラメーターの数も非常に多い。BERTは3億4000万、GPT-3は1750億、GPT-3.5は3550億ものパラメーターを持っている。GPT-4のパラメーター数は非公開だが、1兆個を超えるとうわさされている。

基本的に大規模言語モデルは、モデルのサイズ(=パラメーター数)や、トレーニングに使用されるデータ量や計算量を増やすことで性能が向上することが知られている(参考:言語モデルのスケーリング則)。この特性に従い、最近の大規模言語モデルはさらに巨大化している。BERT時代の約3億と最近の1兆超えのパラメーター数は大きくかけ離れているため、「LLM」と呼ぶ場合、一般的には最近の巨大な大規模言語モデルがイメージされることが多いだろう。

ちなみに、GPT-3やGPT-3.5は基盤モデル(Foundation Model)であり、かつ大規模言語モデルでもある。ただし、「テキスト以外のデータ」(例えば“画像”データ)を使ってトレーニングした基盤モデルは、当然ながら「大規模“言語”モデル」とは言えないことに注意してほしい。つまり、必ずしも「基盤モデル = 大規模言語モデル」ではない。

ここを更新しました(2024年6月3日)

LlamaやGemini、Claude、日本語LLMなどの最新情報を追記しました。言語モデルのスケーリング則の言及を追記しました。

Copyright© Digital Advantage Corp. All Rights Reserved.