「Apple Vision Pro」が採用した空間オーディオがもたらす没入感 Appleが凝らした工夫を考える:ものになるモノ、ならないモノ(94)

Appleから発表されたVR/AR(仮想/拡張現実)対応のゴーグル型ヘッドマウントディスプレイ「Apple Vision Pro」。その空間オーディオ体験にはどんな工夫が凝らされているのだろうか。音楽制作をなりわいとする筆者が「音」に焦点を当てて考察する。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

2023年6月5日(米国時間)、Appleは世界開発者会議「WWDC23」を開催し、VR/AR(仮想/拡張現実)対応のゴーグル型ヘッドマウントディスプレイ(HMD)「Apple Vision Pro」(以下、Vision Pro)を発表した。

ただ、Apple自身は、WWDC23の基調講演において、VR、AR、メタバースといった表現を避け、Vision Proがもたらす世界を「空間コンピューティング(Spatial Computing)」として定義していた。これまでのVR/AR対応のHMDとは一線を画する存在である点を強調しアピールする意図があったのだろう。

Vision Proのニュースに接していると、世間一般には、眼前に広がるプライベートな仮想4Kディスプレイや映画館のようなスクリーンなど、視覚領域における興味が先行している。確かにHMDにとって視覚に訴える世界はその製品の評価を左右する大切な要素なのは理解できる。ディスプレイの一種なのだから。

ただ、音楽制作をなりわいとしている筆者にとって気になるのは、空間オーディオと空間コンピューティングの関係だ。AppleもVision Proにおける空間オーディオがもたらす体験の重要性を強調している。

基調講演のプレゼンでは、空間コンピューティングの良質なユーザー体験をより強固なものにするために、耳に訴える聴取体験において、可能な限り最上級の品質で提供しようとする姿勢を垣間見た。

Appleによると、ユーザーが居る「空間に合わせてサウンドを調整する先進的な空間オーディオシステム」を実装しているという。ただ、こればかりはVision Proを実際に使用してみないと、どれほどの素晴らしい体験を提供してくれるのか分からない。だが、歴史的に見ても音にこだわるAppleだけに、期待が持てる。

装置に合わせてレンダリングしながら再生

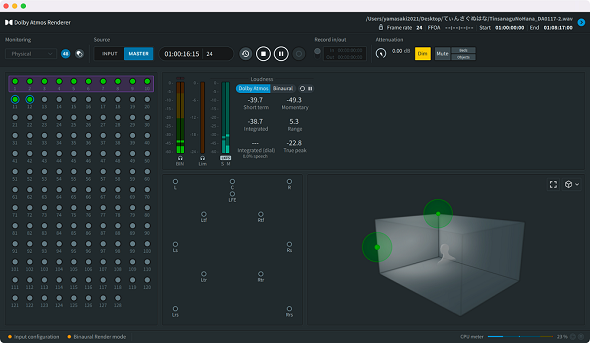

Appleが「空間オーディオ」と呼ぶその仕組みは、Dolby Laboratoriesが開発した「Dolby Atmos」という立体音響の技術をベースにしている。ここでDolby Atmosについて簡単に説明しよう。後に詳述するVision Proの「空間オーディオ」戦略に大きく関係するからだ。

Dolby Atmosの立体音響は、従来の5.1チャンネルに代表されるサラウンドとは技術的に異なるものだ。

従来の5.1チャンネル方式は、「正面」「前左右」「後左右」の5つのスピーカーに加え、1つの低音用のスピーカーでユーザーを取り囲む方式だ。そして、5.1チャンネル向けのコンテンツは、各スピーカーが再生する音声を5つのチャンネルに振り分けて収録している。

一方のDolby Atmosは「オブジェクトオーディオ」と呼ばれ、音声に立体的な位置座標の情報を付加し、ユーザー側のDolby Atmos対応の再生装置に合わせてレンダリングしながら再生する。

そのため、7.1.4チャンネル(正面、前左右、横左右、後左右、前方上左右、後方上左右、低音)といったマルチスピーカー環境から、バイノーラル(両耳の意、ヘッドフォン用の2チャンネル)まで、制作者は「ADM BWF」という1種類のDolby Atmosの音源ファイルを供給するだけで、音の定位や移動をさまざまなリスニング環境に合わせて、意図通り表現することができる。

Appleは、独自のレンダリングエンジンを採用

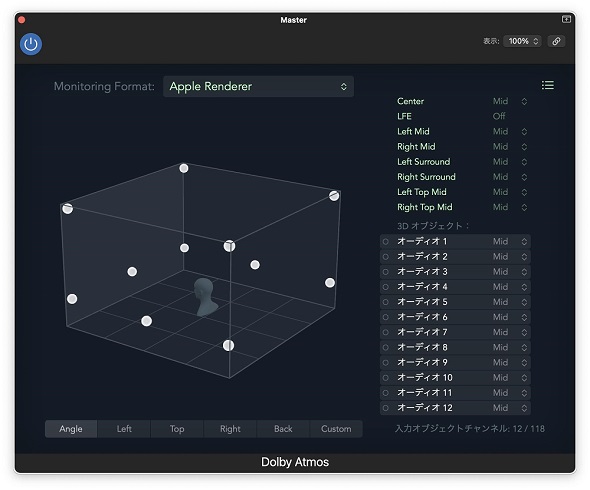

Appleの「空間オーディオ」もDolby Atmosを採用している。ただし、大きく異なる点がある。それは、レンダリングエンジンだ。

実は、AppleはiOS/iPad OS、macOSにおけるDolby Atmosのバイノーラル(ヘッドフォン)再生において、Dolby Laboratoriesのものとは異なる、独自のレンダリングエンジンを導入している。

この独自のレンダリングエンジンこそが、Vision Proが提供する空間オーディオに大きく関係している、というのが筆者の見立てだ。Appleが納得する品質の空間オーディオを実現するためには、Dolby Laboratories純正のレンダリングエンジンではなく、Apple独自のレンダリングエンジンが必要なのだ。

その理由は幾つかある。その一つにバイノーラル再生におけるパーソナライゼーションがある。

Appleは、2022年秋に登場したiOS 16において空間オーディオにおけるパーソナライゼーション機能を実装した。これによりバイノーラル再生の聴取体験がよりリアルなものになるとアナウンスしている。

この機能、頭や耳の写真を撮影することで、ユーザー各個の「頭部伝達関数(Head-Related Transfer Function)」を予測し、ユーザー個々に最適化された空間オーディオのパーソナルプロファイルを作成しようというものだ。

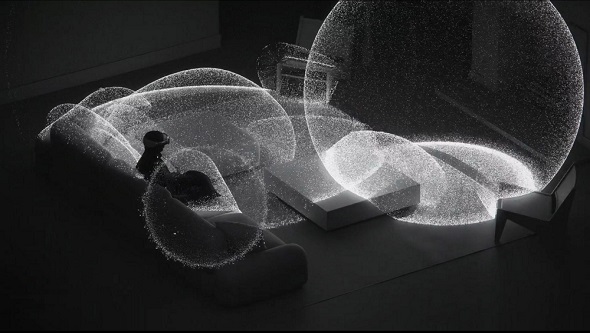

人間が両耳で周囲360度の音源の方向を聞き分けることができるのは、周囲の反射などの音響的特徴を経験則などを交えて脳が処理することで、音源の位置を特定しているからだ

頭部伝達関数は、音波が頭部、身体、耳殻、周囲の環境などでの反射や回折を経て聴取者の外耳道の入口に到達するまでの伝達特性をパラメーター化し、出音に変調を加えることで、バイノーラル再生時の立体音響を実現している。

Appleはたくさんの被験者の頭部伝達関数をサンプリングし、その中から近似値を選び出すことで、パーソナルプロファイルを作成しているものと思われる。

Vision Proも左右ストラップに設置された2つのスピーカーから音を出す。バイノーラル再生におけるパーソナルプロファイルを作成する必要がある。Vision Proの利用時にiPhoneを使って空間オーディオのパーソナルプロファイルを作成する必要があるので、同じ仕組みが取り入れられているのだろう。

Dolby Laboratoriesも、「Dolby Personalized HRTF」というパーソナルプロファイルを作成するための仕組みはあるのだが、Appleとしてはバイノーラル再生の聴取体験をより強固なものにするためには、出音に深く関係するレンダリングエンジンを100%自社のコントロール下に置く方が得策と判断したのではないか。

それを裏付ける機能がVision Proに盛り込まれている。Vision Proは、内蔵カメラなどで部屋の様子をスキャンし音の反射などを考慮した上で、より高度な空間オーディオを実現するという。

人間が音の方向を知覚する際、耳や頭部の形に加え、壁などからの反射音など、周囲の環境も大きく影響する。ユーザーが居る環境を考慮したより高度な空間オーディオを実現するためには、第三者が関与しない独自のレンダリングエンジンが必要との判断ではないのか。

空間コンピューティングに不可欠なヘッドトラッキング

独自のレンダリングエンジンを必要としたもう1つの理由は、「ヘッドトラッキング」にある。AirPods ProやAirPods MAXなどApple製のイヤフォンやヘッドフォンを使っているユーザーであれば「ヘッドトラッキング」という設定がオン/オフ可能なのをご存じだろう。

ヘッドトラッキングは、頭の向きに応じて音像や定位が移動する機能だ。例えば、それまで正面から聞こえていたボーカルが、頭を動かすと顔を向けた方向とは反対側の耳に移動する。これがヘッドトラッキングだ。

ただ、空間オーディオの音楽を楽しむ場合、ヘッドトラッキングは無用の長物といえる。顔を左右に動かすたびに、楽器の定位や音像が変化したのでは、聴いていて気持ち悪くなる。

ちなみに、Apple端末のヘッドトラッキングは、最初は音像や定位が移動するが、顔を向けたままにしておくと10秒ほどで自動的に顔の向きに合わせて正面に移動する。

音楽や映像コンテンツではあまり意味を成さなかったヘッドトラッキングだが、Vision Proになると途端にその威力を発揮する。いや、発揮するどころか、ヘッドトラッキングがないと空間コンピューティングのユーザー体験を台無しにしてしまうのではないだろうか。

基調講演のプレゼンの中に複数人とFaceTimeを行う場面があった。ここでヘッドトラッキングが活躍する。例えば右側の空間に浮かんだスクリーン内の相手から呼ばれたら、右耳の方から声が聞こえるので、当然そちらに顔を向ける。

その際、ヘッドトラッキング機能がなければ、話相手と正対したにもかかわらず、音声は右耳から聞こえてくることになる。これでは具合が悪い。ヘッドトラッキングがあれば、頭の向きとともに定位も移動して、相手の声が正面から聞こえてくる。

Dolby Atmosにも「Dolby Head Tracking」という機能があり、それに対応したヘッドフォンであれば、同様の機能を利用することができる。ただ、このヘッドトラッキングも前述のパーソナライズ化と同様にApple自身のコントロール下に置いておきたかったが故の独自レンダリングエンジンなのだろう。

ただ、このApple独自のレンダリングエンジンは、音楽制作者の間に少なからず混乱をもたらしている。というのは、Dolby Atmos対応のコンテンツをDolby Atmos Rendererで制作し、各プラットフォームに向けて配信したとしよう。そのコンテンツをApple製イヤフォンでバイノーラル再生した場合、Apple Musicだけ音像や定位が異なって聞こえるのだ。

同じくDolby Atmosに対応しているAmazon Music UnlimitedやTIDALでの再生は、制作者の意図通りの立体音響が再生される。Apple Musicだけ、音像や定位が異なっているのは、独自のレンダリングエンジンの影響があるといわれている。

少しオーバーな言い方をすると、AppleはDolby Atmosの音楽制作者を敵に回したとしても、空間コンピューティングにおけるサウンド面のユーザー体験を最高のものにしたかったと考えることができる。

「空間コンピューティングと空間オーディオ」この2つの空間技術を実装したVision Proの発売が待ち遠しい。

著者紹介

山崎潤一郎

音楽制作業を営む傍らIT分野のライターとしても活動。クラシック音楽やワールドミュージックといったジャンルを中心に、多数のアルバム制作に携わり、自身がプロデュースしたアルバムが音楽配信ランキングの上位に入ることもめずらしくない。ITライターとしては、講談社、KADOKAWA、ソフトバンククリエイティブといった大手出版社から多数の著書を上梓している。また、鍵盤楽器アプリ「Super Manetron」「Pocket Organ C3B3」などの開発者であると同時に演奏者でもあり、楽器アプリ奏者としてテレビ出演の経験もある。音楽趣味はプログレ。

関連記事

「Apple Vision Pro」でどんなアプリを使えるのか? どんな開発ツールを使えるのか?

「Apple Vision Pro」でどんなアプリを使えるのか? どんな開発ツールを使えるのか?

「Apple Vision Pro」のアプリを作れる開発者ツールが利用可能になった。Appleのプラットフォームを利用する開発者は、「visionOS」のソフトウェア開発キット(SDK)によってどのようなアプリを開発できるのかの例と、Vision Pro用のアプリの設計、開発、テストに役立つ情報を紹介する。 不動の1位「Python」を脅かすのは「C」か「C++」か、それとも「Java」? 2023年6月言語人気ランキング発表

不動の1位「Python」を脅かすのは「C」か「C++」か、それとも「Java」? 2023年6月言語人気ランキング発表

プログラミング言語の人気ランキング「TIOBEインデックス」の2023年6月版が公開された。1位は変わらず「Python」。だが、2023年に入ってシェアが下がっており、2位以下からは「背中が見えている」状態だ。 Baiduの人工音声合成「Deep Voice 3」は、大幅に進化している

Baiduの人工音声合成「Deep Voice 3」は、大幅に進化している

中国の検索大手Baidu(百度)は最近、人工音声合成フレームワーク「Deep Voice 3」をリリースし、アルゴリズムとハードウェア効率の両面で目覚ましい前進を遂げた。2400人以上の話者の声を、短時間の訓練で合成できるようになった。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ