企業は生成AIのセキュリティリスクとどう付き合うべきか、うっかり情報漏えいやプロンプトインジェクションへの対応方法とは:NRIセキュアが解説(2/2 ページ)

例えば「ElevenLabs」というサービスでは、1分間など短い音声ファイルをアップロードすることで簡単にクローンの音声を作ることができる。これはクローン音声を使ったサイバー攻撃実行の敷居が大きく下がっていることを意味する。

実際に、ある記者がこれを使って自身のクローン音声を作成し、英国金融機関のカスタマーサポートにおける音声認証を突破するという実験を行い、成功したという。

音声認証に限らず、顔や指紋での認証も、同様に突破されるリスクが高まっている。

「攻撃の元となる生体データを準備するのは難しいが、今後は生成AIで大量に作るような仕組みが出てくることも考えられる。今は喫緊の脅威ではないとしても、あと数カ月あるいは1年以内には脅威になり得る」

地下市場では個人情報が流通しているが、これに生体認証データがひも付けられ、攻撃に使われてしまう危険性もあると、山口氏は指摘した。

従業員によるうっかり情報漏えい

「『うちの社員が 社内の情報を生成AIに入力してしまったが大丈夫か』といった問い合わせを受けたこともある」

海外では社内の機微情報をインプットして経営会議の資料を作成したり、患者の個人情報を使って保険の申請書を作ったりといった例も報告されている。

一方で、プログラムの作成やデバッグにコード生成AIサービスを使うことは当たり前になりつつある。マルウェアや脆弱(ぜいじゃく)性を含むコードを取り込む可能性が現実味を増している。

こうしたことから、ChatGPTなどの利用を禁止する企業が見られる。ただし、金融機関では禁止例が多いものの、電気機器メーカーでは対応が二分化していると山口氏は指摘。「Azure OpenAI Service」のコンテンツフィルタ機能を利用しているパナソニックコネクトの例を挙げた。

現状では対応が分かれているが、今後は幅広い業界で、制限しながらも利用を徐々に進めていくことになるだろうという。

では、企業は生成AIサービスへの情報漏えいとどのように付き合っていくべきか。

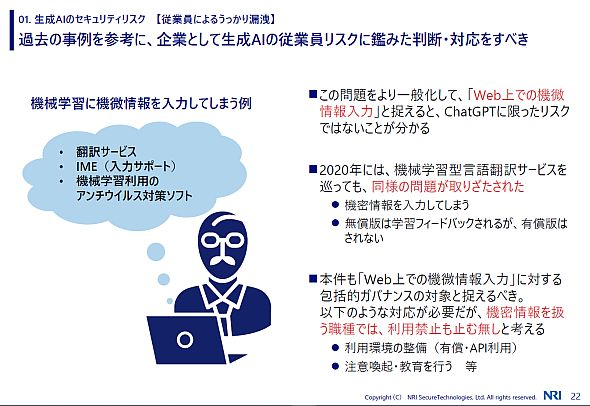

山口氏はChatGPTのような生成AIが特別とはいえないと話す。過去には機械学習型の翻訳サービスで、同様の問題が指摘されることがあった。同様にIMEやウイルス対策ソフトでも、データが外部に持ち出される危険性がある。

この点を考え、「Web上での機微情報入力」として対応すべきだという。

具体的には、生成AIサービスを注意深く選択し、有償版やAPIなどの利用環境を整備する。一方URLフィルターなどで、アクセスできるサービスを制限する。また、社内では「入力してはいけない情報」について注意喚起やトレーニングを行い、リテラシーの向上を図っていくことが大事だとしている。

Copyright © ITmedia, Inc. All Rights Reserved.