「ChatGPTの利用禁止」だけでは組織を守れない AIとどう向き合い、管理すべきか:「シャドーAI」がもたらすビジネスリスクとは

生成AIにおいても「シャドーIT」と同様、見えないところで使われるというセキュリティリスクの問題が顕在化しています。なぜ従業員は非公認ツールを使ってしまうのか? その根本原因と、IT担当者、組織の向き合い方とは。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

「ChatGPT」をはじめとする生成AI(人工知能)は、質問への回答だけでなく、文章作成や要約、コード生成など、さまざまな業務を支援するツールとして急速に普及しています。

生成AIの選択肢もGoogleの「Gemini」やAnthropicの「Claude」といった高性能なクラウド型モデルに加え、Hugging Faceなどプラットフォームで公開されているオープンウェイトのモデルまで拡大しています。

さらに生成AIは独立したツールとしてでなく、私たちが普段利用しているWebブラウザやSaaS(Software as a Service)、業務ワークフローの中に機能として組み込まれ始めています。

加えて、人の指示を待たずに自律的にタスクを完遂する「AIエージェント」の実用化も始まっており、誰が、どのAIを、どのような権限で使っているのか、IT部門が利用実態を把握するのは困難です。

このように、AIが業務の裏側で動く見えないツールとなればなるほど、従業員のリスク意識は希薄になりがちです。結果として、どのような情報を入力し、何を学習させてよいのかを十分に意識しないまま利用してしまい、それが大きなセキュリティリスクとなり得るのです。

生成AIに共有してはいけない情報とは

セキュリティベンダーのESETは、ChatGPTの利用に関するガイドを公開し、情報漏えいを防ぐために「絶対に入力してはいけない情報」として次の5項目を挙げています。

- 個人識別情報

- 住所やマイナンバーなど

- 財務情報

- パスワードやAPIキー

- 企業の機密情報

- ソースコードや内部文書

- 健康情報

こうした情報を生成AIに入力すると、サービスの運用方針やセキュリティ設定によっては外部に漏えいしたり、不正利用されたりする可能性があります。業務で得た内部事情を入力した場合、結果的に企業の重要情報を第三者に渡してしまう恐れもあります。

やみくもな禁止が引き起こす「シャドーAI」問題

こうしたリスクが明らかになると、「危険なら生成AIの利用を禁止すればよい」と考える組織も少なくありません。しかし、生産性向上や業務効率化を求める従業員にとって、こうした単純な禁止方針は、受け入れがたいものとなっています。

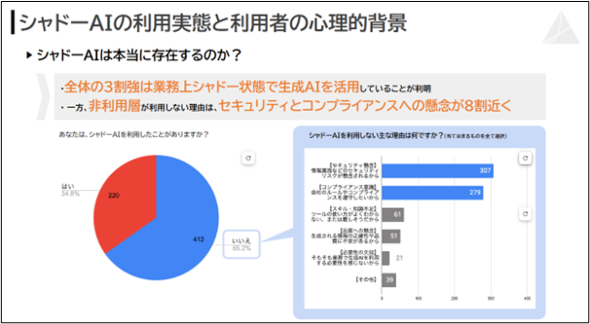

それが新たな問題として浮上している「シャドーAI」です。SIGNATE総研の調査(「AI活用実態調査レポート 2025年12月版 〜特集:シャドーAI〜」)によると、回答者の34.8%が組織の管理外のAIを利用していることが明らかになりました。

問題は、シャドーAIのリスクが、「シャドーIT」問題とは質が異なる点です。従来のシャドーITはデータの置き場所という問題が中心でしたが、生成AIへの入力はデータがモデルに学習されるリスクを伴います。一度学習されれば、企業のコントロールが及ばない形で第三者に情報が出力される可能性があり、ファイルの削除やアクセス権の変更といった手法では解決不可能となる恐れがあります。

シャドーAIを利用する従業員の「不満」とは

シャドーAIの拡大を受け、「ルールを守らない従業員のモラル低下」が問題視されることもあります。しかし、実態を見ていくと、必ずしも規則軽視や不正意識が原因とは言い切れません。

先述した調査によれば、シャドーAIを引き起こす理由として、「標準AIの機能不足」や「利用申請フローの煩雑さ」といった利便性の低さを指摘する声が多く挙げられています。

「会社のPCが遅いから私用PCを使う」と考える従業員がいるように、これからは「会社で用意されているAI環境が不便だから個人で契約した生成AIを使う」と考える従業員が現れるというわけです。

解決の鍵はAIガバナンス IT部門任せでは限界

シャドーAIの背景に現場の不満や業務ニーズがある以上、単なる利用禁止や個別対策では根本的な解決にはなりません。そこで重要となるのが、企業全体として生成AIの活用とリスク管理を両立させる「AIガバナンス」の取り組みです。

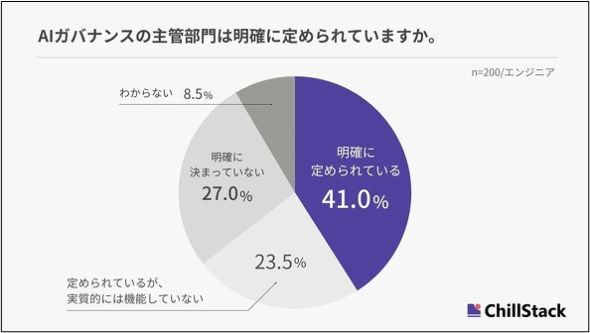

ChillStackの「AIガバナンスに関する実態調査」によると、AIガバナンスの主管部門が明確に定められているかどうかを尋ねたところ、合わせて50.5%の企業でAIガバナンス体制が未整備または形骸化している実態が明らかになっています。ルール策定はIT部門、運用は各事業部、責任は経営層と分散され、問題が起きた際には責任の所在が曖昧になるという責任の押し付け合いが起きやすい問題も指摘されています。

生成AIは単なるITツールではなく、業務プロセスや意思決定にも影響を及ぼします。セキュリティ対策だけでなく、コンプライアンス(法令順守)、情報管理、業務効率化といった複数の観点を横断的に考える必要があります。IT部門だけに対応を任せるのではなく、経営層が関与しながら組織全体で方針を定め、現場を支える体制作りが不可欠です。

「管理された利用」こそが最大のリスク対策になる

技術の進化が速い生成AIに対し、自社で一からAIガバナンスに取り組むのは負担が大きいだけでなく、新たなリスクの見落としにもつながりかねません。では、何から、どのように手を付ければよいのでしょうか。

生成AIリスクは、多くの組織がまさに今直面している問題であり、行政機関やAI専門機関から、実務に即したガイドラインやフレームワークが続々と公開されています。こうした外部の知見を積極的に取り入れ、自社の状況に合わせてカスタマイズするのが、AIガバナンスに取り組む上でのポイントといえるでしょう。

例えば、総務省が最近公表した「自治体におけるAI活用・導入ガイドブック(第4版)」は、自治体向けではあるものの、生成AI利用ルールのテンプレート(ひな型)やリスク対策が整理されており、企業にとっても利用ルールを検討する上での参考となるはずです(関連記事)。

またIPA(独立行政法人情報処理推進機構)が設立したAIセーフティ・インスティテュート(AISI)はAIの安全性評価に関する指針を発信している他、CAIO(最高AI責任者)の設置を推奨する「CAIO設置・AIガバナンス実務マニュアル」を公開しています。こちらも組織体制面を含め、生成AIのリスクと向き合う上で、参考となるはずです。

前述の通り、多くの企業で生成AIの責任の所在が曖昧になっている今、生成AIの利用を禁止するだけでは、水面下でシャドーAIが拡大し、予期せぬインシデントに見舞われかねません。利用禁止は一見、最も安全な策に見えますが、実態としては生成AI活用で得られる価値を捨てて、管理不能な「見えないリスク」を抱え込むという選択をしているに他なりません。

Gartnerも、AIのリスク管理を行わない企業は、将来的に事業価値の破壊的な損失を被る可能性があると警告しています(関連記事)。生成AI活用が加速する今だからこそ、経営層を巻き込み、どう安全に使い倒すかという議論を始めることが重要です。

関連記事

ChatGPTに「入力してはいけない情報」5選――NGリストとその理由

ChatGPTに「入力してはいけない情報」5選――NGリストとその理由

ESETは、ChatGPTの利用に伴うセキュリティとプライバシーのリスクをまとめた包括的なガイドを公開した。7つの大きなリスクや共有禁止情報の「レッドリスト」、10の保護習慣を解説している。 シャドーAIを引き起こす「従業員の不満」とは 生成AI利用企業の34.8%が経験

シャドーAIを引き起こす「従業員の不満」とは 生成AI利用企業の34.8%が経験

SIGNATE総研は、生成AIの利用実態に関する調査レポートを公開した。企業の許可を得ずAIを利用する「シャドーAI」の浸透と、組織内のリスク認識の差が浮き彫りとなった。 AIガバナンスの主管部門が不在・機能不全の企業が半数超 「責任の押し付け合い」に懸念

AIガバナンスの主管部門が不在・機能不全の企業が半数超 「責任の押し付け合い」に懸念

ChillStackは、エンジニアや情報システム・監査部署の担当者を対象にAIガバナンスの実態調査を実施した。自社サービスへのAI実装が本格化する一方、約半数の組織でAIガバナンス体制が未整備または形骸化している状況が明らかとなった。 AIガバナンス不足で2028年までに企業の25%が事業損失 効果的な対策は

AIガバナンス不足で2028年までに企業の25%が事業損失 効果的な対策は

会話型AIの導入が広がる一方、その自由で自然なやりとりが企業に新たなリスクをもたらし始めている。エラーやバイアス、セキュリティなど、従来の手法ではカバーし切れない課題が次々と顕在化している。本稿では、ガバナンスの重要性と安全で信頼できるAI活用について解説する。

Copyright © ITmedia, Inc. All Rights Reserved.