Google、「AI Platform」で機械学習の開発と運用を支援:各種のマシンタイプを選択可能

Googleは、機械学習(ML)ワークロードをより高速かつ柔軟に実行できるように「AI Platform」の各種機能を強化した「AI Platform Prediction」の提供を開始した。さまざまなマシンタイプを選択できる。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

Googleは2019年10月26日(米国時間)、機械学習(ML)ワークロードをより高速で柔軟に実行できるように「AI Platform」の各種機能を強化した「AI Platform Prediction」の提供を開始した。

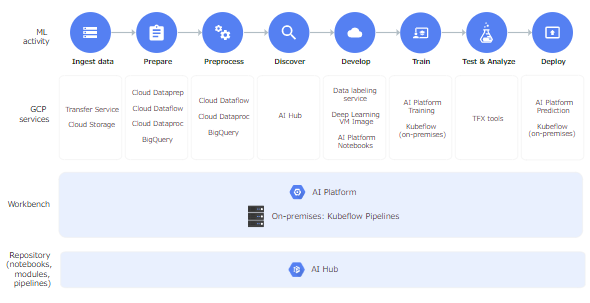

AI Platformは、Google Cloud Platform(GCP)で提供されるクラウドサービスの一つ。AI Platformを使えば、大規模な機械学習の開発と運用が容易になる。GCPのリソースを使用して大規模な機械学習モデルをトレーニング後、モデルをホストして、それらのモデルに予測リクエストを送信したり、GCPサービスを使用してモデルとジョブを管理したりできる。

AI Platform Predictionを利用すると、データサイエンティストはサーバレス環境でオンライン予測のモデルを提供できる。アプリケーション開発者は、MLフレームワークを理解していなくてもAIにアクセスでき、データサイエンティストは、インフラを管理しないで済む。

だが、一部の複雑なMLモデルでは、許容可能なレイテンシで実行するために条件があった。具体的には多数のCPUを搭載するマシンか、NVIDIA GPUのようなアクセラレーターを搭載するマシンを使用しなければならない。これは、画像や動画、テキストなど、非構造化データを処理するモデルに特に当てはまる条件だ。

「AI Platform Prediction」が目玉

今回の機能強化により、AI Platformの予測サービスコンポーネント「AI Platform Prediction」では、GCPのIaaS(Infrastructure as a Service)サービス「Google Compute Engine」でさまざまなマシンタイプを選択できるようになった。

例えば推論に最適化された低レイテンシの「NVIDIA T4」のようなGPUを追加することが可能だ。従来のメリットは変わらず享受でき、インフラを管理する必要はない。AI Platformがモデルのプロビジョニングやスケーリング、提供を管理する。なお、これまでのAI Platform Predictionでは1つか、4つのvCPUマシンタイプの提供にとどまっていた。

モニタリングとデバッグはどうなる

また、AI Platform Predictionの新しいマシンタイプでは、モニタリングとデバッグも容易に実行できる。実運用でのリクエストと応答は、GCPのサーバレスクラウドデータウェアハウス「BigQuery」にログを保存できる。BigQueryでは、ログを分析してゆがみや外れ値を検出したり、モデルを再トレーニングすべきかを判断したりできる。

この機能では、コンテナアプリケーションをデプロイできるGCPのマネージド型環境である「Google Kubernetes Engine(GKE)」上に構築された新しいバックエンドを使用している。信頼性の高い高速なサービス提供システムを構築でき、機械学習が要求する柔軟性も提供できる。

新しいマシンタイプを利用するには

新しいマシンタイプを利用するのは簡単だ。ユーザーインタフェース(UI)かAPI、コマンドラインツール「gcloud」のいずれかを使って、モデル作成リクエストの「machineType」フィールドをCompute Engineのマシンタイプに設定すればよい。

NVIDIA T4搭載マシンをデプロイするためのgcloudコマンドは次のようになる。

gcloud beta ai-platform versions create $VERSION_NAME \ --model=$MODEL_NAME \ --origin=$DEPLOYMENT_URI \ --runtime-version=$RUNTIME_VERSION \ --machine-type=n1-standard-8 \ --accelerator=count=1,type=NVIDIA_TESLA_T4

AI Platformのトレーニングサービスコンポーネント「AI Platform Training」でも、トレーニングできるモデルの種類を増やす次の機能が利用できるようになった。

- カスタムコンテナ(一般提供開始) GCPサービスで任意のDockerコンテナを起動し、任意の言語やフレームワーク、依存関係を選んでモデルをトレーニングできる。この機能は、「AI Platform Deep Learning Containers」で作成したコンテナで特に便利だ

- Compute Engineのトレーニング用マシンタイプ(一般提供開始) CPUやRAM、アクセラレーターを自由に組み合わせたマシンでトレーニングを実行できる

関連記事

グーグルのAI技術、2019年夏の最新情報 ― Google Cloud Next ’19 in Tokyo 基調講演2レポート

グーグルのAI技術、2019年夏の最新情報 ― Google Cloud Next ’19 in Tokyo 基調講演2レポート

2019年現在、グーグルはAI分野でどんな技術やサービスを提供しているのか? Google Cloud Next ’19 in Tokyoの基調講演から、AIに関する部分を書き起こした。 「AutoML」の強化から「AI Platform」まで、Google Cloudが機械学習/AIで多数の発表

「AutoML」の強化から「AI Platform」まで、Google Cloudが機械学習/AIで多数の発表

Google Cloudは2019年4月10日(米国時間)、Google Cloud Next ‘19で、機械学習/AIに関する多数の発表を行った。これらは、「ビジネスユーザーのAI活用支援」と「貴重な社内データサイエンティスト/データエンジニアの生産性向上支援」の2つに分けられるという。 Google Cloud、GKEで複数のリリースチャンネルを選択可能に

Google Cloud、GKEで複数のリリースチャンネルを選択可能に

Google Cloudは2019年5月21日(欧州時間)、スペイン・バルセロナで開催中の「KubeCon+CloudNativeCon Europe 2019」で、「Google Kubernetes Engine(GKE)」に関し、アップデートのスピードに関する選択肢の提供など、複数の発表を行った。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ