テクノロジーは、障がい者の“遠慮”を取り除けますか?:教えて! キラキラ先輩(2/3 ページ)

AIならサポート役への気兼ねも解消

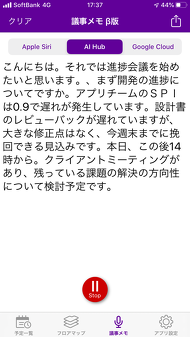

こうして生まれたのがTransCommunicatorだ。マイクの位置などを調整すれば、早めに話しても認識でき、フェースツーフェースの会議だけでなく、オンラインのWeb会議にも対応する。PCやスマートフォンアプリの形で提供するため、インストールのハードルが低い上、共通辞書と各ユーザー専用の辞書の2種類をメンテナンスできるので、さまざまな専門用語に対応している。

この結果、例えばアクセンチュアの社内ミーティングで交わされる、

「今週のプロジェクトの進捗(しんちょく)状況を教えてください」

「SPIは0.9で、ちょっと遅れが生じています。けれどもリカバリーできる見込みです」

といった開発プロジェクト特有の会話も、つっかえることなくリアルタイムに画面に表示できる。

室山氏は所属チーム内の定例ミーティングやコミュニティーミーティングで活用している他、「最近、避難訓練があったのですが、モバイルアプリを用いて放送内容を把握できて感動しました」とうれしそうに話す。

今までは、いくらタイピングのサポートがあるといっても、ちょっとした会話で他人の手を煩わせるとなると遠慮してしまいがちだった。スピード感に欠けることも相まって、「聴覚障がい者は情報障がい者」となりがちだったが、AIを活用することで、コミュニケーションの密度が高まった上に、余計な心理的負荷が減った。

同じく聴覚障がいがありながら、コーポレート・シチズンシップ推進事務局で20以上のプログラム運営管理に当たっている菊池美穂氏は、「介護の分野でも、ロボットならば気兼ねなくサポートをお願いできるそうです。同じように、AIがコミュニケーションをサポートしてくれることで、気を使わなくて済むという心情もあります」という。PCでのトレーニングや海外の事例動画を確認する際にもTransCommunicatorを活用しているそうだ。

こんな経験を踏まえて室山氏は「現代はテクノロジーで障がいを補う時代」という。

デザインシンキングで形にしていったTransCommunicator

TransCommunicatorの開発は、アクセンチュア社内のPwDのメンバーと一緒に、デザインシンキングベースで進めていった。プロトタイプを作成して実際に使ってもらい、多様なフィードバックをもらいながら開発を進めたという。

「例えば、アクションボタンを用意したのはいいのですが、『押したときに合成音声が出るだけだと、当の本人には聞こえないので、本当にボタンが機能しているのか分からない』というフィードバックを受けて、ボタンを押したことがツール上で見えるようにしました。このように自分たちだけでは気付けなかった有用なアドバイスを得られました」(堺氏)

現在も、PwDからのフィードバックを踏まえての機能強化は続いている。初期のアクションボタンは、あらかじめプリセットした内容しか発話できなかったが、バージョンアップ後は入力した内容をリアルタイムに発話できるようになった。

今後は、認識精度や処理のリアルタイム性をさらに追求する他、複数人が不規則に発言する会議の場で、誰が何を発言したかが分かる「話者識別」にも取り組んでいく。またこのツールをベースに、英語をはじめとするさまざまな言語への翻訳機能を組み合わせたり、内容を要約して議事録にしたりと、聴覚障がい者のサポートにとどまらず、幅広い用途を考えていきたいという。

「アクセンチュアではさまざまな国の出身者が働いており、日本人が英語の議論への参加を躊躇(ちゅうちょ)したり、逆に海外出身者が日本語の議論から置いていかれたりといった、言語の壁による問題はどうしても生じます。その壁を超えて、のびのびと海外の方と一緒に仕事ができる仕組みを目指しています」(堺氏)

また室山氏や菊池氏からは「感情が読み取れ、表示できたらいいのにな」「頭の中で考えていることを脳波で文字化したり、手話を読み取ったりしてもらえるとうれしい」といった要望も寄せられている。

これも決して夢物語ではなく、クラシック音楽を聴いたとき、演奏しているときの脳波を読み取って分析し、演奏家と聴衆とのコミュニケーションを可視化するといったユニークな実験が既に行われており、遠からず実現する可能性がある。

関連記事

教えて! キラキラお兄さん「プログラミングは視覚障害者にオススメの職業って本当ですか?」

教えて! キラキラお兄さん「プログラミングは視覚障害者にオススメの職業って本当ですか?」

視覚障害者こそ、PCを使いこなしていろいろな仕事についてもらいたい――全盲のセキュリティエンジニアは、画面読み上げソフト(スクリーンリーダー)を駆使して、人の役にたつモノ作りを続けている Pepper用の“接客業対応”音声認識機能を開発、横浜のホテルが利用開始

Pepper用の“接客業対応”音声認識機能を開発、横浜のホテルが利用開始

M-SOLUTIONSがソフトバンクロボティクスの人型ロボット「Pepper」用に、ホテル向け音声認識機能を開発した。コンシェルジュのような役割を「きちんと」担えるようにする 最適な種まきタイミングを予測――AI活用が進む5分野、その活用方法とは

最適な種まきタイミングを予測――AI活用が進む5分野、その活用方法とは

Microsoft AsiaのRalph Haupter氏は、アジアで人工知能の導入が功を奏している5つの分野を挙げ、その成果を語った。具体的には、「アクセシビリティー」「農業」「気候変動」「教育」「ヘルスケア」の5分野である 損保ジャパン日本興亜、音声認識AIによるコールセンター支援システムを本格導入 NTT Comと新機能の共同実証も

損保ジャパン日本興亜、音声認識AIによるコールセンター支援システムを本格導入 NTT Comと新機能の共同実証も

損保ジャパン日本興亜が、NTTの音声認識エンジンとAIエンジンを活用した「アドバイザー自動知識支援システム」を全国のコールセンターに本格導入。問い合わせに最適な回答を表示してオペレーターを支援する。併せて、用件の抽出や学習を自動化する新機能の実証実験を行う MicrosoftのAIをカスタマイズしてハンバーガーとチーズバーガーを区別させよう

MicrosoftのAIをカスタマイズしてハンバーガーとチーズバーガーを区別させよう

Custom Vision Serviceを使うと、独自の画像認識機能をプログラマーが簡単に作成し、AIにハンバーガーの見分けが付くかを試してみよう

Copyright © ITmedia, Inc. All Rights Reserved.