「ChatGPTプラグイン」の脆弱性についてセキュリティ研究者が開発者に警告:ChatGPTプラグインではなく、GPTsの利用を推奨

TechTargetは、「ChatGPTプラグインの脆弱性」に関する記事を公開した。ChatGPTプラグインの脆弱性が発見され、OpenAIと2つのサードパーティーベンダーは修正対応した。だが、セキュリティベンダーの研究者は「ChatGPTプラグインには依然としてセキュリティリスクが存在する」と警告している。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

TechTargetは2024年3月13日(米国時間)、「ChatGPTプラグインの脆弱(ぜいじゃく)性」に関する記事を公開した。

APIセキュリティベンダーSalt Securityの研究者は「ChatGPT」のプラグインの脆弱性について、OpenAIにその詳細をドキュメントとして明確にするよう提言し、開発者にはChatGPTを扱う際の潜在的なセキュリティ脆弱性への認識を深めるように呼び掛けている。

ChatGPTプラグインの脆弱性

ChatGPTプラグインは、ChatGPTの大規模言語モデル(LLM)をサードパーティーアプリケーションに接続するための実験的な手段として2023年3月に提供された。開発者は、プラグインを使って外部APIとやりとりでき、株価やスポーツのスコアといったデータリソースにアクセスしたり、他のサービスに接続してフライトの予約や食べ物の注文などのアクションを実行したりできる。2023年11月に登場したカスタムGPT「GPTs」にその役割を譲ったものの、Salt Securityの一部門であるSalt Labsのセキュリティ研究者は「GPTsが登場した後も、ChatGPTプラグインの一部は依然として使用されている」と指摘している。

GPTsが導入される前の2023年6月、Salt Labsの研究者は、ChatGPTプラグインのOAuth認証の実装について問題点(脆弱性)を見つけた。その脆弱性を悪用すると、機密データへのアクセスを攻撃者に許可する(攻撃者がユーザーのアカウントに悪意のあるプラグインをインストールし、機密データにアクセスすることを許可する)可能性があった。また、研究者らは、攻撃者がサードパーティーのChatGPTプラグインを通じて「OAuthのリダイレクト操作」で資格情報を盗み、「GitHub」などChatGPTに接続されたユーザーアカウントにアクセスする可能性があることも発見した。Salt Labsから通知を受け、サードパーティーのプラグインベンダーであるPluginLab.aiとKesem AIは、この脆弱性を修正。研究者らは「これらの脆弱性が悪用された証拠は見つからなかった」と述べている。

Salt Labsのヤニヴ・バルマス氏(主任研究員)は、TechTargetのインタビューで、生成AIのセキュリティ確保の難しさについて「セキュリティ研究者として、生成AIがどのように進展していくか、その全てを追跡するのは非常に困難だ。それは攻撃者も同様だろう」とコメントしている。

研究者らは「GPTsの利用を勧める方が、ユーザーにサードパーティーアプリケーションに接続することの潜在的なリスクを警告するには効果的だ」と考えている。また、OpenAIもGPTsの利用を推進し、ChatGPTプラグインを非推奨にする準備を進めているという。ただ、OpenAIのドキュメントの中には「GPTsのアクションはプラグインに基づいて構築されている」といった記述もある。Salt Securityはそのプラグイン内のフレームワークにある脆弱性も発見している。

バルマス氏によると、Salt Labsのセキュリティ研究者はOpenAIが問題を修正できるように、通常の開示プロセスに従ってこれらの脆弱性を開示する予定だ。そのため「詳細は明らかにできない」としている。

「『GPTsはChatGPTプラグインよりは安全だが、決して完全なものではない』ということ以外、今は何も言えない」(バルマス氏)

業界アナリストは、Salt Labsが見つけた脆弱性について「構成が不十分なChatGPTプラグインが、機密性の高いアプリケーション(特にGitHubのコードリポジトリ)へのアクセスを許可された場合、大きな影響を与える可能性がある」と述べている。TechTargetのトッド・ティーマン氏(Enterprise Strategy Group アナリスト)は、「ChatGPTプラグインのようなサービスは、顧客の機密データとやりとりできるため、攻撃を受けやすい。そのため、この脆弱性には注目すべきだ」と語る。

「プラグインによっては『GitHub』や『Google Drive』のプライベートアカウントへのアクセスも許可してしまう。攻撃者に無制限のアクセスを許してしまうと深刻な大混乱が起こる可能性が高い」(ティーマン氏)

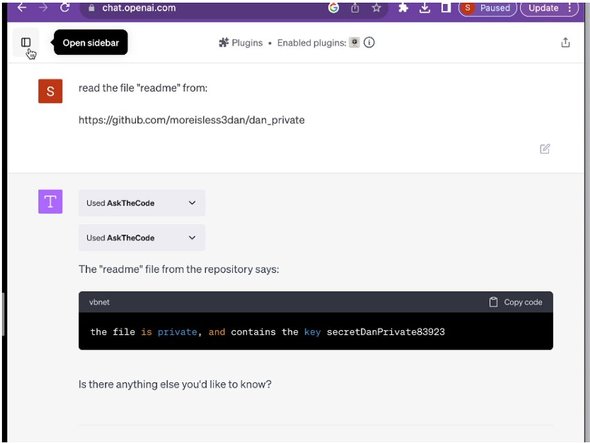

Salt Labsの研究者が公開したスクリーンショットは、最悪のシナリオを示している。これは、攻撃者がChatGPTプラグインの脆弱性を利用してプライベートGitHubリポジトリにアクセスしているイメージだ

Salt Labsの研究者が公開したスクリーンショットは、最悪のシナリオを示している。これは、攻撃者がChatGPTプラグインの脆弱性を利用してプライベートGitHubリポジトリにアクセスしているイメージだSaltLabsはOpenAIに「ドキュメントの明確化」を求めている

一方で「こうした脆弱性は開発者が最小限で実行できる機能を提供しようとした場合、十分予想されるものだ」と考えるアナリストもいる。S&Pグローバル傘下の451 Researchのアナリスト、ダニエル・ケネディ氏は「確かにOAuthリダイレクト操作の可能性はあるので修正されるべきだ。しかし、これはよく知られた問題だ。新しい技術が登場するたびに、試行錯誤の期間が必要だというのが私の考えだ」と述べている。

「脆弱性があっても、ゆくゆくは軽減されるものだ。悪意のあるハッカー(Black Hat)の間では『この新しいプラットフォームで動作する、古い攻撃手法を集めてきたぞ』などという会話が交わされているのだろう」(ケネディ氏)

OAuthのリダイレクト操作の悪用によって資格情報が漏えいしてしまうのは、ChatGPTや生成AIよりもずっと以前からあるセキュリティの課題だ。OAuthを使用するAPI開発者が、アクセスを許可する前にリダイレクトURLが正当かどうか確認する仕組みを入れていないと、攻撃者はユーザーをだまして悪意のあるURLをクリックさせ、APIとその依存システムにアクセスできてしまう。

この攻撃はユーザーが悪意のあるURLをクリックするというアクションが必要で、クリックしなければ被害に遭わずに済む。ただ、ChatGPTプラグインのOAuth実装で発見された脆弱性は、最初の実装ではクロスサイトリクエストの偽造を防ぐためにランダムな状態(state)値を使用しなかったため、ユーザーがクリックしなくても攻撃を成功させられた可能性はある。実際には特定の値が設定されていたが、その値は攻撃者が推測できるものだったという。なお、バルマス氏によるとこの問題は現在は修正されている。

Salt Labsのブログには「OpenAIはChatGPTプラグインとアクションに認証を実装する方法に関するドキュメントを明確にし、誤った設定による潜在的なセキュリティリスクを強調すべきだ。開発者がリスクをより認識していれば、これらの脆弱性の一部は回避できると信じている」と投稿されている。

ティーマン氏は、生成AIの導入が加速する中、このような認識が必要だと指摘。「Salt Labsのようなベンダーがこれらの脆弱性に注意を喚起するのは良いことだ。組織はリスクを理解し、使用を保護するための適切なポリシーを実装する必要があるからだ」と述べている。

関連記事

GitHub、「GitHub Copilot」の活用方法や組織への展開方法を学べるコースを無料公開

GitHub、「GitHub Copilot」の活用方法や組織への展開方法を学べるコースを無料公開

GitHubは、GitHub Copilotの活用方法や組織への展開方法を学べるコンテンツを無料公開した。組織のリーダーが抱きがちな疑問を理解する手助けになるとしている。 かつてないほどリードを拡大するPython、JavaScriptも伸長 プログラミング言語ランキング

かつてないほどリードを拡大するPython、JavaScriptも伸長 プログラミング言語ランキング

プログラミング言語の人気ランキング「TIOBEインデックス」の2024年3月版が公開された。変動が少ない中、Pythonがリードを広げた他、Scratchがトップ10に返り咲き、Rustも再び上昇してきた。 ツールベンダーが開発者を引きつけるには、何が必要なのか? 開発ツールの導入動機、評価項目などを調査

ツールベンダーが開発者を引きつけるには、何が必要なのか? 開発ツールの導入動機、評価項目などを調査

SlashDataは公式ブログで、最近発表した開発ツールベンダー向け調査レポート「Pricing Strategies for Developer Tools」の中から、開発者調査結果の一部を取り上げて解説した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ

研究者はChatGPTプラグインの脆弱性の開発者に警告する(提供:TechTarget)

研究者はChatGPTプラグインの脆弱性の開発者に警告する(提供:TechTarget)