Cohere、企業ワークロード向けLLM「Command R」のファインチューニング機能を提供開始:長いコンテキストのタスクや大規模な本番ワークロードに最適化されたLLM

Cohereは、2024年3月に発表したエンタープライズワークロード向け大規模言語モデル「Command R」のファインチューニング機能を提供開始した。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

Cohereは2024年5月9日(米国時間)、同年3月に発表した大規模言語モデル(LLM)「Command R」のファインチューニング機能を提供開始したと発表した。

Command Rは、エンタープライズグレードのワークロード向けのスケーラブルなLLMだ。CohereはRシリーズのLLMとしてCommand Rと、より大規模で強力な「Command R+」(同年4月に発表)をラインアップしている。

ファインチューニング機能を利用することで、企業はCommand Rに自社固有の用語や文言、ドキュメントを取り込み、自社のニーズに合わせて高度にカスタマイズしたモデルを作成できる。

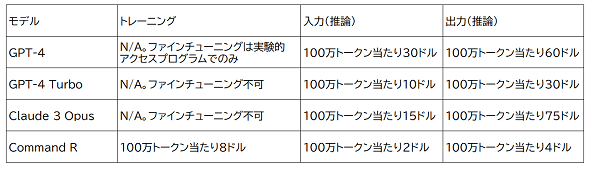

管理されたファインチューニング機能をCommand Rで実行することで、パフォーマンスをさらに向上させ、市場に出回っているLLMと比べて、わずかなコストで高い成果を得ることができると、Cohereは述べている。顧客は最大5つのハイパーパラメーターを調整でき、モデルのパフォーマンスを効率的に最適化しながら、より大規模な他モデルと比べコストを15分の1まで抑えることができるという。

Command RはCommand R+と同様に、12万8000トークンのコンテキストウィンドウを備え、長いコンテキストのタスクや大規模な本番ワークロードに最適化されている。例えば、ハルシネーション(AIがもっともらしいが誤った回答を返すこと)を減らすインライン引用を含む高度な検索拡張生成(RAG)、複雑なビジネスワークフローを自動化するツールの使用、グローバルビジネスをサポートするための10カ国語対応(日本語を含む)といった特徴を持つ。

エンタープライズユースケースでの他の大規模モデルとの精度比較

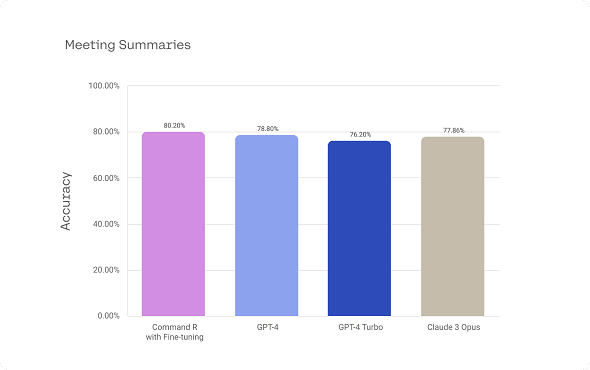

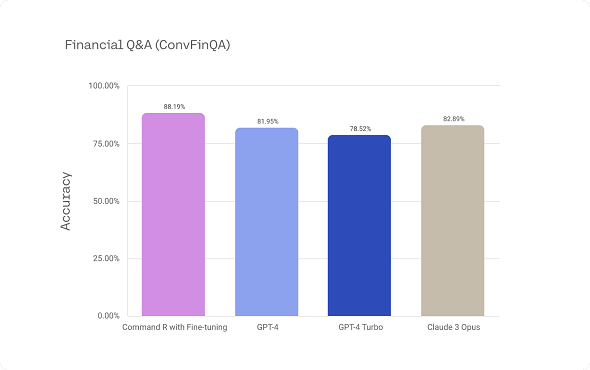

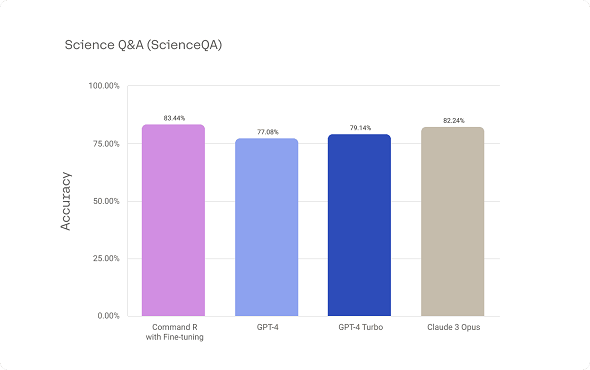

Cohereは、金融サービスや科学研究のような情報集約型の業種を想定した「要約」「調査、分析」といったユースケースにおいて、ファインチューニングしたCommand Rと、より大規模な他モデル(GPT-4、GPT-4 Turbo、Claude 3 Opus)のパフォーマンス(精度)を比較した結果として下の3つのグラフを紹介し、ファインチューニングしたCommand Rの価格性能比の高さを強調している。

会議録要約の精度

会議録要約に関するファインチューニング済みCommand R、GPT-4(0613)、GPT-4 Turbo(gpt-4-turbo-2024-04-09)、Claude 3 Opusのパフォーマンス比較(合格率)(提供:Cohere)

会議録要約に関するファインチューニング済みCommand R、GPT-4(0613)、GPT-4 Turbo(gpt-4-turbo-2024-04-09)、Claude 3 Opusのパフォーマンス比較(合格率)(提供:Cohere)複雑な金融クエリ処理の精度

ConvFinQAデータセットに関するファインチューニング済みCommand R、GPT-4(0613)、GPT-4 Turbo(gpt-4-turbo-2024-04-09)、Claude 3 Opusのパフォーマンス比較(提供:Cohere)

ConvFinQAデータセットに関するファインチューニング済みCommand R、GPT-4(0613)、GPT-4 Turbo(gpt-4-turbo-2024-04-09)、Claude 3 Opusのパフォーマンス比較(提供:Cohere)幅広い科学的な多項選択式の質問に対する回答の精度

ScienceQAデータセットに関するファインチューニング済みCommand R、GPT-4(0613)、GPT-4 Turbo(gpt-4-turbo-2024-04-09)、Claude 3 Opusのパフォーマンス比較(提供:Cohere)

ScienceQAデータセットに関するファインチューニング済みCommand R、GPT-4(0613)、GPT-4 Turbo(gpt-4-turbo-2024-04-09)、Claude 3 Opusのパフォーマンス比較(提供:Cohere)効率性とコスト

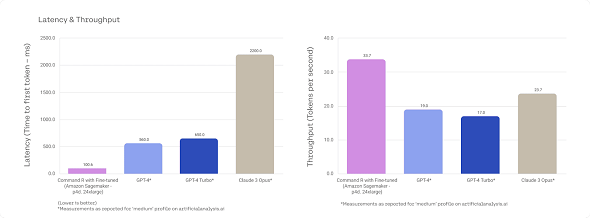

ファインチューニングしたCommand Rは、より大規模でホスティングとサービス提供のコストが高いモデルと比べて、より効率的にサービスを提供でき、トークンのレイテンシ短縮とスループット向上により、より優れたユーザー体験を提供すると、Cohereは述べている。こうした高いパフォーマンスとコストの低さから、Command Rはより大規模で高価なモデルと比べて、多くのエンタープライズユースケースで魅力的な選択肢になるとしている。

「Amazon SageMaker」のp4d.24xlargeインスタンスに展開したファインチューニング済みCommand Rと、同じプロファイルでのGPT-4(0613)、GPT-4 Turbo(gpt-4-turbo-2024-04-09)、Claude 3 Opusの報告数字によるレイテンシとスループットの比較(提供:Cohere)

「Amazon SageMaker」のp4d.24xlargeインスタンスに展開したファインチューニング済みCommand Rと、同じプロファイルでのGPT-4(0613)、GPT-4 Turbo(gpt-4-turbo-2024-04-09)、Claude 3 Opusの報告数字によるレイテンシとスループットの比較(提供:Cohere)Command Rのファインチューニング機能の提供

企業や開発者はCommand Rのファインチューニング機能を、Cohereプラットフォーム(Cohere Dashboard、ファインチューニングAPI、Python SDK)とAmazon SageMakerですぐに利用できる。この機能は近い将来、他のプラットフォームでも利用可能になる。

関連記事

Cohere、強力でスケーラブルなRAG最適化LLM「Command R+」を発表

Cohere、強力でスケーラブルなRAG最適化LLM「Command R+」を発表

Cohereは、同社のプロダクトの中で「最も強力でスケーラブル」とする大規模言語モデル「Command R+」を発表した。 Red Hatが誰でもLLM開発に貢献できるオープンソースプロジェクト、「InstructLab」を発表

Red Hatが誰でもLLM開発に貢献できるオープンソースプロジェクト、「InstructLab」を発表

Red HatがオープンソースLLMをさらにオープンソース化するプロジェクト、「InstructLab」を開始した。誰でもLLM開発に参加することができ、「生成AIの未来をともに形作れる」と訴えている。まずIBM Researchの「Granite」モデルなどから始める。 NEC、生成AI「cotomi」のラインアップを拡充 高速LLM「cotomi Pro」「cotomi Light」を発表

NEC、生成AI「cotomi」のラインアップを拡充 高速LLM「cotomi Pro」「cotomi Light」を発表

NECは、同社の生成AI「cotomi」において新たな2つのモデル「cotomi Pro」「cotomi Light」を発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ