生成AIの活用を検討する企業が「RAG」を導入すべき5つの理由 Cohere:外部情報を取り込み、信頼性と関連性を高められる

Cohereは、企業が生成AI活用を推進する上でRAGが重要な役割を果たすとし、5つの理由を解説した。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

Cohereは2024年5月24日(米国時間)、企業が生成AI(人工知能)の活用を推進する上で、RAG(Retrieval-Augmented Generation:検索拡張生成)を導入すべき5つの理由を、公式ブログで解説した。

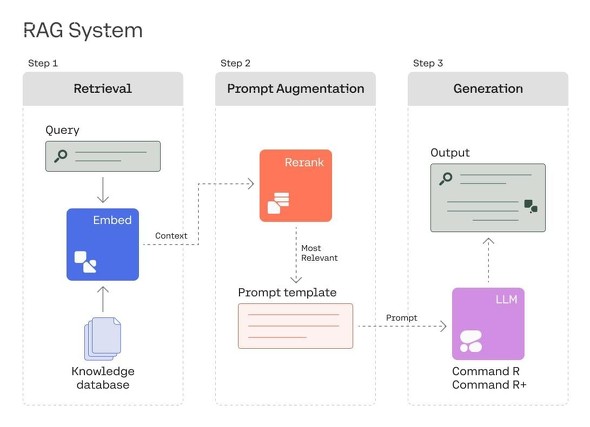

RAGは、LLM(大規模言語モデル)の回答に特定の情報源を組み合わせることであり、「検索」「プロンプトの拡張」「生成」というステップで構成されている。

Cohereは、RAGを用いた質問から回答までの流れと企業がRAGを導入すべき理由を次のように解説している。

RAGを用いた質問から回答までの流れ

検索

まず、ユーザーがシステムに質問すると、システムはデータソースから情報を検索して引き出そうとする。これには基本的なキーワード検索エンジンを使用する場合もあれば、埋め込みによる高度なセマンティック検索を使用することもある。どちらの場合でも、LLMがユーザーの質問に答えるため最も正確なデータを見つけることが目的だ。

プロンプトの拡張

次に、LLMは複数のドキュメントやデータのうち、どれが最も質問に関連しているかを推論し、ユーザーの質問と最も関連するドキュメントやデータを組み合わせて新しいプロンプトを作成する。

生成

最後に、新しく作成されたプロンプトを通じて、LLMが回答を生成する。これらの回答は、参照した情報を明示するため、透明性が確保される。

LLMを活用する企業にとってRAGが重要である5つの理由

1.ハルシネーションが減り、信頼が増す

LLMは、必要な知識が不足している場合、「ハルシネーション」という不正確または無意味な回答を生成する場合がある。RAGにより、適切な外部データをLLMに提供することでハルシネーションを軽減し、検証可能な情報源に基づいた回答ができるようになる。これらにより、LLMに対するユーザーの信頼を高めることができる。特定の専門分野に関する質問で事実の正確性を求められる場合、特に有効だ。

2.回答の正確性と関連性の向上

RAGにより、LLMはデータベース、ドキュメント、ナレッジベースなどの外部のデータソースから最新かつドメイン特有の情報にアクセスし、取り入れることができるようになる。モデルのトレーニングデータが古かったり知識が不足していたりする可能性があっても、事実やコンテキストに基づいたデータにより、LLMの回答精度と関連性を向上できる。

RAGは複数のモデルやステップを含むワークフローであるため、それぞれの部分を調整してパフォーマンスを向上させることができる。例えば、RAGの検索ステップを最適化することで最大50%、回答精度を改善できる。

3.カスタマイズし、パーソナライズできる

RAGにより、企業は社内のナレッジベースや顧客記録、CRMやERP(Enterprise Resources Planning)ソリューションなどを含む機密情報から独自のデータを取り込んで、LLMソリューションをカスタマイズできる。特定のビジネスドメイン、製品、サービス、顧客ニーズに応じた回答が可能となる。

IBMは現在、RAGを使用して、検証済みかつ信頼できるコンテンツに基づいた社内のカスタマーケアチャットbotを構築している。Databricksのように、ユーザーの特定のニーズに合わせて回答を生成するドキュメントチャットbotも構築できる。

4.スケーラビリティと適応性

外部のナレッジソースを更新したり拡張したりすることで、LLMソリューションを最新の情報、最新の状態に保つことができる。LLMの再トレーニングやファインチューニングをせず、より簡単に、変化するビジネス要件に適応でき、コスト効率も向上する。

検索と生成コンポーネントを分離することで、各コンポーネントを個別に拡張したり、独立して提供したりできる。LLMを変更せずに、特定の情報に対してロールやユーザーベースのアクセス制御を実装するなどのカスタマイズも可能だ。

5.可監査性と透明性

情報の取り扱いに関する厳格なコンプライアンス要件がある規制産業や重要な意思決定シナリオにおいては、LLMの不正確な回答により、知的財産権を侵害したり、誤った情報を広めたりしてしまうリスクがある。

RAGを通じて外部データソースを活用することで、回答結果の可監査性、説明可能性、信頼性を向上できる。ハルシネーションの問題が完全に解決されるわけではないが、誤用や誤解による法的リスクおよび責任を軽減できる。

Cohereは「エンタープライズAIを構築する企業が、LLMソリューションの多様性と複雑さを管理するためにRAGを選択するのは当然のことだ」と結論付けている。

関連記事

生成AIをアプリケーション開発に活用する企業は、コストやハルシネーションの問題にどう取り組んでいるのか

生成AIをアプリケーション開発に活用する企業は、コストやハルシネーションの問題にどう取り組んでいるのか

Amazon Bedrockを早期導入した企業の担当者らが、クラウドのコスト管理からプロンプトの記述に至るまで、アプリケーション開発における生成AI活用のポイントを語った。 Cohere、企業ワークロード向けLLM「Command R」のファインチューニング機能を提供開始

Cohere、企業ワークロード向けLLM「Command R」のファインチューニング機能を提供開始

Cohereは、2024年3月に発表したエンタープライズワークロード向け大規模言語モデル「Command R」のファインチューニング機能を提供開始した。 Snowflake、エンタープライズタスク向け大規模言語モデル「Snowflake Arctic」を発表

Snowflake、エンタープライズタスク向け大規模言語モデル「Snowflake Arctic」を発表

Snowflakeは、エンタープライズAIに最適なLLM「Snowflake Arctic」を発表した。エンタープライズインテリジェンス、画期的な効率性、真のオープン性という特徴を備える。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.