第4回 クラスタリングとライセンス・コストを考慮した全体設計:Windows Server 2012 R2時代のHyper-Vサーバ設計術(1/4 ページ)

Windows Server OSのHyper-Vの性能を最大限に引き出すための仮想化システム設計ガイドの最終回。今回は次世代の高速インターフェイスとして普及が見込まれるInfiniBandと、冗長化のためのクラスタリング手法、ミドルウェアのライセンス・コストを削減するためのクラスタ設計手法についてまとめておく。

本連載では、Windows Server 2012 R2のHyper-Vをベースにして、現在求められる仮想化システムの技術トレンドや設計、機器の選択方法などについて、全4回で解説します。

- 第1回「最新モデルを意識したCPUとメモリのサイジング」

- 第2回「Hyper-Vと最新のストレージ・テクノロジの併用」

- 第3回「Hyper-Vネットワーク設計のベストプラクティス」

- 第4回「クラスタリングとライセンス・コストを考慮した全体設計(今回)」

プロセッサやメモリ・ストレージ・ネットワークと、3回にわたってHyper-Vホストを設計・構築するためのポイントをコンポーネントごとに解説してきた。最終回である今回は、ここまでの回で書き切れなかった部分について解説するとともに、クラスタリングなどの全体設計や、ハードウェアだけでなくミドルウェアのコストを削減する設計についても紹介する。

まずは、第3回で紹介した10GbE(10Gbpsイーサネット)や最新の40GbE(40Gbpsイーサネット)と並び、次世代の高速ネットワークの一翼を担う「InfiniBand」について解説しておこう。

次世代の高速インターフェイス「InfiniBand」

InfiniBandは、ギガビット・イーサネットや10GbEといった、20年以上主流の“イーサネット”とは異なる伝送方式を用いて、最大56Gbpsもの超高速通信を行う規格である。低レイテンシであることも1つの特長であり、従来はこれを生かしてHPC(High Performance Computing)などの並列計算クラスタに利用されてきたが、ここ数年はLinux OSやOracleデータベースといったエンタープライズ・システムでも利用するようになってきた。2014年後半には100Gbpsに対応した製品も出荷されるといわれている。

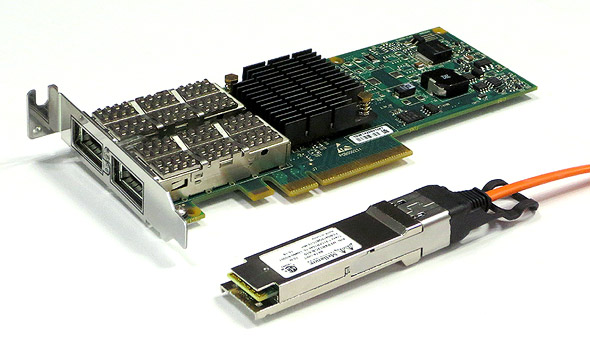

図1「InfiniBand対応機器」

図1「InfiniBand対応機器」これは「HP Infiniband FDR 56Gb / 10-40GbE 2P 544QSFP HCA」の例。米Mellanox社のHCA*1で、56Gbps規格のInfiniBand FDRだけではなく、接続先スイッチによって10GbEや40GbEのイーサネット通信インターフェイスとしても利用できるハイブリッド対応なところも特徴的だ。

*1 InfiniBandのアダプタは、NIC(Network Interface Card)やHBA(Host Bus Adaptor)ではなく「HCA(Host Channel Adapter)」と呼ばれる。

Windows 環境においても、Windows Server 2012の新機能「SMBダイレクト」がRDMA(Remote Direct Memory Access)を要件に挙げており、このRDMAを実現するハードウェアの1つとしてInfiniBandの採用が少しずつ増えてきた。

- Windows Server 2012クラウドジェネレーション 第9回「強化されたファイル共有プロトコルSMB 3.0の概要」

IPoIBでIPネットワークを形成

SMBダイレクトはSMB通信をアクセラレーションするものだ。SMBストレージへのアクセス高速化やライブ・マイグレーションの処理時間短縮などと、利用用途は限定的であるといわざるを得ない。

しかしながら、InfiniBandは実はSMBダイレクトだけでなく、より汎用的に活用することもできる。InfiniBandを伝送媒体としてIPネットワークを形成する「IPoIB(IP over InfiniBand)」だ。IPoIBを利用することで一般的なTCP/IP通信に対応可能となり、10GbEや40GbEの代わりにIPネットワークを形成できる。

図2のように、IPoIBにはオーバーヘッドがあるが、InfiniBand の最大の特長はそのコスト・パフォーマンスであり、10GbEの予算で56Gbpsのネットワークを敷設できる。もちろん、iSCSIトラフィックを流すことも可能だ。

図2「IPoIBのプロトコル・スタック」

図2「IPoIBのプロトコル・スタック」IPoIB(IP over InfiniBand)はInfiniBandを伝送媒体として汎用的なIPネットワークを形成する技術。ネイティブ的にIP通信を行えるイーサネットに比べてオーバーヘッドはあるが、現行規格は56Gbpsと広帯域であるため、減衰が大きくても十分に高速なIP通信を実現できる。

実際にIPoIBでIPネットワークを構築する場合は、次のような点に注意が必要だ。

1つは、データセンター・ネットワークを運用していくための管理技術とノウハウである。InfiniBandはイーサネットのような階層型ではなく、ファブリック型のトポロジを取る。どちらかというと、ストレージのファイバ・チャネルに近いトポロジになるだろう。また、InfiniBandはIPoIBに限らず、トポロジごとに「サブネット・マネージャ」と呼ばれる、調停サービスを稼働させる必要があるところも特徴的だ。InfiniBandスイッチにはサブネット・マネージャの機能を持つ「管理型」のものと、機能を持たない「非管理型」があり、非管理型の場合はトポロジ上のどこかのサーバ側でソフトウェア型のサブネット・マネージャを稼働させる必要がある。サブネット・マネージャのダウンは通信障害につながるため、冗長化も忘れてはならない。

このように、InfiniBandは従来のイーサネットと大きく違う部分が大きく、これまで培ったイーサネットのスキルを生かしづらい。構築はもちろん、トラブルシューティングといった運用を考えると、かなりの部分を一から学び直すことになるだろう。また、イーサネットと比べると運用管理周りの技術やノウハウがまだ成熟していない。

もう1つの注意点は、既存のイーサネットとの相互接続だ。ホスト間のインターコネクトに使うのであれば問題ないが、仮想マシン用ネットワークといった業務系についてはオフィスやインターネットにも接続しなければならないだろう。つまり、どこかでInfiniBandからイーサネットへプロトコル変換をしなければならない。InfiniBandの導入に適する部分はToR(Top-of-Rack)スイッチといった「エッジ周り」が中心となる。イーサネット・ベースである基幹スイッチとInfiniBandを中継する「InfiniBandゲートウェイ」という機器も忘れてはならない。

図3「InfiniBandによるIPネットワークの構成イメージ」

図3「InfiniBandによるIPネットワークの構成イメージ」オフィスLANやインターネット回線まで考えると、企業のすべてのネットワークをInfiniBandに一本化することはできない。現実的にはデータセンターのエッジ、つまりサーバとToR(Top-of-Rack)のスイッチ間を一本化して置き換えることになるだろう。イーサネットとプロトコル変換を行うために「InfiniBandゲートウェイ」が必要になる。また、InfiniBandはトポロジごとに「サブネット・マネージャ」と呼ばれる調停サービスが必要だ。トポロジ上のどこかのサーバもしくはスイッチ上に2カ所(冗長化必須)設置しなければならないことも忘れてはならない。

Copyright© Digital Advantage Corp. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ