IBM研究所、動的なパターンを学習できる人工ニューラルネットワークモデルを開発――自動車事故の予測や、作曲、文章校正にも応用できる可能性:より生物に近い機械学習の実現を目指し

IBM東京基礎研究所は2015年9月16日、従来の人工ニューラルネットワークをさらに発展させ、より生物に近い学習を実現するためのモデル「動的ボルツマンマシン(DyBM)」を開発したと発表した。

IBM東京基礎研究所 恐神貴行氏らのチームは2015年9月16日、生物の脳における学習の仕組みを摸した人工ニューラルネットワークをさらに発展させ、より生物に近い学習を実現するためのモデル「動的ボルツマンマシン(DyBM)」を開発したと発表した。

従来の人工ニューラルネットワーク研究では、1949年にカナダの心理学者ドナルド・ヘッブ氏が提唱したニューロン同士の結合メカニズムに関する「ヘブ則」と呼ばれる法則と、それを基にジェフリー・ヒントン氏らが1985年に開発した「ボルツマンマシン」などの人工ニューラルネットワークモデルが基礎となってきた。

しかし、ヘブ則は静的な状態でのニューロン結合を想定しているため、ボルツマンマシンにおいても、動的に変化するパターンの学習には対応することができなかった。

近年では、実際の生物の学習においてはニューロンの活動のタイミングなど、時間的な要素が影響を及ぼすという見方が強くなっており、ヘブ則に時間的な要素を付加してより精緻化した「スパイク時間依存シナプス可塑性(SPTD:Spike-Timing-Dependent synaptic Plasticity)」と呼ばれる理論が提唱されていた。

DyBMは、このSPTDの応用を目的として開発された人工ニューラルネットワークモデルであり、コンピューター上で、SPTDに基づいた機械学習を再現することができる。

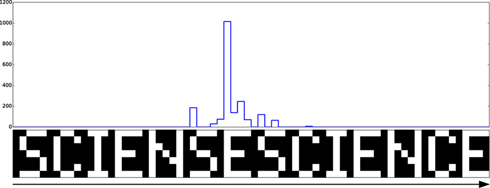

恐神氏らは、DyBMの複数のニューロンに、ビットの行列で構成された文字列などのパターンをシーケンシャルに学習させ、その後、イメージ全体の再現や補完などを行わせる検証を実施した。例えば、「SCIENCE」という文字列パターンの学習では、縦7ビット×横35ビットからなるパターンの各行に対応する7個のニューロンに、1列ずつビットパターンを繰り返し学習させたところ、13万回の訓練で文字列全体が再現されたという。

また、「SCIENCE」の学習後に、あえて誤りを含む文字列を与えたところ、つづりの間違いを検知する結果も得られた。

さらに同チームでは、複数のパターンを同時に記憶させたり、音楽を学習させたりすることにも成功しており、将来的にDyBMは、自動車事故の予測や、作曲、文章校正などにも応用できる可能性があるとしている。本研究に関する論文はNatureが発行するオンライン誌「Scientific Reports」にも掲載されている(詳細は関連リンクを参照)。

関連記事

グーグルの人工知能を利用できるWebインターフェースが登場

グーグルの人工知能を利用できるWebインターフェースが登場

再びニューロチップに注目が

再びニューロチップに注目が

原子だけで作った映画はストレージ技術をどう進化させるか?

原子だけで作った映画はストレージ技術をどう進化させるか?

あなたの知らない自動運転技術の歴史とGoogle Carの自動運転に使用するセンサーの基礎知識

あなたの知らない自動運転技術の歴史とGoogle Carの自動運転に使用するセンサーの基礎知識

機械学習技術を容易に活用できる、「Amazon Machine Learning」ってどんなもの?

機械学習技術を容易に活用できる、「Amazon Machine Learning」ってどんなもの?

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.