Sparkは“誰”に例えられる?──多様化と進化を続ける「Hadoop」、人気急上昇「Spark」:Database Watch(2016年3月版)(1/2 ページ)

先日、日本Hadoopユーザー会主催のイベントが開催されました。データベースと関係性が深いデータ分散処理プラットフォームである「Hadoop」と「Spark」の最近事情に迫ります。

2016年2月、日本Hadoopユーザー会主催のイベント「Hadoop Conference Japan 2016」および「Spark Conference Japan 2016」が開催されました。

2016年で誕生10周年を迎えた「Apache Hadoop」(以下、Hadoop)は、従来のリレーショナルデータベース(RDB)とは異なり、データの格納や処理を並列分散型で実行するオープンソースソフトウェアのデータ処理基盤です。高価なハードウェアとRDBによる実装と異なり、汎用的なサーバを使って処理を行うこと、大量のデータ処理をこなせることから、IT投資の考え方やデータを扱う業務そのものの可能性が広がると期待されています。Hadoopの国内の最新事情をカバーできるHadoop Conference Japanは、そのエンタープライズ需要の高まりとともに、毎年恒例のイベントとして定着したようです。

併せて、Hadoop+MapReduceよりも高速でニアリアルタイムに大規模データを分析できる存在として注目される「Apache Spark」(以下、Spark)に関するイベントも共催されました。今後、厳しさが増すであろう市場環境で武器となる「正確な現状把握」と「高精度な予測」をどう得るか、ビッグデータ活用/データ分析の需要の高まりが伺い知れます。

今回はHadoopとSpark、並列分散処理プラットフォーム/フレームワークの最近動向を確認していきます。

Hadoop:YARNの普及、多様なミドルウェアの登場、ハードウェア進化への追従

基調講演の冒頭に登壇した、日本Hadoopユーザー会の濱野賢一朗氏(NTTデータ)は「“Hadoop”は、一つのものではなくなった」と活用シーンが多様化する実情に触れながら、「分散処理はまだまだ進化、変化、浸透していく。これからだ」と述べました。

Hadoopは、主に分散ファイルシステム「HDFS(Hadoop Distributed File System)」と、並列分散処理を行う「MapReduce」で構成されます。

近年は、Hadoopの関連プロダクトであるリソース管理機構「YARN(Yet Another Resource Negotiator)」も急速に広まっています。イベントのアンケート結果では、回答者の約6割が既に使っていると答えたそうです。

もともとYARNは、メモリやCPUなどのリソース管理を行うものでした。しかし、近年は処理系のマスターも管理できるように発展し、多様な分散アプリケーションを実行するための基盤となりつつあります。Hadoopコミッターの小沢健史氏は、「(YARNが出てきたことで、)得意なことを、得意なものに任せる環境が整ってきた」と現状を説明しました。

この他にも、Hadoop環境で動くミドルウェアが幾つも登場しています。例えばバッチ処理のフレームワーク「Apache Tez」、クエリ記述言語の「Apache Pig」、ワークフロー管理エンジン「Apache oozie」、NoSQLデータベース「Apache HBase」、リアルタイム分析基盤「Apache Storm」などです。Hadoopのエコシステムが急速に広がっていると小沢氏らは述べています。

インタフェースはどうでしょうか。当初、Hadoopのデータを扱うには「MapReduceのAPI」が必要でした。しかし、「MapReduceはプログラミングが難しい。SQLのように扱いたい」という要望が急増したことから、近年では、バッチ処理では「SQLに似た言語で行う」ことが主流になりつつあります。例えば「HiveQL」「Pig Latin」「Spark DataFrame」などのクエリ言語が挙げられます。

他にも、バッチ処理とストリーミング処理を透過的に扱える言語「Apache Flink」や「DataFlow」、機械学習に特化した高水準言語「Apache SystemML」や「TensorFlow」などがあります。Apache SystemMLやTensorFlowは、CPUだけではなくGPGPUやFPGAなどのリソースも利用できるため、小沢氏は「今後YARNは、GPGPUやFPGAを含むさまざまな計算リソースを扱えるような“データセンターOS”としてさらなる進化を遂げていく」と見ているようです。

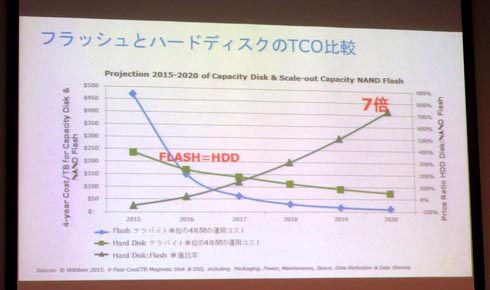

また、Hadoopはハードウェアの進化とも比例して発展しています。例えばデータベースと分析基盤のストレージを、これまでのHDDから高速なフラッシュ(SSD)に置き換える動きが加速しています。調査会社Wikibonの資料によると、HDDとフラッシュにおける今後4年間のTCOは2016年に同等となり、2017年には逆転、そして2020年には約7倍まで開くと予測されています。フラッシュの容量単価はまだ高額ですが、圧倒的な速度差が寄与する生産性や競争力強化への効果、人件費や電力、ラックスペースの圧縮といった運用全体のコストで換算すると、その差は急速に縮まると見られています。Hadoopはこうしたストレージ市場の動向を踏まえ、HDFSにデータを書き込むときにも、高速に処理したいデータはフラッシュへ、そうでないものはHDDへ、というように優先度に応じて書き込み先を使い分けられる機能が備わりました。

フラッシュとHDDのTCOの差は急速に縮まっている。4年間のTCOのため不確定な要素が多いのは勘案すべきだが、2017年にはフラッシュが逆転し、2020年にはその差が7倍まで開くと予測している(出典:Wikibon 2015 / Evolution of All-Flash Array Architectures)

フラッシュとHDDのTCOの差は急速に縮まっている。4年間のTCOのため不確定な要素が多いのは勘案すべきだが、2017年にはフラッシュが逆転し、2020年にはその差が7倍まで開くと予測している(出典:Wikibon 2015 / Evolution of All-Flash Array Architectures)Hadoop開発プロジェクトのコミッターである鯵坂明氏は、Hadoopで今後改善される項目に、「メンテナンスリリースの継続」「Java 8/9対応」「(GPGPUやフラッシュストレージなどの新たなハードウェアの利用を意識した)さらなる高速な処理基盤の実現」を挙げました。また、「Hadoopの開発者をもっと増やし、コミュニティーをもっと盛り上げたい」と話し、今後のデータ分析の需要増を見越した積極的な導入支援も行っていく考えを示しました。

当日はヤフーの遠藤禎士氏も登壇し、月間649億PV(ページビュー)、秒間5万アクセスがある大規模サイト「Yahoo!Japan」が活用するデータ分析プラットフォームが示されました。現状、RDBには「MySQL」(実質は、MySQLを改良した商用DB「Percona」)や「Oracle Database」、データウェアハウスには「Teradata」、KVS(Key Value Store)には「Cassandra」などを多様に組み合わせており、今後、コスト効果を高めるために「Open Compute Project(OCP)」に基づく製品で構成した大規模なHadoop/Spark環境も広げていく予定としています。同社はデータ容量や処理要求の増加と比例し、ビッグデータの活用に必要なハードウェア処理性能も増えていることから、インフラ面におけるコスト削減を課題としていました。なんでも3000台のHadoopクラスタをわずか8カ月で使い切ってしまったそうです。

こうした課題解決のためのチューニングや、OCPに準拠したハードウェアを用いるといった各種の最適化を図りつつ、遠藤氏は今後を見据えたアプローチも示しました。「これからは“USE”から“MAKE”へ」──。ユーザー企業も、使うだけではなく開発にも積極的に関わる。開発に携わることで、自らが抱える課題を根源的に解決するという考え方です。何よりも「コミュニティーに貢献していきたい」という気持ちが動機となっていると強調しました。

関連記事

- 「Database Watch」バックナンバー

- Database Expert

実践! 「MapReduceでテキストマイニング」徹底解説

実践! 「MapReduceでテキストマイニング」徹底解説

Hadoopとは何かを解説し、実際にHadoopを使って大規模データを対象にしたテキストマイニングを行います。テキストマイニングを行うサンプルプログラムの作成を通じて、Hadoopの使い方や、どのように活用できるのかを解説します Hadoopは「難しい・遅い・使えない」? 越えられない壁がある理由と打開策を整理する

Hadoopは「難しい・遅い・使えない」? 越えられない壁がある理由と打開策を整理する

ブームだったHadoop。でも実際にはアーリーアダプター以外には、扱いにくくて普及が進まないのが現状だ。その課題に幾つかの解決策が出てきた。転換期を迎えるHadoopをめぐる状況を整理しよう。 Apache Sparkに注力するIBM、目指すは「データ分析のOS」

Apache Sparkに注力するIBM、目指すは「データ分析のOS」

北米トヨタ販売子会社での採用事例の発表などもあり、日本国内でも注目を集めつつある「Apache Spark」。具体的にはどんな特徴があって、何ができるのだろうか。Sparkへの大規模投資を発表したIBM(日本IBM)を取材した。 GoogleのMapReduceアルゴリズムをJavaで理解する

GoogleのMapReduceアルゴリズムをJavaで理解する

最近注目を浴びている分散処理技術「MapReduce」の利点をサンプルからアルゴリズムレベルで理解し、昔からあるJava関連の分散処理技術を見直す特集企画(編集部) ヤフー、Open Compute Project仕様の大規模インフラ基盤を構築

ヤフー、Open Compute Project仕様の大規模インフラ基盤を構築

CTCが、ヤフーの米国法人が持つデータセンターへビッグデータの活用を目的とする大規模なインフラ基盤を構築。Open Compute Projectを活用することで、調達コストを削減できたという。2016年早期の本稼働を目指す。 米アップルも参加するOpen Compute Projectが新たな段階に

米アップルも参加するOpen Compute Projectが新たな段階に

Open Compute Project Foundationは2015年3月10日(米国時間)、米カリフォルニア州サンノゼでOpen Compute Summit 2015を開幕、米ヒューレット・パッカードが新たなサーバー製品ラインを発表するなど、参加ベンダー/製品、ユースケースの両面で、このプロジェクトの広がりを印象付けた。

Copyright © ITmedia, Inc. All Rights Reserved.