自動運転ミニカー、AIチップなど、AWS re:Invent 2018における機械学習/AI関連の発表まとめ:AWS re:Invent 2018発表まとめ(1)(2/2 ページ)

強化学習のためのパイプライン「Amazon SageMaker RL」

「Amaon SageMaker RL」は、Amazon SageMakerの機械学習パイプライン機能を、強化学習に適用するサービス。必要なツールキットを、あらかじめ統合している。Tensorflow、MXNet、Intel Coach、Ray RLに対応。シミュレーターとしては、AWS RoboMakerおよびAmazon Sumerian、Open AI Gym準拠のRoboschoolやEnergyPlus、商用のMATLABやSimulinkなどが使える。

推論をハードウェアに合わせて自動的にチューニングできる「Amazon SageMaker Neo」

デプロイ先のハードウェアを意識せずに、単一の機械学習モデルをどこにでもデプロイできるようにするAmazon SageMakerの新機能が「Amazon SageMaker Neo」。EC2インスタンス、Amazon SageMakerエンドポイント、AWS Greengrassデバイスを対象に、Amazon SageMakerはユーザーの訓練したモデルをデプロイ先のスペックに合わせ、自動で最適化作業を行う。

推論の課題に応える「AWS Elastic Inference」「AWS Inferentia」

AWS CEOのアンディ・ジャシー氏は、「機械学習関連インフラコストの大部分、おそらく90%を推論が占めている」と話した。AWSはre:Invent 2018で、推論に関連し、2つの発表を行った。

「AWS Elastic Inference」

推論における処理性能ニーズは多様。GPUを使う必要があるケースは多いが、GPUは高価であり、効率的な利用が難しい。この点に着目した新サービスが「AWS Elastic Inference」。適切な量のGPUによる推論高速化機能を、あらゆるEC2インスタンスタイプと組み合わせて利用できるという。Elastic Inferenceには8、16、32TFLOPSの3タイプがある。これをアプリケーションにとってユーザーが最適と考えるインスタンスタイプと組み合わせ、リソース利用の効率化を図れるという。

推論を高速化するAIチップ、「AWS Inferentia」

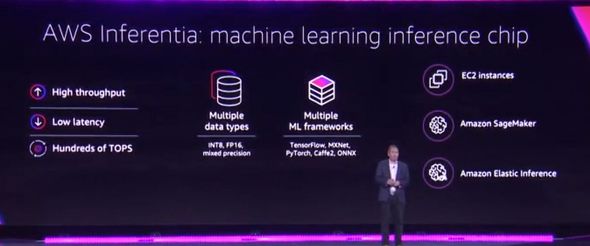

AWSは、推論プロセスの高速実行に特化した自社開発チップ、「AWS Inferentia」を2019年に提供開始すると発表した。

低遅延、高処理性能が特徴で、Tensorflow、MXNet、Caffe2、PyTorch、ONNXといったフレームワークに対応する。「数百TOPS(Tera Operations per Second)の能力を備える」とアンディ・ジャシー氏は話している。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ