Meta、生成AIモデルを使った責任ある開発を支援する「Purple Llama」プロジェクトを発表:信頼と安全性につながるツールと評価基準、方法を提供

Metaは、オープンな生成AIモデルを使った責任ある開発を支援する包括的プロジェクト「Purple Llama」を立ち上げた。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

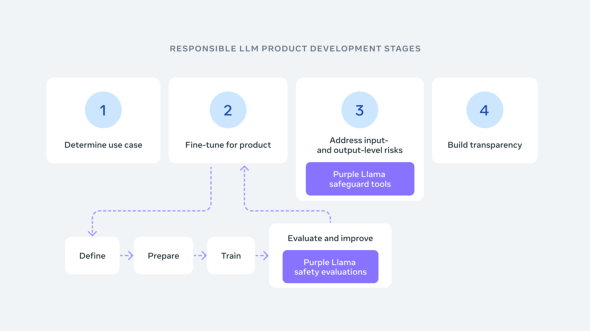

Metaは2023年12月7日(米国時間)、「Purple Llama」の立ち上げを発表した。Purple Llamaは、オープンな生成AI(人工知能)モデルを使って責任ある開発を推進するためのツールと評価基準、方法を整備する包括的なプロジェクトだ。

生成AIを用いた開発の信頼と安全性の確保に重要なこれらのオープンなツールと評価基準、方法は、Metaのオープンソース大規模言語モデル(LLM)「Llama 2」の「Responsible Use Guide」(責任ある使用のためのガイド)で共有されているベストプラクティスに従って、開発者が責任を持って生成AIモデルや体験をデプロイ(展開)するための公平な土俵を提供することが意図されている。

MetaはPurple Llamaの第1ステップとして、LLMのサイバーセキュリティ安全性評価ベンチマークのセット「CyberSecEval」と、展開しやすいように最適化された入出力フィルタリングのための安全性分類器「Llama Guard」を発表した。

LLMのコンプライアンスを確保するCyberSecEval

業界のガイダンスや標準(CWE〈Common Weakness Enumeration:共通脆弱《ぜいじゃく》性タイプ〉、MITRE ATT&CKなど)に基づくベンチマークセットであるCyberSecEvalでは、2つの重要なセキュリティ領域でLLMを徹底的に評価できる。それは、「LLMが安全でないコードを生成する傾向」と、「サイバー攻撃を支援するよう求められたときのLLMのコンプライアンスレベル」だ。

Metaの論文によると、7つのLLM(Llama2、codeLlama、OpenAIのGPTファミリー)を含むケーススタディーを通じて、CyberSecEvalは主要なサイバーセキュリティリスクを効果的に特定した。さらに、これらのモデルを改良するための実践的な洞察を提供した。

Metaは、同研究から得られた重要な観察結果として、「より高度なモデルが、安全でないコードを提案する傾向」を挙げ、これは高度なLLMの開発において、セキュリティ対策を統合することの必要性を浮き彫りにしていると指摘している。

自動テストケース生成と評価パイプラインを備えるCyberSecEvalは、LLMの設計者や研究者に、LLMのサイバーセキュリティ安全性特性を幅広く測定し、強化するツールを提供し、より安全なAIシステムの開発に貢献すると、Metaは述べている。

危険なコンテンツ生成を防ぐLlama Guard

Llama 2の「責任ある使用のためのガイド」で概説されているように、Metaは、LLMへの全ての入力と出力が、アプリケーションに適したコンテンツガイドラインに従ってチェックされ、フィルタリングされることを推奨している。

Llama Guardは、これを支援するためにリリースされた。人間とAIの会話ユースケースに対応したLLMベースの入出力セーフガードモデルであり、安全リスクの分類法が組み込まれている。これにより、LLMのプロンプトに見られる安全リスクの特定のセットを分類できる(つまり、プロンプトを分類できる)。

この分類法は、プロンプトに対するLLMの応答を分類する際にも役立つ。Metaは、プロンプト分類と応答分類の両方のために、質の高いデータセットを収集し、これを用いてLlama Guardをトレーニングした。

Llama Guardは、OpenAI Moderation EvaluationデータセットやToxicChatなど、既存ベンチマークで強力な性能を発揮する。その性能は、現在利用可能なコンテンツモデレーションツールと同等かそれ以上だ。

Metaは、Llama Guardの方法論とその性能に関する詳細な考察を、論文で公開している。最終的に、開発者がユースケースに応じてLlama Guardをカスタマイズしたり、ベストプラクティスを採用しやすくしたりすることを目指している。

オープンエコシステム

Metaは、従来のオープンアプローチに沿って、最近発足したAI Allianceや、AMD、AWS(Amazon Web Services)、Google Cloud、Hugging Face、IBM、Intel、Lightning AI、Microsoft、MLCommons、NVIDIA、Scale AIなど、多くの企業や組織とパートナーを組み、これらのツールを改良し、オープンソースコミュニティーが活用できるようにすることを楽しみにしていると述べている。

関連記事

MetaやIBMなど50以上の組織が、オープンかつ安全で責任あるAIを推進する「AI Alliance」を創設

MetaやIBMなど50以上の組織が、オープンかつ安全で責任あるAIを推進する「AI Alliance」を創設

MetaやIBMなど50以上の組織が共同で、オープン、安全で責任あるAIを推進する「AI Alliance」を立ち上げた。 Googleが次世代AIモデルで「Geminiの時代へようこそ」、搭載Bardは日本でも使える

Googleが次世代AIモデルで「Geminiの時代へようこそ」、搭載Bardは日本でも使える

Googleが新AIモデルのGeminiをリリースした。人の専門家を超える能力を備えると同社が主張するGeminiは、日本でもBardで使えるようになっている。実力はどうなのか。 AWS、生成AIアシスタント「Amazon Q」を発表 プレビュー期間は無料で利用可

AWS、生成AIアシスタント「Amazon Q」を発表 プレビュー期間は無料で利用可

AWSは、ビジネスに特化し、業務に合わせてカスタマイズできる新タイプの生成AIアシスタント「Amazon Q」を発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ