Microsoft、小規模言語モデル「Phi-3」公開 大規模言語モデルと異なる利用シーンを想定:「小」規模言語モデルの持つ可能性

Microsoftは、自社開発の小規模言語モデル(SLM)ファミリー、「Phi-3」を発表した。シリーズ最小のパラメーター数の「Phi-3-mini」を公開し、Microsoft Azure AI Studio、Hugging Face、Ollamaで利用可能になった。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

Microsoftは4月23日(米国時間)、自社開発の小規模言語モデル(SLM)ファミリー、「Phi-3」を発表した。また、同日からPhi-3シリーズ最小となる38億個のパラメーターを持つ「Phi-3-mini」が「Microsoft Azure AI Studio」「Hugging Face」「Ollama」で利用可能になった。

Phi-3-miniの特徴

Phi-3-miniは4Kおよび128Kトークンの2種類のコンテキスト長で利用でき、128Kトークンまでのコンテキストウィンドウをサポートするモデルだ。このモデルはインストラクションチューニングされており、人々の通常のコミュニケーション方法を反映した、さまざまなタイプの指示に従うように訓練されている。

Azure AI上でPhi-3-miniを使用することで、モデルのdeploy-eval-finetuneツールチェーン(モデルのデプロイ、評価、ファインチューニング)ができるようになる。また、Ollamaでも利用可能で、開発者のラップトップでローカルでも実行できる。

Phi-3-miniは、ONNX(Open Neural Network Exchange)ランタイムと「Windows DirectML」を通じ、GPU、CPU、モバイルハードウェアにクロスプラットフォームで対応している。また、どこにでも展開できる標準APIインタフェースを備えたNVIDIA NIMマイクロサービスとしても利用できる。NVIDIA GPU向けの最適化も施されている。

加えて、近日中に「Phi-3-small」(70億パラメーター)と「Phi-3-medium」(140億パラメーター)などのPhi-3ファミリーのモデルが追加される。この2つのモデルはAzure AIモデルカタログとその他のモデルガーデン(機械学習モデルのリポジトリやコレクション)での公開が予定されている。

Phi-3のパフォーマンス

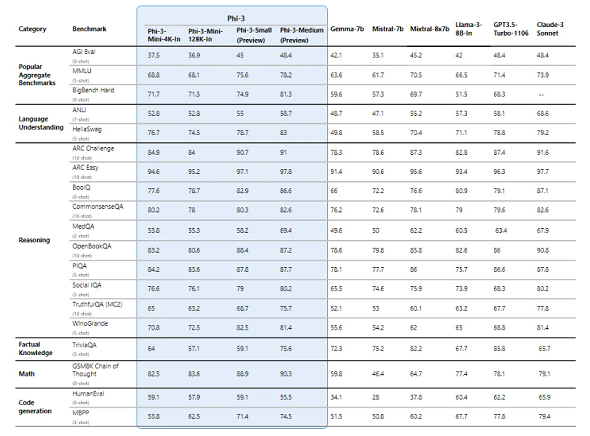

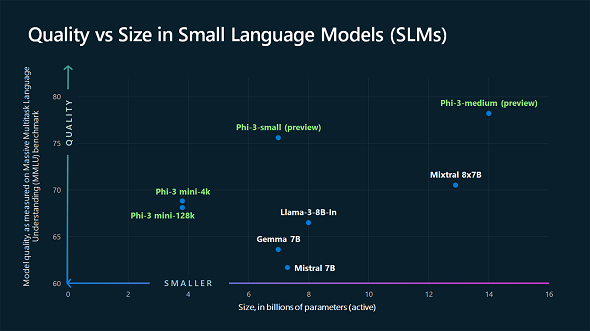

Microsoftによると、Phi-3は主要ベンチマークにおいて、同サイズおよびそれ以上のサイズの言語モデルよりも優れたパフォーマンスを示しているという(下図参照)。また、Phi-3-miniは、その2倍のサイズを持つモデルよりも優れており、Phi-3-smallおよびPhi-3-mediumは、GPT-3.5Tなどのはるかにサイズが大きいモデルを上回るとしている。

Phi-3の品質を表す図。Massive Multitask Language Understanding(MMLU)ベンチマークでパフォーマンスを計測し、同様のサイズの他社モデルと比較している(出典:Microsoft)

Phi-3の品質を表す図。Massive Multitask Language Understanding(MMLU)ベンチマークでパフォーマンスを計測し、同様のサイズの他社モデルと比較している(出典:Microsoft)モデル設計とトレーニングデータ

Phi-3は、MicrosoftのAI開発標準「Microsoft Responsible AI Standard」に基づいて開発された。これは、アカウンタビリティ、透明性、公平性、信頼性と安全性、プライバシーとセキュリティ、包括性の6つの原則に基づいている。Phi-3は、安全性の測定と評価、レッドチーム活動、機密利用のレビューを含む厳格なプロセスを経て開発され、Microsoftの基準とベストプラクティスに沿って開発、テスト、展開されている。

また、Phi-3はトレーニングに高品質のデータを使用している。人間のフィードバックからの強化学習(RLHF)、数十の被害カテゴリーにわたる自動テストと評価、手動のレッドチーム活動など、包括的な安全性のポストトレーニングが施されている。

小規模言語モデルが活用できるケース

Microsoftは「生成AIツール『Microsoft Copilot』を公開し、顧客がAzure AIを使用して生成AIでビジネスを変革できるようにした経験から、異なるタスクに対して品質とコストのバランスを考慮したさまざまなサイズのモデルの需要が増していることを把握した」と述べている。

Phi-3のような小規模言語モデルを採用するのに最適なケースとして、Microsoftは以下を挙げている。

- リソースが制約されている環境、特にデバイス内およびオフライン推論のシナリオ

- レイテンシに制約があり、高速な応答時間が重要なシナリオ

- コストに制約のあるユースケース、特に単純なタスクの場合

Phi-3は小型であるため、演算量に制限のある推論環境でも使用できる。特にPhi-3-miniは、ONNXランタイムで最適化されることで、デバイス上で使用できるようになる。また、Phi-3モデルのサイズが小さいため、より容易かつ手頃な価格でファインチューニングやカスタマイズができる。

Microsoftのソナリ・ヤダヴ氏(生成AI担当主任プロダクトマネージャー)は、「今後見られるようになるのは、大規模から小規模へのシフトではなく、モデルの単一カテゴリーからモデルのポートフォリオへのシフトだ。顧客は自分のシナリオに最適なモデルを決定できるようになるだろう」と述べている。

関連記事

Microsoft Research、小規模言語モデル(SLM)の「Phi-2」を発表 MITライセンスで商用利用も可能

Microsoft Research、小規模言語モデル(SLM)の「Phi-2」を発表 MITライセンスで商用利用も可能

Microsoft Researchは、小規模言語モデル(SLM)の「Phi-2」を発表した。27億パラメーターを持つ言語モデルだが、最大25倍の大規模言語モデルに匹敵する性能を持つとしている。 Meta、次世代オープンLLM「Meta Llama 3」を発表

Meta、次世代オープンLLM「Meta Llama 3」を発表

Metaは、大規模言語モデル「Meta Llama 3」の8Bおよび70Bパラメーターモデルを発表した。 Red Hatが誰でもLLM開発に貢献できるオープンソースプロジェクト、「InstructLab」を発表

Red Hatが誰でもLLM開発に貢献できるオープンソースプロジェクト、「InstructLab」を発表

Red HatがオープンソースLLMをさらにオープンソース化するプロジェクト、「InstructLab」を開始した。誰でもLLM開発に参加することができ、「生成AIの未来をともに形作れる」と訴えている。まずIBM Researchの「Granite」モデルなどから始める。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ