Meta、大規模言語モデル「Llama」の最新版「Llama 4」を発表 3つのモデルを提供開始 それぞれの違いとは:合計200言語で事前トレーニング

Metaは、パーソナライズされたマルチモーダル体験の構築に使用できる大規模言語モデルシリーズ「Llama 4」の最初のモデルを発表した。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

Metaは2025年4月5日(米国時間)、パーソナライズされたマルチモーダル体験の構築に使用できる大規模言語モデル(LLM)シリーズ「Llama 4」の最初のモデルを発表した。

Metaは、「Llama 4 Scout」と「Llama 4 Maverick」を公開し、この2モデルの蒸留に使用したLlama 4教師モデル「Llama 4 Behemoth」(初期プレビュー段階にあり、トレーニング中)も発表した。

Llama 4 ScoutとLlama 4 Maverickは、llama.comとHugging Faceからダウンロードできる。また、Metaの「WhatsApp」「Messenger」「Instagram Direct」、Meta.AI Webサイトで、Llama 4に基づく「Meta AI」サービスを試すことができる。

Llama 4は、テキストおよびマルチモーダル体験を可能にするネイティブなマルチモーダルAI(人工知能)モデルだ。「最先端のインテリジェンスを備え、スピードと効率に優れている。『Mixture of Expert』(MoE:混合エキスパート)アーキテクチャを採用しており、テキストと画像の理解において業界をリードするパフォーマンスを提供する」と、Metaは述べている。

3つのモデルの特徴、それぞれの違いとは

Llama 4 Scout

Llama 4 Scoutは、170億(17B)のアクティブパラメーターと16のエキスパートを持つマルチモーダルモデルだ。これまでの全てのLlamaモデルよりも強力であり、単一のNVIDIA H100 GPUで実行できるという。

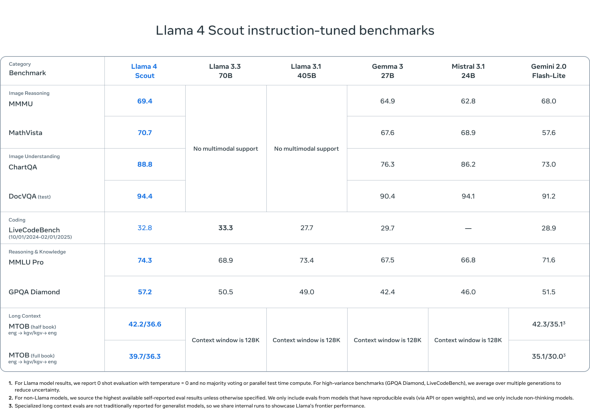

業界をリードする1000万(10M)トークンのコンテキストウィンドウを提供し、記憶、パーソナライゼーション、マルチモーダルアプリケーションなどのユースケースに対応する。広く報告されている幅広いベンチマークにおいて、「Gemma 3」「Gemini 2.0 Flash-Lite」「Mistral 3.1」を上回る結果を示している。

Llama 4 Maverick

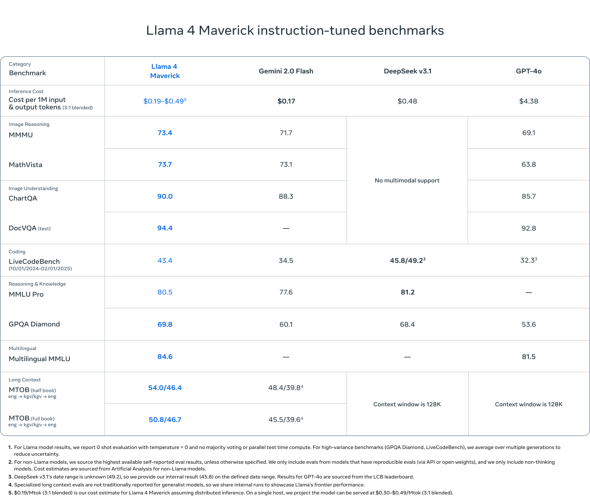

Llama 4 Maverickは、17Bのアクティブパラメーターと128のエキスパートを持つマルチモーダルモデルだ。広く報告されている幅広いベンチマークにおいて「GPT-4o」や「Gemini 2.0 Flash」を上回り、推論とコーディングでは新しい「DeepSeek v3」と同等の結果を達成している(半分以下のアクティブパラメーターで)。

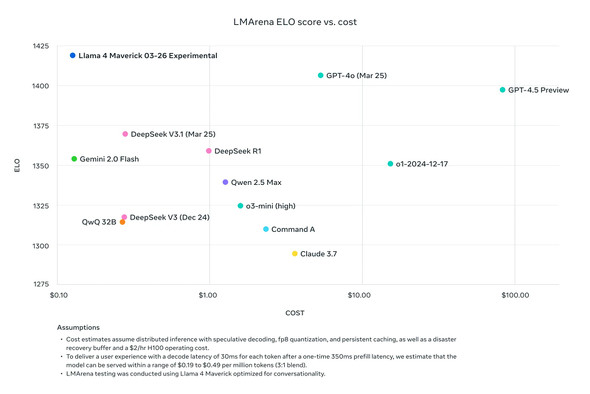

実験的チャットバージョンは、LMArenaでイロスコア1417を記録している。

Llama 4 Behemoth(トレーニング中の初期プレビュー版)

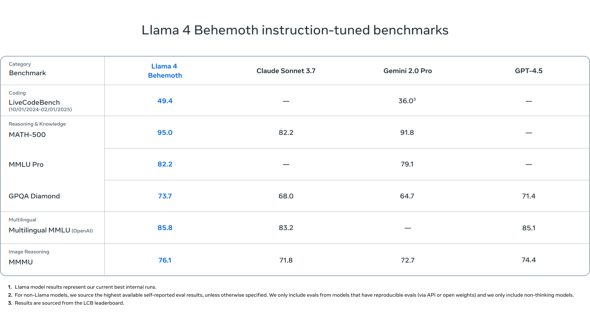

Llama 4 Behemothは、288Bのアクティブパラメーターと16のエキスパートを持つMetaの最も強力なモデルだ。Metaは「世界で最も賢いLLMの一つ」だと述べている。幾つかのSTEMベンチマークにおいて「GPT-4.5」「Claude Sonnet 3.7」「Gemini 2.0 Pro」を上回る性能を示している。

| モデル | トレーニングデータ | パラメーター | 入力モダリティ | 出力モダリティ | コンテキストウィンドウ(トークン数) | 事前トレーニングに使用されたマルチモーダルデータのトークン数 | ナレッジカットオフ(事前トレーニングに使用されたデータの最終更新時期) |

|---|---|---|---|---|---|---|---|

| Llama 4 Scout(17Bx16E) | 一般に入手可能なライセンス取得済みデータと、Metaの製品およびサービスからの情報の組み合わせ。InstagramやFacebookで公開、共有されている投稿や、Meta AIとのユーザーのやりとりを含む。 | 17B(アクティブ)/ 109B(合計) | 多言語テキストと画像 | 多言語テキストとコード | 最大10M | 〜40T | 2024年8月 |

| Llama 4 Maverick(17Bx128E) | 17B(アクティブ)/ 400B(合計) | 多言語テキストと画像 | 多言語テキストとコード | 1M | 〜22T | ||

| Llama 4 ScoutとLlama 4 Maverickの比較(提供:Meta) | |||||||

Metaは、Llama 4 Maverickが同クラスの類似モデルを上回るパフォーマンスを、極めて低コストで開発者に提供することを示すため、以下のグラフを紹介している。

モデルの量子化

Llama 4 ScoutはBF16(16bit)ウェイトとしてリリースされているが、int4形式に変換(量子化)することで、単一のNVIDIA H100 GPUで実行可能なサイズに収められるという。

Llama 4 Maverickは、BF16量子化およびFP8(8bit)量子化ウェイトとしてリリースされている。FP8量子化ウェイトは、品質を維持しながら単一の「NVIDIA H100 DGX」で実行できるとしている。

多言語対応

Llama 4では以下の12言語がサポートされているが、合計200言語で事前トレーニングされている。開発者はLlama 4のライセンスと使用ポリシーを順守する限り、以下の12言語以外の言語のためにLlama 4をファインチューニングできる。

- アラビア語

- 英語

- フランス語

- ドイツ語

- ヒンディー語

- インドネシア語

- イタリア語

- ポルトガル語

- スペイン語

- タガログ語

- タイ語

- ベトナム語

関連記事

Meta、「Llama 3.2」を公開 新たに追加されたビジョンモデルと軽量モデルはどう使える?

Meta、「Llama 3.2」を公開 新たに追加されたビジョンモデルと軽量モデルはどう使える?

Metaは、同社の大規模言語モデルの最新版「Llama 3.2」を提供開始した。中小規模のビジョンモデル(11Bと90B)と、エッジデバイスやモバイルデバイスに搭載可能な軽量のテキスト専用モデル(1Bと3B)をラインアップしている。 Meta、オープンLLMの最新版「Llama 3.1」を発表 「4050億パラメーターモデル」が利用可能に

Meta、オープンLLMの最新版「Llama 3.1」を発表 「4050億パラメーターモデル」が利用可能に

MetaはオープンLLMの最新版「Llama 3.1」を公開した。llama.meta.comとHugging Faceから無料でダウンロードできる。MetaのCEOであるマーク・ザッカーバーグ氏はLlama 3.1の公開に合わせて声明を発表し、オープンなAIの展望を語った。 Meta、次世代オープンLLM「Meta Llama 3」を発表

Meta、次世代オープンLLM「Meta Llama 3」を発表

Metaは、大規模言語モデル「Meta Llama 3」の8Bおよび70Bパラメーターモデルを発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ